Privacidade por design: como vender privacidade e fazer alterações

Publicados: 2022-03-10A privacidade é um direito humano fundamental que nos permite sermos nós mesmos. É o que nos permite ser esquisitos sem vergonha. Permite-nos ter opiniões divergentes sem consequências. E, em última análise, é o que nos permite ser livres. É por isso que muitas nações têm leis rígidas sobre privacidade. No entanto, apesar desse entendimento comum, a privacidade na Internet é um dos tópicos menos compreendidos e mal definidos até o momento , pois abrange uma vasta gama de questões, tomando forma de muitas formas diferentes, o que torna incrivelmente difícil identificar e discutir . No entanto, gostaria de tentar resolver essa ambiguidade.

Nos Estados Unidos, é crime federal abrir a correspondência de alguém. Isso é considerado uma violação criminal de privacidade que pode levar alguém à prisão por até cinco anos. Metaforicamente falando, cada dado que criamos na Internet – seja foto, vídeo, texto ou qualquer outra coisa – pode ser pensado como um pacote de correspondência. No entanto, ao contrário de abrir nossa correspondência na vida real, as empresas de Internet podem abrir legalmente todas as correspondências que são entregues por meio de seu sistema sem consequências legais. Além disso, eles podem fazer cópias dele também. O que essas empresas estão fazendo seria comparável a alguém abrindo nossa correspondência, copiando-a na Kinkos, armazenando-a em um arquivo com nosso nome e compartilhando-a com qualquer pessoa disposta a pagar por ela. Quer abrir aquele arquivo ou deletar algumas das cópias? Que pena. Atualmente, nosso correio é considerado propriedade deles e quase não temos controle sobre como ele é usado .

Você poderia imaginar a indignação que o público sentiria se descobrisse que o serviço postal estava mantendo sua correspondência como refém e vendendo-a para quem estivesse disposto a pagar? O que está acontecendo com os dados na Internet não é diferente, e é hora de isso mudar.

É mais do que apenas uma questão de ética que isso aconteça, é uma questão de direitos humanos básicos.

O problema de fazer as mudanças que precisam ser feitas (sem que as mudanças sejam impostas pela regulamentação) é colocar cifrões nas questões. Qual é o retorno financeiro de um investimento de 20.000 horas em engenharia para melhorar os padrões de privacidade do consumidor? Os consumidores estão exigindo essas mudanças? Porque se não dá retorno fiscal e os consumidores não estão exigindo, então por que mudar? E mesmo que sejam e haja um retorno, como são 20.000 horas de investimento? O que será colocado no roadmap do produto e quando? Todas essas são preocupações válidas que precisam ser abordadas para nos ajudar a avançar de forma eficaz. Então, vamos discutir.

Leitura recomendada : Usando a Ética no Web Design

Os consumidores querem?

A resposta a esta pergunta é um duro sim. As descobertas do Pew Research Center mostram que 90% dos adultos nos Estados Unidos acreditam que é importante ter controle sobre quais informações são coletadas sobre eles, 93% acreditam que é importante controlar quem tem acesso a essas informações e 86% têm tomaram medidas para remover ou mascarar suas pegadas digitais. Números semelhantes foram descobertos sobre os europeus no relatório de Atitudes Digitais de 2018 da doteveryone. Apesar desses números, 59% ainda sentem que é impossível permanecer anônimo online, 68% acreditam que as leis atuais não fazem o suficiente para proteger sua privacidade e apenas 6% estão “muito confiantes” de que as agências governamentais podem mantê-las seguras.

Agora, eu sei o que você está pensando. Essa é a demanda do consumidor, e até que esses consumidores comecem a deixar os produtos antigos para trás, não há razão fiscal para fazer qualquer mudança. E (embora eu não concorde com sua lógica) você está certo. No momento, há poucas razões fiscais para fazer qualquer mudança. No entanto, quando a demanda do consumidor atinge uma massa crítica, as coisas sempre mudam. E as empresas que lideram o caminho antes que a mudança seja exigida sempre vencem no longo prazo. Aqueles que se recusam a fazer uma mudança até serem forçados a sempre sentir mais dor . A história mostra que isso é verdade. Mas o que vai acontecer na legislação que vai mudar tanto os negócios? Ótima pergunta.

O que está prestes a acontecer com os padrões de proteção de dados e privacidade em todo o mundo, por meio de regulamentação, não será tão diferente do que ocorreu há menos de uma década, quando os consumidores exigiram proteção contra e-mails de spam, o que resultou na Lei CAN-SPAM nos Estados Unidos – mas em uma escala muito maior e com impacto exponencialmente maior. Essa legislação, que foi criada porque os consumidores estavam cansados de receber e-mails de spam, estabeleceu as regras para e-mail comercial, estabeleceu requisitos para mensagens comerciais, deu aos destinatários o direito de fazer com que indivíduos e empresas parassem de enviá-los e especificou penalidades duras para violações. À medida que entramos em um período em que os consumidores estão começando a entender o quanto foram enganados (por anos, dar às pessoas o controle íntimo de seus dados será, sem dúvida, o futuro da coleta de dados) – seja por meio do livre arbítrio ou da legislação. E aqueles que escolherem se mover primeiro vencerão. Não acredite em mim?

Considere o fato de que os engenheiros podem ter problemas legais pelo código que escrevem. Dados do Apple Watch, Alexa e FitBit, entre outros, têm sido usados como prova em tribunal, mudando a percepção do consumidor sobre seus dados. A Microsoft e a Suprema Corte dos Estados Unidos foram ao tribunal no início deste ano para definir onde as fronteiras físicas se estendem em atividades criminosas baseadas em nuvem, o início de uma longa luta. Esses exemplos são apenas uma prévia do que está por vir. As pessoas estão exigindo mais e estamos chegando ao ponto de inflexão.

O primeiro a tomar medidas para responder a essa demanda é a UE, que estabeleceu o GDPR, e agora os formuladores de políticas de outros países estão começando a seguir o exemplo, trabalhando em leis em seu país para definir nosso futuro cibernético. Por exemplo, o vice-presidente do Comitê de Inteligência do Senado dos Estados Unidos, Mark Warner, apresentou recentemente algumas ideias em um relatório resumido há apenas alguns meses, demonstrando para onde a legislação pode em breve nos Estados Unidos. Mas não são apenas os progressistas que acreditam que este seja o futuro; até influenciadores de direita como Steve Bannon acham que precisamos de regulamentação.

O que estamos vendo é uma reação humana a uma manipulação incrível. Não importa o quão domesticados possamos ser em comparação com as gerações anteriores, as pessoas sempre reagirão quando sentirem que estão sendo ameaçadas. É uma reação natural que nos permitiu sobreviver por milênios. Hoje, a tecnologia se tornou mais do que apenas uma indústria voltada para o consumidor. Agora também está se tornando uma questão de segurança nacional . E por esta razão, haverá uma reação, gostemos ou não. E será melhor se sairmos com uma estratégia de preparação em vez de sermos varridos para debaixo do tapete. Então, qual é o retorno financeiro que você pergunta? Bem, quanto vale o seu negócio? Isso é quanto.

Leitura recomendada : Como o GDPR mudará a maneira como você se desenvolve

Para uma estrutura simples do que exatamente precisa ser abordado e por quê, podemos considerar várias verdades fundamentais na criação de sistemas digitais:

- A privacidade deve ser proativa, não reativa, e deve antecipar os problemas de privacidade antes que eles cheguem ao usuário.

Essas questões não são questões com as quais queremos lidar depois que um problema ganha vida, mas são questões que queremos evitar inteiramente, se possível. - Privacidade deve ser a configuração padrão.

Não existe a opção “melhor para os negócios” em relação à privacidade; essa é uma questão que trata do que é melhor para o consumidor, o que, no longo prazo, será melhor para o negócio. Podemos ver o que acontece quando falhas coercitivas são expostas ao público através do que aconteceu com Paypal e Venmo em agosto de 2018, quando Public by Default foi lançado ao público, trazendo um punhado de má imprensa para a marca. Mais disso certamente virá para as empresas que esperam que algo ruim aconteça antes de fazer uma mudança. - A privacidade deve ser soma positiva e deve evitar dicotomias.

Não há relação binária com a privacidade; é uma questão sempre maleável que precisa de supervisão constante e iteração perpétua. Nosso trabalho não termina nos termos e no contrato de serviço, ele dura para sempre e deve ser considerado um elemento fundamental do seu produto que evolui com o produto e permite que os consumidores se protejam – não um que se aproveite de sua falta de compreensão. - Os padrões de privacidade devem ser visíveis, transparentes, abertos, documentados e verificáveis de forma independente.

Não há uma ótima maneira de definir um teste decisivo para seus padrões de privacidade, mas algumas perguntas que todos nós devemos nos fazer como empresários: Primeiro, se a imprensa publicasse seu acordo de privacidade, seria compreensível? Em segundo lugar, se fosse compreensível, os consumidores apreciariam o que leem? E por último, mas não menos importante, se não, o que você precisa mudar?

Esses princípios serão fundamentos altamente valiosos a serem lembrados à medida que os produtos são criados e evoluem. Eles representam perguntas rápidas e fáceis de fazer a si mesmo e à sua equipe que permitirão que você tenha uma boa base de ética, mas para um artigo mais longo sobre fundamentos legais, você pode ler mais de Heather Burns, que delineou vários princípios adicionais no ano passado em Smashing. E para obter uma lista completa de itens a serem inspecionados durante uma Avaliação de Impacto de Privacidade (PIA), você também pode verificar como as avaliações são feitas de acordo com:

- Gabinete do Comissário de Informação do Reino Unido (ICO)

- O Escritório do Comissário de Privacidade do Canadá

- Departamento de Segurança Interna dos Estados Unidos

Mas antes de correr para fazer mudanças em seu produto, primeiro vamos apontar algumas das falhas atuais e falar sobre como as mudanças podem parecer uma vez que sejam implementadas corretamente.

Como fazer mudanças

Um dos maiores problemas com as práticas de privacidade dos EUA é a dificuldade de entender os termos e acordos de serviço (T&S), que desempenham um papel importante na definição de privacidade, mas tendem a fazê-lo muito mal. Atualmente, os usuários são forçados a ler longos documentos cheios de linguagem jurídica e jargão técnico se quiserem entender com o que estão concordando. Um estudo realmente demonstrou que levaria aproximadamente 201 horas (quase dez dias) por ano para uma pessoa comum ler todas as políticas de privacidade que encontra anualmente . Os pesquisadores estimaram que o valor desse tempo perdido seria de quase US$ 781 bilhões por ano, o que é inaceitável, considerando que essas são as regras que deveriam proteger os consumidores – regras que são apresentadas como fáceis e digeríveis. Isso coloca os consumidores em uma posição em que são forçados a optar por participar sem realmente entender no que estão se metendo. E em muitos casos nem é a linguagem jurídica que é coercitiva, é a forma como as opções são dadas, em geral, como claramente comprovado em várias experiências:

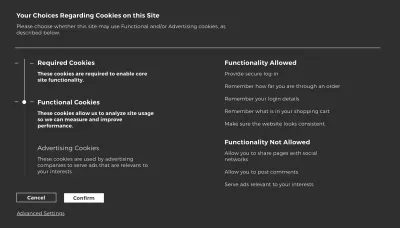

O exemplo dado acima é um wireframe genérico, mas optei por fazer isso porque todos já vimos padrões como esse e outros semelhantes relacionados à coleta de tipos mais específicos de dados. Eu poderia listar exemplos específicos, mas a lista continuaria para sempre e não há razão para listar empresas específicas que demonstram padrões manipuladores porque esses padrões (e outros padrões muito semelhantes) podem ser encontrados em quase todos os sites ou aplicativos da Internet. Há um grande problema em pedir consentimento dessa maneira: os consumidores não podem não aceitar termos e serviços sem várias etapas extras, muita leitura e muitas vezes muito mais. Essa é uma falha fundamental que precisa ser abordada porque pedir consentimento significa que precisa haver uma opção de dizer não e, para saber se “não” é a melhor opção, os consumidores precisam entender com o que estão consentindo. No entanto, os produtos não são construídos dessa forma. Por quê? Bem, é melhor para os negócios.

Se realmente sentarmos e pensarmos sobre isso, o que é fácil de ver, mas não reconhecemos, é que as empresas gastam mais tempo criando páginas iniciais para explicar como usar o aplicativo do que nós para explicar quais dados estão sendo coletados e por quê. Por quê? Mudanças simples na forma como os acordos de T&S são feitos não apenas tornariam os consumidores mais conscientes do que estão assinando, mas também permitiriam que fossem consumidores mais responsáveis . Podemos ver algumas dessas mudanças já sendo feitas devido ao impacto que o GDPR vem causando em todo o mundo. Em muitos países europeus, não é incomum que o consentimento seja solicitado por meio de modais como estes:

Este primeiro exemplo é um bom passo em frente. Ele informa ao consumidor para que seus dados serão usados, mas ainda falta transparência sobre para onde os dados vão e dá prioridade ao contrato sem a opção de recusar. Ele também agrupa tudo em um único corpo de texto, o que torna a informação muito menos digerível.

Um exemplo melhor de como isso pode ser projetado é algo como o modal abaixo, que agora é comum entre muitos sites europeus:

Isso dá aos consumidores uma compreensão abrangente de para que seus dados serão usados e o faz de maneira digerível. No entanto, ainda carece de informações significativas sobre para onde os dados irão após o consentimento. Não há uma única pista sobre onde seus dados serão compartilhados, com quem serão compartilhados e quais limitações existem nesses acordos. Embora isso seja muito melhor do que a maioria das opções na web, ainda há melhorias a serem feitas.

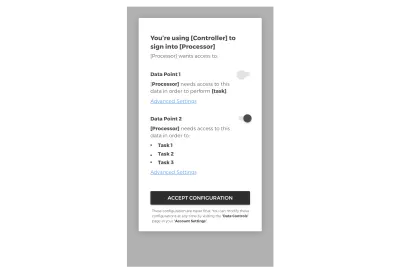

Solicitação de login de terceiros

Por exemplo, ao usar um serviço de terceiros para fazer login em sua plataforma, os consumidores devem estar cientes do seguinte:

- Quais dados serão retirados do terceiro;

- Para que está sendo usado e como isso pode afetar a experiência deles se você não tiver acesso a ele;

- Quem mais tem ou pode ter acesso a ele.

Para implementar isso de uma maneira que dê controle ao consumidor, essa experiência também deve permitir que os consumidores optem por partes individuais da coleção, não sendo forçados a concordar com tudo ou com nada.

Isso tornaria os T&S digeríveis e permitiria que os consumidores optassem pelo que realmente concordam, não pelo que a empresa deseja que eles concordem. E para ter certeza de que é realmente opt-in, o padrão deve ser definido como opt-out. Esta seria uma pequena mudança que faria uma diferença dramática na forma como o consentimento é solicitado. Hoje, a maioria das empresas cobre esse conteúdo em jargão jurídico para esconder o que realmente lhes interessa, mas os dias de pedir consentimento dessa maneira estão rapidamente chegando ao fim.

Se você está fornecendo aos consumidores um serviço significativo e fazendo isso de forma ética, essas mudanças não devem ser um problema. Se houver um valor real para o serviço, os consumidores não vão resistir ao seu pedido. Eles só querem saber em quem podem ou não confiar, e este é um passo simples que pode ajudar sua empresa a provar sua confiabilidade.

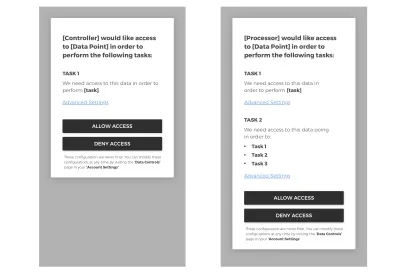

Solicitações de coleta de dados de ponto único e multiponto

Em seguida, quando se trata de criar acordos de T&S compreensíveis para sua plataforma, temos que considerar como isso pode ocorrer de forma mais contextual – dentro da experiência do aplicativo. Tenha em mente que, se tudo for dado de antemão, isso não é digerível. Por esse motivo, a solicitação de coleta de dados deve acontecer contextualmente , quando o consumidor estiver prestes a utilizar parte do seu serviço que requer uma camada extra de dados a ser coletada.

Para demonstrar como essa solicitação pode ocorrer, aqui estão alguns exemplos de como uma solicitação de coleta de dados de ponto único e de vários pontos pode ser:

Dividir os T&S em pontos de interação digeríveis dentro da experiência, em vez de pedir ao usuário tudo de antemão, permite que eles entendam melhor o que está acontecendo e por quê. Se você não precisa dos dados para melhorar a experiência, por que eles estão sendo coletados? E se está sendo coletado por motivos frívolos que só beneficiam a empresa, então seja honesto. Isso é apenas honestidade básica, que infelizmente é considerada um serviço ao cliente revolucionário e progressivo no mundo moderno.

A maior chave para essas perguntas iniciais é que nada disso deve ser opt-in por padrão . Todos os acionadores iniciais devem permitir que as pessoas que usam a ferramenta optem por participar, se quiserem, e usá-la sem optar, se quiserem. Os dias do opt-in forçado (ou, pior ainda, opt-in coercitivo) estão chegando a um fim abrupto, e aqueles que lideram o caminho permanecerão à frente do pacote por muito tempo.

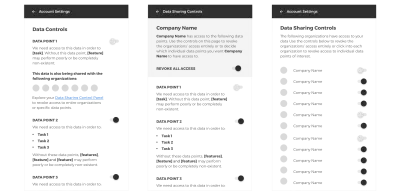

Centro de Controle de Dados

Além de pedir consentimento de forma significativa, também será importante darmos aos consumidores a capacidade de controlar seus dados post-hoc. O acesso dos consumidores ao controle de seus dados não deve terminar nos termos e no contrato de serviço. Em algum lugar em seus controles de conta, também deve haver um local (ou locais) onde os consumidores possam controlar seus dados na plataforma depois de investirem tempo com o serviço. Esta área deve mostrar a eles quais dados estão sendo coletados, com quem estão sendo compartilhados, como eles podem removê-los e muito mais.

A ideia de controle total de dados pode parecer incrivelmente liberal, mas sem dúvida é o futuro. E como propriedade do consumidor que cria os dados, deve ser considerado um direito humano básico. Não há razão para que isso seja um debate neste momento da história. Os dados representam a história de nossas vidas – coletivamente – e combinados criam uma grande quantidade de poder contra aqueles que os criam, especialmente se permitirmos que os sistemas permaneçam caixas pretas. Portanto, além de dar aos consumidores acesso aos seus dados, como discutimos nas seções anteriores, também precisaremos tornar a experiência mais compreensível para que os consumidores possam se defender.

Criar IA explicável

Embora seja incrível obter um resultado sugerido que nos mostre as coisas que queremos antes mesmo de sabermos que as queríamos, isso também coloca as máquinas em uma posição poderosa que elas ainda não estão prontas para sustentar sozinhas. Quando as máquinas são posicionadas como especialistas e funcionam em um nível inteligente o suficiente para passar como tal, o público geralmente confia nelas até que falhem. No entanto, se as máquinas falharem de uma maneira que o público é incapaz de entender, elas permanecerão especialistas apesar de sua falha, que é uma das maiores ameaças à humanidade.

Por exemplo, se alguém usar uma ferramenta de busca visual para identificar a diferença entre um cogumelo comestível e um cogumelo venenoso e não souber que a máquina lhe disse que um cogumelo venenoso é seguro, essa pessoa pode morrer. Ou o que acontece quando uma máquina determina o resultado de um processo judicial e não é obrigada a fornecer uma explicação para sua decisão? Ou pior ainda, e quando essas tecnologias são usadas para fins militares e recebem o direito de usar força letal? Essa última situação pode parecer extrema, mas é uma questão que está sendo debatida atualmente nas Nações Unidas.

Para garantir que o público seja capaz de entender o que está acontecendo nos bastidores, precisamos criar o que a DARPA chama de inteligência artificial explicável (XAI) – ferramentas que explicam como as máquinas tomam suas decisões e a precisão com que essas tarefas foram realizadas. Não se trata de revelar segredos comerciais, mas de permitir que os consumidores sintam que podem confiar nessas máquinas e se defender se ocorrer um erro.

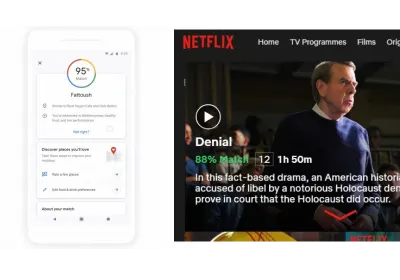

Embora não seja baseado em inteligência artificial, um bom exemplo de como isso pode ser é o CreditKarma, que permite que as pessoas tenham uma melhor compreensão de sua pontuação de crédito – um sistema que costumava ficar oculto como os algoritmos de hoje. Essa ferramenta permite que os consumidores tenham uma melhor compreensão do que está acontecendo nos bastidores e debata a legitimidade de seus resultados caso acreditem que o sistema falhou. Ferramentas semelhantes estão sendo criadas com sistemas como a pontuação do Google Match no Maps e o Netflix Percent Match em programas, mas esses sistemas estão apenas começando a arranhar a superfície da IA explicável.

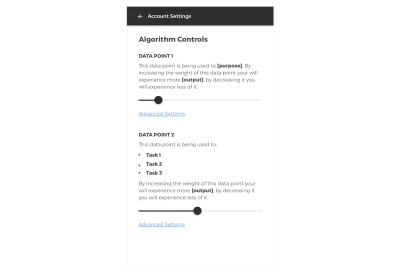

Apesar desses esforços, a maioria dos algoritmos hoje dita nossa experiência com base no que uma empresa acha que queremos. Mas os consumidores não devem mais ser controlados de forma invisível por grandes corporações de capital aberto. Os consumidores devem ter o direito de controlar seu próprio algoritmo . Isso pode ser algo tão simples quanto deixá-los saber quais variáveis são usadas para quais partes da experiência e como a alteração dos pesos de cada variável afetará sua experiência, dando-lhes a capacidade de ajustar isso até que atenda às suas necessidades - incluindo transformar o algoritmo completamente, se é isso que eles preferem. Se isso seria um recurso pago ou gratuito ainda está em debate, mas o que não é discutível é se essa liberdade deve ser oferecida.

Embora o exemplo acima seja uma proposta genérica, ele começa a imaginar como poderíamos fazer a experiência em situações mais específicas. Ao dar aos consumidores a capacidade de entender seus dados, a forma como estão sendo usados e como isso afeta suas vidas, teremos projetado um sistema que coloca os consumidores no controle de sua própria liberdade.

No entanto, não importa quão bem essas mudanças sejam feitas, também devemos perceber que dar às pessoas um melhor controle de sua privacidade não implica automaticamente em um ambiente mais seguro para os consumidores. Na verdade, pode piorar as coisas. Estudos mostraram que dar às pessoas um melhor controle de seus dados, na verdade, aumenta a probabilidade de elas fornecerem informações mais confidenciais . E se o consumidor não sabe como esses dados podem ser usados (mesmo que saiba onde está sendo compartilhado), isso o coloca em perigo. Nesse sentido, dar aos consumidores um melhor controle de seus dados e esperar que isso torne a Internet mais segura é como colocar um rótulo nutricional em um Snickers e esperar que ele torne a barra de chocolate menos gordurosa. Não vai, e as pessoas ainda vão comê-lo.

Embora eu acredite que os consumidores tenham o direito fundamental a melhores controles de privacidade e maior transparência, também acredito que é nosso trabalho, como tecnólogos com conhecimento de dados, não apenas construir sistemas melhores, mas também ajudar o público a entender a segurança na Internet. Portanto, o último passo para reunir isso é conscientizar o fato de que o controle não é tudo o que os consumidores precisam. Eles também precisam entender o que está acontecendo no back-end – e por quê. Isso não significa necessariamente fornecer o código-fonte ou fornecer seus IPs, mas pelo menos fornecer informações suficientes para entender o que está acontecendo em um nível básico, por uma questão de segurança. E para conseguir isso, precisaremos ir além de nossas telas. Precisaremos estender nosso trabalho às nossas comunidades e ajudar a criar esse futuro.

Leitura recomendada : Design Ethics: Shifting Ethical Understanding in Design

Incentivar a mudança

Desistir da privacidade é algo em que a população foi encurralada devido aos monopólios que existem no mundo da tecnologia, à incompreensão dos consumidores sobre por que isso é tão perigoso e à falta de soluções táticas associadas aos retornos fiscais. No entanto, este é um problema que precisa ser resolvido. Como Barack Obama observou no resumo de seu governo sobre as preocupações com a privacidade na Internet:

“Uma coisa deve ficar clara: embora vivamos em um mundo em que compartilhamos informações pessoais mais livremente do que no passado, devemos rejeitar a conclusão de que a privacidade é um valor ultrapassado. Ela está no centro de nossa democracia desde o início, e precisamos dela agora mais do que nunca”.

Criar experiências de compartilhamento de dados confiáveis e seguras será um dos maiores desafios que nosso mundo enfrentará nas próximas décadas.

Podemos ver como as ações do Facebook caíram 19% em um dia depois de anunciar que vão se concentrar novamente nos esforços de privacidade como prova de quão difícil pode ser fazer essas mudanças. Isso porque os investidores que recentemente se concentraram no crescimento da receita no curto prazo sabem o quanto as empresas precisam implementar melhores estratégias, mas também percebem o custo envolvido se o público começar a questionar um negócio – e a declaração pública do Facebook admitindo isso assustou as ovelhas .

Embora o processo não seja fácil (e muitas vezes pode ser doloroso), todos sabemos que a privacidade é o ponto fraco da tecnologia e é hora de mudar isso. As decisões que estão sendo tomadas hoje renderão grandes recompensas a longo prazo; uma diferença gritante para a mentalidade trimestral de curto prazo que passou a dominar os negócios na última década de crescimento. Assim, descobrir maneiras criativas de tornar essas questões uma prioridade para todas as partes interessadas deve ser considerado essencial para empresas e formuladores de políticas, o que significa que nosso trabalho como tecnólogos precisa se estender além da sala de reuniões.

Por exemplo, uma ótima forma de incentivar essas mudanças além de discutir os números e questões levantadas neste artigo seria por meio de incentivos fiscais para empresas que destinam grande parte de seu orçamento para melhorar seus sistemas. Intervalos podem ser dados a empresas que decidam fornecer treinamento ou workshops regulares para seus funcionários para ajudar a tornar a privacidade e a segurança uma prioridade na cultura da empresa. Eles podem ser dados a empresas que contratam hackers profissionais para encontrar brechas em seus sistemas antes que os ataques ocorram. Eles podem ser concedidos àqueles que alocam grandes quantidades de horas para reestruturar suas práticas de negócios de uma forma que beneficie os consumidores. Nesse sentido, tais incentivos não seriam tão diferentes dos incentivos fiscais concedidos às empresas que implementam práticas ecologicamente corretas.

A ideia de isenções fiscais pode parecer ultrajante para alguns, mas incentivos como esses representam uma solução mais proativa do que a maneira como as coisas são tratadas agora. Embora possa ser bom ler uma manchete dizendo “O Google multou um recorde de US$ 5 bilhões pela UE por violações antitruste do Android”, devemos ter em mente que multas como essa representam apenas uma pequena fração da receita dessas empresas. Combine isso com o fato de que a maioria dos casos leva vários anos ou décadas para ser concluída, e essa porcentagem só diminui. Com isso em consideração, a ideia de incentivos fiscais pode ser abordada de uma perspectiva diferente, ou seja, não se trata de recompensar comportamentos anteriormente negligentes, mas de aumentar a segurança pública de uma maneira que seja do melhor interesse de todos os envolvidos . A manutenção do nosso sistema atual, que permite que as empresas avancem em processos judiciais enquanto continuam suas más práticas é tão, se não mais, perigoso do que não ter nenhuma lei.

Se você gostou de ler este artigo e acha que outros deveriam lê-lo também, por favor, ajude a divulgar.

Este artigo é o início de uma série de artigos sobre os quais escreverei dedicados à segurança na Internet, nos quais trabalharei para colocar números fiscais em padrões de design éticos para que nós, como tecnólogos, possamos mudar os negócios que estamos construindo e criar um melhor cultura em torno do desenvolvimento de experiências conectadas à internet.