Começando com uma pilha JavaScript Express e ES6+

Publicados: 2022-03-10Este artigo é a segunda parte de uma série, com a primeira localizada aqui, que fornece informações básicas e (espero) intuitivas sobre Node.js, ES6+ JavaScript, funções de retorno de chamada, funções de seta, APIs, protocolo HTTP, JSON, MongoDB e mais.

Neste artigo, desenvolveremos as habilidades obtidas no anterior, aprendendo como implementar e implantar um banco de dados MongoDB para armazenar informações da lista de livros do usuário, construir uma API com Node.js e o framework Express Web Application para expor esse banco de dados e realizar operações CRUD nele, e muito mais. Ao longo do caminho, discutiremos a Destruição de Objetos ES6, a Abreviação de Objetos ES6, a sintaxe Async/Await, o Operador de Espalhamento e daremos uma breve olhada no CORS, na Política de Mesma Origem e muito mais.

Em um artigo posterior, refatoramos nossa base de código para separar as preocupações, utilizando a arquitetura de três camadas e alcançando a Inversão de controle via injeção de dependência, executaremos segurança e controle de acesso baseados em JSON Web Token e Firebase Authentication, aprenderemos como armazene senhas e empregue o AWS Simple Storage Service para armazenar avatares de usuários com buffers e fluxos Node.js — ao mesmo tempo em que utiliza o PostgreSQL para persistência de dados. Ao longo do caminho, reescreveremos nossa base de código do zero no TypeScript para examinar os conceitos de POO Clássica (como polimorfismo, herança, composição e assim por diante) e até mesmo padrões de design como fábricas e adaptadores.

Uma palavra de alerta

Há um problema com a maioria dos artigos que discutem o Node.js por aí hoje. A maioria deles, nem todos, não vão além de descrever como configurar o Express Routing, integrar o Mongoose e talvez utilizar a autenticação JSON Web Token. O problema é que eles não falam sobre arquitetura, ou melhores práticas de segurança, ou sobre princípios de codificação limpa, ou conformidade ACID, bancos de dados relacionais, quinta forma normal, o teorema CAP ou transações. Presume-se que você sabe sobre tudo isso que está chegando ou que não estará construindo projetos grandes ou populares o suficiente para garantir esse conhecimento mencionado acima.

Parece haver alguns tipos diferentes de desenvolvedores Node — entre outros, alguns são novos na programação em geral, e outros vêm de uma longa história de desenvolvimento empresarial com C# e o .NET Framework ou o Java Spring Framework. A maioria dos artigos atende ao primeiro grupo.

Neste artigo, vou fazer exatamente o que acabei de dizer que muitos artigos estão fazendo, mas em um artigo de acompanhamento, vamos refatorar totalmente nossa base de código, permitindo-me explicar princípios como injeção de dependência, três Arquitetura de camada (controlador/serviço/repositório), mapeamento de dados e registro ativo, padrões de design, unidade, integração e teste de mutação, princípios SOLID, unidade de trabalho, codificação contra interfaces, melhores práticas de segurança como HSTS, CSRF, NoSQL e SQL Injection Prevenção, etc. Também migraremos do MongoDB para o PostgreSQL, usando o construtor de consultas simples Knex em vez de um ORM — permitindo-nos construir nossa própria infraestrutura de acesso a dados e nos aproximarmos da Linguagem de Consulta Estruturada, os diferentes tipos de relações (One- para um, muitos para muitos, etc.) e muito mais. Este artigo, então, deve agradar aos iniciantes, mas os próximos devem atender a desenvolvedores mais intermediários que desejam melhorar sua arquitetura.

Neste, vamos nos preocupar apenas com a persistência dos dados do livro. Não lidaremos com autenticação de usuário, hash de senha, arquitetura ou qualquer coisa complexa assim. Tudo isso virá nos próximos e futuros artigos. Por enquanto, e basicamente, vamos apenas construir um método para permitir que um cliente se comunique com nosso servidor web através do protocolo HTTP para salvar as informações do livro em um banco de dados.

Nota : Eu intencionalmente o mantive extremamente simples e talvez não tão prático aqui porque este artigo, por si só, é extremamente longo, pois tomei a liberdade de me desviar para discutir tópicos suplementares. Assim, melhoraremos progressivamente a qualidade e a complexidade da API ao longo desta série, mas, novamente, como estou considerando isso como uma de suas primeiras apresentações ao Express, estou intencionalmente mantendo as coisas extremamente simples.

- Desestruturação de Objetos ES6

- Abreviação de Objeto ES6

- Operador de Spread ES6 (...)

- Chegando...

Desestruturação de Objetos ES6

ES6 Object Destructuring, ou Destructuring Assignment Syntax, é um método pelo qual extrair ou descompactar valores de arrays ou objetos em suas próprias variáveis. Começaremos com as propriedades do objeto e então discutiremos os elementos do array.

const person = { name: 'Richard P. Feynman', occupation: 'Theoretical Physicist' }; // Log properties: console.log('Name:', person.name); console.log('Occupation:', person.occupation); Essa operação é bastante primitiva, mas pode ser um pouco trabalhosa, considerando que temos que continuar referenciando person.something em todos os lugares. Suponha que houvesse 10 outros lugares em todo o nosso código onde tivéssemos que fazer isso - ficaria bastante árduo e rápido. Um método de brevidade seria atribuir esses valores às suas próprias variáveis.

const person = { name: 'Richard P. Feynman', occupation: 'Theoretical Physicist' }; const personName = person.name; const personOccupation = person.occupation; // Log properties: console.log('Name:', personName); console.log('Occupation:', personOccupation); Talvez isso pareça razoável, mas e se tivéssemos 10 outras propriedades aninhadas no objeto person também? Isso seria muitas linhas desnecessárias apenas para atribuir valores a variáveis - nesse ponto estamos em perigo porque se as propriedades do objeto forem alteradas, nossas variáveis não refletirão essa mudança (lembre-se, apenas referências ao objeto são imutáveis com atribuição const , não as propriedades do objeto), então basicamente, não podemos mais manter “estado” (e estou usando essa palavra vagamente) em sincronia. A passagem por referência versus passagem por valor pode entrar em jogo aqui, mas não quero me afastar muito do escopo desta seção.

A destruição de objetos ES6 basicamente nos permite fazer isso:

const person = { name: 'Richard P. Feynman', occupation: 'Theoretical Physicist' }; // This is new. It's called Object Destructuring. const { name, occupation } = person; // Log properties: console.log('Name:', name); console.log('Occupation:', occupation); Não estamos criando um novo literal de objeto/objeto, estamos descompactando as propriedades de name e occupation do objeto original e colocando-as em suas próprias variáveis de mesmo nome. Os nomes que usamos devem corresponder aos nomes das propriedades que desejamos extrair.

Novamente, a sintaxe const { a, b } = someObject; está dizendo especificamente que esperamos que alguma propriedade a e alguma propriedade b existam dentro de someObject (ou seja, someObject poderia ser { a: 'dataA', b: 'dataB' } , por exemplo) e que queremos colocar quaisquer que sejam os valores dessas chaves/propriedades dentro de variáveis const com o mesmo nome. É por isso que a sintaxe acima nos forneceria duas variáveis const a = someObject.a e const b = someObject.b .

O que isso significa é que existem dois lados da Destruição de Objetos. O lado “Template” e o lado “Source”, onde o lado const { a, b } (o lado esquerdo) é o template e o lado someObject (o lado direito) é o lado da fonte — o que faz sentido — estamos definindo uma estrutura ou “modelo” à esquerda que espelha os dados do lado “fonte”.

Novamente, apenas para deixar isso claro, aqui estão alguns exemplos:

// ----- Destructure from Object Variable with const ----- // const objOne = { a: 'dataA', b: 'dataB' }; // Destructure const { a, b } = objOne; console.log(a); // dataA console.log(b); // dataB // ----- Destructure from Object Variable with let ----- // let objTwo = { c: 'dataC', d: 'dataD' }; // Destructure let { c, d } = objTwo; console.log(c); // dataC console.log(d); // dataD // Destructure from Object Literal with const ----- // const { e, f } = { e: 'dataE', f: 'dataF' }; // <-- Destructure console.log(e); // dataE console.log(f); // dataF // Destructure from Object Literal with let ----- // let { g, h } = { g: 'dataG', h: 'dataH' }; // <-- Destructure console.log(g); // dataG console.log(h); // dataHNo caso de propriedades aninhadas, espelhe a mesma estrutura em sua atribuição de destruição:

const person = { name: 'Richard P. Feynman', occupation: { type: 'Theoretical Physicist', location: { lat: 1, lng: 2 } } }; // Attempt one: const { name, occupation } = person; console.log(name); // Richard P. Feynman console.log(occupation); // The entire `occupation` object. // Attempt two: const { occupation: { type, location } } = person; console.log(type); // Theoretical Physicist console.log(location) // The entire `location` object. // Attempt three: const { occupation: { location: { lat, lng } } } = person; console.log(lat); // 1 console.log(lng); // 2Como você pode ver, as propriedades que você decide extrair são opcionais e, para descompactar propriedades aninhadas, simplesmente espelhe a estrutura do objeto original (a fonte) no lado do modelo de sua sintaxe de desestruturação. Se você tentar desestruturar uma propriedade que não existe no objeto original, esse valor ficará indefinido.

Além disso, podemos desestruturar uma variável sem primeiro declará-la — atribuição sem declaração — usando a seguinte sintaxe:

let name, occupation; const person = { name: 'Richard P. Feynman', occupation: 'Theoretical Physicist' }; ;({ name, occupation } = person); console.log(name); // Richard P. Feynman console.log(occupation); // Theoretical PhysicistPrecedemos a expressão com um ponto e vírgula para garantir que não criamos acidentalmente um IIFE (Expressão de Função Imediatamente Invocada) com uma função em uma linha anterior (se existir uma função), e os parênteses ao redor da instrução de atribuição são necessários para pare o JavaScript de tratar seu lado esquerdo (modelo) como um bloco.

Um caso de uso muito comum de desestruturação existe dentro de argumentos de função:

const config = { baseUrl: '<baseURL>', awsBucket: '<bucket>', secret: '<secret-key>' // <- Make this an env var. }; // Destructures `baseUrl` and `awsBucket` off `config`. const performOperation = ({ baseUrl, awsBucket }) => { fetch(baseUrl).then(() => console.log('Done')); console.log(awsBucket); // <bucket> }; performOperation(config);Como você pode ver, poderíamos ter usado apenas a sintaxe de desestruturação normal com a qual estamos acostumados dentro da função, assim:

const config = { baseUrl: '<baseURL>', awsBucket: '<bucket>', secret: '<secret-key>' // <- Make this an env var. }; const performOperation = someConfig => { const { baseUrl, awsBucket } = someConfig; fetch(baseUrl).then(() => console.log('Done')); console.log(awsBucket); // <bucket> }; performOperation(config);Mas colocar essa sintaxe dentro da assinatura da função executa a desestruturação automaticamente e nos salva uma linha.

Um caso de uso real disso está em React Functional Components for props :

import React from 'react'; // Destructure `titleText` and `secondaryText` from `props`. export default ({ titleText, secondaryText }) => ( <div> <h1>{titleText}</h1> <h3>{secondaryText}</h3> </div> );Ao contrário de:

import React from 'react'; export default props => ( <div> <h1>{props.titleText}</h1> <h3>{props.secondaryText}</h3> </div> );Em ambos os casos, também podemos definir valores padrão para as propriedades:

const personOne = { name: 'User One', password: 'BCrypt Hash' }; const personTwo = { password: 'BCrypt Hash' }; const createUser = ({ name = 'Anonymous', password }) => { if (!password) throw new Error('InvalidArgumentException'); console.log(name); console.log(password); return { id: Math.random().toString(36) // <--- Should follow RFC 4122 Spec in real app. .substring(2, 15) + Math.random() .toString(36).substring(2, 15), name: name, // <-- We'll discuss this next. password: password // <-- We'll discuss this next. }; } createUser(personOne); // User One, BCrypt Hash createUser(personTwo); // Anonymous, BCrypt Hash Como você pode ver, caso esse name não esteja presente quando desestruturado, fornecemos um valor padrão. Podemos fazer isso com a sintaxe anterior também:

const { a, b, c = 'Default' } = { a: 'dataA', b: 'dataB' }; console.log(a); // dataA console.log(b); // dataB console.log(c); // DefaultArrays também podem ser desestruturados:

const myArr = [4, 3]; // Destructuring happens here. const [valOne, valTwo] = myArr; console.log(valOne); // 4 console.log(valTwo); // 3 // ----- Destructuring without assignment: ----- // let a, b; // Destructuring happens here. ;([a, b] = [10, 2]); console.log(a + b); // 12Uma razão prática para a desestruturação de array ocorre com React Hooks. (E há muitas outras razões, estou usando apenas o React como exemplo).

import React, { useState } from "react"; export default () => { const [buttonText, setButtonText] = useState("Default"); return ( <button onClick={() => setButtonText("Toggled")}> {buttonText} </button> ); } Observe useState está sendo desestruturado na exportação e as funções/valores da matriz estão sendo desestruturadas no gancho useState . Novamente, não se preocupe se o acima não fizer sentido - você teria que entender React - e eu estou apenas usando isso como um exemplo.

Embora haja mais sobre a desestruturação de objetos do ES6, abordarei mais um tópico aqui: Desestruturando a renomeação, que é útil para evitar colisões de escopo ou sombras de variáveis, etc. Suponha que queremos desestruturar uma propriedade chamada name de um objeto chamado person , mas já existe uma variável com o nome name no escopo. Podemos renomear rapidamente com dois pontos:

// JS Destructuring Naming Collision Example: const name = 'Jamie Corkhill'; const person = { name: 'Alan Turing' }; // Rename `name` from `person` to `personName` after destructuring. const { name: personName } = person; console.log(name); // Jamie Corkhill <-- As expected. console.log(personName); // Alan Turing <-- Variable was renamed.Finalmente, podemos definir valores padrão com renomeação também:

const name = 'Jamie Corkhill'; const person = { location: 'New York City, United States' }; const { name: personName = 'Anonymous', location } = person; console.log(name); // Jamie Corkhill console.log(personName); // Anonymous console.log(location); // New York City, United States Como você pode ver, neste caso, o name da person ( person.name ) será renomeado para personName e definido para o valor padrão de Anonymous se não existir.

E claro, o mesmo pode ser realizado nas assinaturas de função:

const personOne = { name: 'User One', password: 'BCrypt Hash' }; const personTwo = { password: 'BCrypt Hash' }; const createUser = ({ name: personName = 'Anonymous', password }) => { if (!password) throw new Error('InvalidArgumentException'); console.log(personName); console.log(password); return { id: Math.random().toString(36).substring(2, 15) + Math.random().toString(36).substring(2, 15), name: personName, password: password // <-- We'll discuss this next. }; } createUser(personOne); // User One, BCrypt Hash createUser(personTwo); // Anonymous, BCrypt HashAbreviação de Objeto ES6

Suponha que você tenha a seguinte fábrica: (cobriremos as fábricas mais tarde)

const createPersonFactory = (name, location, position) => ({ name: name, location: location, position: position }); Pode-se usar esta fábrica para criar um objeto person , como segue. Além disso, observe que a fábrica está retornando implicitamente um objeto, evidente pelos parênteses ao redor dos colchetes da Função Arrow.

const person = createPersonFactory('Jamie', 'Texas', 'Developer'); console.log(person); // { ... } Isso é o que já sabemos da Sintaxe Literal de Objetos ES5. Observe, no entanto, na função de fábrica, que o valor de cada propriedade é o mesmo nome que o próprio identificador de propriedade (chave). Ou seja — location: location ou name: name . Acontece que isso era uma ocorrência bastante comum com desenvolvedores JS.

Com a sintaxe abreviada do ES6, podemos obter o mesmo resultado reescrevendo a fábrica da seguinte forma:

const createPersonFactory = (name, location, position) => ({ name, location, position }); const person = createPersonFactory('Jamie', 'Texas', 'Developer'); console.log(person);Produzindo a saída:

{ name: 'Jamie', location: 'Texas', position: 'Developer' }É importante perceber que só podemos usar essa abreviação quando o objeto que desejamos criar está sendo criado dinamicamente com base em variáveis, onde os nomes das variáveis são iguais aos nomes das propriedades às quais queremos atribuir as variáveis.

Essa mesma sintaxe funciona com valores de objetos:

const createPersonFactory = (name, location, position, extra) => ({ name, location, position, extra // <- right here. }); const extra = { interests: [ 'Mathematics', 'Quantum Mechanics', 'Spacecraft Launch Systems' ], favoriteLanguages: [ 'JavaScript', 'C#' ] }; const person = createPersonFactory('Jamie', 'Texas', 'Developer', extra); console.log(person);Produzindo a saída:

{ name: 'Jamie', location: 'Texas', position: 'Developer', extra: { interests: [ 'Mathematics', 'Quantum Mechanics', 'Spacecraft Launch Systems' ], favoriteLanguages: [ 'JavaScript', 'C#' ] } }Como exemplo final, isso também funciona com literais de objeto:

const id = '314159265358979'; const name = 'Archimedes of Syracuse'; const location = 'Syracuse'; const greatMathematician = { id, name, location };Operador de Spread ES6 (…)

O Spread Operator nos permite fazer uma variedade de coisas, algumas das quais discutiremos aqui.

Em primeiro lugar, podemos espalhar propriedades de um objeto para outro objeto:

const myObjOne = { a: 'a', b: 'b' }; const myObjTwo = { ...myObjOne }: Isso tem o efeito de colocar todas as propriedades em myObjOne em myObjTwo , de modo que myObjTwo seja agora { a: 'a', b: 'b' } . Podemos usar esse método para substituir propriedades anteriores. Suponha que um usuário queira atualizar sua conta:

const user = { name: 'John Doe', email: '[email protected]', password: ' ', bio: 'Lorem ipsum' }; const updates = { password: ' ', bio: 'Ipsum lorem', email: '[email protected]' }; const updatedUser = { ...user, // <- original ...updates // <- updates }; console.log(updatedUser); /* { name: 'John Doe', email: '[email protected]', // Updated password: ' ', // Updated bio: 'Ipsum lorem' } */const user = { name: 'John Doe', email: '[email protected]', password: ' ', bio: 'Lorem ipsum' }; const updates = { password: ' ', bio: 'Ipsum lorem', email: '[email protected]' }; const updatedUser = { ...user, // <- original ...updates // <- updates }; console.log(updatedUser); /* { name: 'John Doe', email: '[email protected]', // Updated password: ' ', // Updated bio: 'Ipsum lorem' } */const user = { name: 'John Doe', email: '[email protected]', password: ' ', bio: 'Lorem ipsum' }; const updates = { password: ' ', bio: 'Ipsum lorem', email: '[email protected]' }; const updatedUser = { ...user, // <- original ...updates // <- updates }; console.log(updatedUser); /* { name: 'John Doe', email: '[email protected]', // Updated password: ' ', // Updated bio: 'Ipsum lorem' } */const user = { name: 'John Doe', email: '[email protected]', password: ' ', bio: 'Lorem ipsum' }; const updates = { password: ' ', bio: 'Ipsum lorem', email: '[email protected]' }; const updatedUser = { ...user, // <- original ...updates // <- updates }; console.log(updatedUser); /* { name: 'John Doe', email: '[email protected]', // Updated password: ' ', // Updated bio: 'Ipsum lorem' } */

O mesmo pode ser feito com arrays:

const apollo13Astronauts = ['Jim', 'Jack', 'Fred']; const apollo11Astronauts = ['Neil', 'Buz', 'Michael']; const unionOfAstronauts = [...apollo13Astronauts, ...apollo11Astronauts]; console.log(unionOfAstronauts); // ['Jim', 'Jack', 'Fred', 'Neil', 'Buz, 'Michael'];Observe aqui que criamos uma união de ambos os conjuntos (arrays) espalhando os arrays em um novo array.

Há muito mais sobre o Operador Rest/Spread, mas está fora do escopo deste artigo. Ele pode ser usado para obter vários argumentos para uma função, por exemplo. Se você quiser saber mais, veja a documentação do MDN aqui.

ES6 Assíncrono/Aguardar

Async/Await é uma sintaxe para aliviar a dor do encadeamento de promessas.

A palavra reservada await permite que você “aguarde” o estabelecimento de uma promessa, mas só pode ser usada em funções marcadas com a palavra-chave async . Suponha que eu tenha uma função que retorna uma promessa. Em uma nova função async , posso await o resultado dessa promessa em vez de usar .catch .then

// Returns a promise. const myFunctionThatReturnsAPromise = () => { return new Promise((resolve, reject) => { setTimeout(() => resolve('Hello'), 3000); }); } const myAsyncFunction = async () => { const promiseResolutionResult = await myFunctionThatReturnsAPromise(); console.log(promiseResolutionResult); }; // Writes the log statement after three seconds. myAsyncFunction(); Há algumas coisas a serem observadas aqui. Quando usamos await em uma função async , apenas o valor resolvido entra na variável do lado esquerdo. Se a função rejeitar, é um erro que temos que detectar, como veremos em breve. Além disso, qualquer função marcada como async , por padrão, retornará uma promessa.

Vamos supor que eu precise fazer duas chamadas de API, uma com a resposta da primeira. Usando promessas e encadeamento de promessas, você pode fazer desta maneira:

const makeAPICall = route => new Promise((resolve, reject) => { console.log(route) resolve(route); }); const main = () => { makeAPICall('/whatever') .then(response => makeAPICall(response + ' second call')) .then(response => console.log(response + ' logged')) .catch(err => console.error(err)) }; main(); // Result: /* /whatever /whatever second call /whatever second call logged */ O que está acontecendo aqui é que primeiro chamamos makeAPICall passando para ele /whatever , que é registrado na primeira vez. A promessa é resolvida com esse valor. Em seguida, chamamos makeAPICall novamente, passando para ele /whatever second call , que é registrada e, novamente, a promessa é resolvida com esse novo valor. Por fim, pegamos esse novo valor /whatever second call com a qual a promessa acabou de ser resolvida e o registramos no log final, anexando logged no final. Se isso não fizer sentido, você deve analisar o encadeamento de promessas.

Usando async / await , podemos refatorar para o seguinte:

const main = async () => { const resultOne = await makeAPICall('/whatever'); const resultTwo = await makeAPICall(resultOne + ' second call'); console.log(resultTwo + ' logged'); }; Aqui está o que vai acontecer. A função inteira parará de ser executada na primeira instrução await até que a promessa da primeira chamada para makeAPICall resolvida, após a resolução, o valor resolvido será colocado em resultOne . Quando isso acontecer, a função passará para a segunda instrução await , novamente pausando ali pela duração da liquidação da promessa. Quando a promessa for resolvida, o resultado da resolução será colocado em resultTwo . Se a ideia sobre a execução da função parece um bloqueio, não tenha medo, ainda é assíncrona, e discutirei o porquê em um minuto.

Isso apenas descreve o caminho “feliz”. No caso de uma das promessas ser rejeitada, podemos pegá-la com try/catch, pois se a promessa for rejeitada, um erro será lançado - que será qualquer erro com o qual a promessa foi rejeitada.

const main = async () => { try { const resultOne = await makeAPICall('/whatever'); const resultTwo = await makeAPICall(resultOne + ' second call'); console.log(resultTwo + ' logged'); } catch (e) { console.log(e) } }; Como eu disse anteriormente, qualquer função declarada como async retornará uma promessa. Portanto, se você quiser chamar uma função assíncrona de outra função, poderá usar promessas normais ou await se declarar a função de chamada async . No entanto, se você quiser chamar uma função async do código de nível superior e aguardar seu resultado, precisará usar .catch .then

Por exemplo:

const returnNumberOne = async () => 1; returnNumberOne().then(value => console.log(value)); // 1Ou você pode usar uma Expressão de Função Invocada Imediatamente (IIFE):

(async () => { const value = await returnNumberOne(); console.log(value); // 1 })(); Quando você usa await em uma função async , a execução da função parará nessa instrução await até que a promessa seja resolvida. No entanto, todas as outras funções são livres para prosseguir com a execução, portanto, nenhum recurso extra de CPU é alocado nem o encadeamento é bloqueado. Direi isso novamente — as operações nessa função específica naquele momento específico serão interrompidas até que a promessa seja resolvida, mas todas as outras funções estão livres para serem acionadas. Considere um servidor da Web HTTP - por solicitação, todas as funções são livres para serem acionadas para todos os usuários simultaneamente à medida que as solicitações são feitas, é apenas que a sintaxe async/await fornecerá a ilusão de que uma operação é síncrona e bloqueante para tornar promete mais fácil de trabalhar, mas, novamente, tudo permanecerá agradável e assíncrono.

Isso não é tudo o que há para async / await , mas deve ajudá-lo a entender os princípios básicos.

Fábricas OOP clássicas

Agora vamos sair do mundo JavaScript e entrar no mundo Java . Pode chegar um momento em que o processo de criação de um objeto (neste caso, uma instância de uma classe — novamente, Java) seja bastante complexo ou quando queremos que diferentes objetos sejam produzidos com base em uma série de parâmetros. Um exemplo pode ser uma função que cria diferentes objetos de erro. Uma fábrica é um padrão de projeto comum em Programação Orientada a Objetos e é basicamente uma função que cria objetos. Para explorar isso, vamos nos afastar do JavaScript para o mundo do Java. Isso fará sentido para os desenvolvedores que vêm de uma OOP clássica (ou seja, não prototípica), background de linguagem estaticamente tipada. Se você não é um desses desenvolvedores, sinta-se à vontade para pular esta seção. Este é um pequeno desvio e, portanto, se seguir aqui interromper seu fluxo de JavaScript, novamente, pule esta seção.

Um padrão de criação comum, o Factory Pattern nos permite criar objetos sem expor a lógica de negócios necessária para realizar essa criação.

Suponha que estamos escrevendo um programa que nos permite visualizar formas primitivas em n-dimensões. Se fornecermos um cubo, por exemplo, veremos um cubo 2D (um quadrado), um cubo 3D (um cubo) e um cubo 4D (um Tesseract ou Hypercube). Aqui está como isso pode ser feito, trivialmente, e excluindo a parte real do desenho, em Java.

// Main.java // Defining an interface for the shape (can be used as a base type) interface IShape { void draw(); } // Implementing the interface for 2-dimensions: class TwoDimensions implements IShape { @Override public void draw() { System.out.println("Drawing a shape in 2D."); } } // Implementing the interface for 3-dimensions: class ThreeDimensions implements IShape { @Override public void draw() { System.out.println("Drawing a shape in 3D."); } } // Implementing the interface for 4-dimensions: class FourDimensions implements IShape { @Override public void draw() { System.out.println("Drawing a shape in 4D."); } } // Handles object creation class ShapeFactory { // Factory method (notice return type is the base interface) public IShape createShape(int dimensions) { switch(dimensions) { case 2: return new TwoDimensions(); case 3: return new ThreeDimensions(); case 4: return new FourDimensions(); default: throw new IllegalArgumentException("Invalid dimension."); } } } // Main class and entry point. public class Main { public static void main(String[] args) throws Exception { ShapeFactory shapeFactory = new ShapeFactory(); IShape fourDimensions = shapeFactory.createShape(4); fourDimensions.draw(); // Drawing a shape in 4D. } } Como você pode ver, definimos uma interface que especifica um método para desenhar uma forma. Ao fazer com que as diferentes classes implementem a interface, podemos garantir que todas as formas possam ser desenhadas (pois todas elas devem ter um método de draw substituível conforme a definição da interface). Considerando que essa forma é desenhada de forma diferente dependendo das dimensões em que é visualizada, definimos classes auxiliares que implementam a interface para executar o trabalho intensivo de simulação de renderização n-dimensional da GPU. ShapeFactory faz o trabalho de instanciar a classe correta — o método createShape é uma fábrica e, como a definição acima, é um método que retorna um objeto de uma classe. O tipo de retorno de createShape é a interface IShape porque a interface IShape é o tipo base de todas as formas (porque elas têm um método draw ).

Este exemplo Java é bastante trivial, mas você pode ver facilmente como ele se torna útil em aplicativos maiores, onde a configuração para criar um objeto pode não ser tão simples. Um exemplo disso seria um videogame. Suponha que o usuário tenha que sobreviver a diferentes inimigos. Classes e interfaces abstratas podem ser usadas para definir funções básicas disponíveis para todos os inimigos (e métodos que podem ser substituídos), talvez empregando o padrão de delegação (favorecer composição sobre herança como a Gangue dos Quatro sugeriu para que você não fique preso em estender um classe base única e para facilitar o teste/simulação/DI). Para objetos inimigos instanciados de maneiras diferentes, a interface permitiria a criação de objetos de fábrica enquanto contava com o tipo de interface genérico. Isso seria muito relevante se o inimigo fosse criado dinamicamente.

Outro exemplo é uma função de construtor. Suponha que utilizemos o Padrão de Delegação para que uma classe delegue o trabalho para outras classes que honrem uma interface. Poderíamos colocar um método de build estático na classe para que ele construísse sua própria instância (supondo que você não estivesse usando um Contêiner/Framework de Injeção de Dependência). Em vez de ter que chamar cada setter, você pode fazer isso:

public class User { private IMessagingService msgService; private String name; private int age; public User(String name, int age, IMessagingService msgService) { this.name = name; this.age = age; this.msgService = msgService; } public static User build(String name, int age) { return new User(name, age, new SomeMessageService()); } } Explicarei o padrão de delegação em um artigo posterior, se você não estiver familiarizado com ele - basicamente, por meio da composição e em termos de modelagem de objetos, ele cria um relacionamento "tem-a" em vez de um "é-um" relacionamento como você obteria com herança. Se você tem uma classe Mammal e uma classe Dog , e Dog estende Mammal , então um Dog é um Mammal . Considerando que, se você tivesse uma classe Bark e acabasse de passar instâncias de Bark para o construtor de Dog , Dog teria um Bark . Como você pode imaginar, isso facilita especialmente o teste de unidade, pois você pode injetar mocks e declarar fatos sobre o mock, desde que o mock honre o contrato de interface no ambiente de teste.

O método de fábrica "build" static acima simplesmente cria um novo objeto de User e passa um MessageService concreto. Observe como isso segue a definição acima - não expondo a lógica de negócios para criar um objeto de uma classe ou, neste caso, não expor a criação do serviço de mensagens ao chamador da fábrica.

Novamente, isso não é necessariamente como você faria as coisas no mundo real, mas apresenta a ideia de uma função/método de fábrica muito bem. Podemos usar um contêiner de injeção de dependência, por exemplo. Agora de volta ao JavaScript.

Começando com Expresso

Express é um Web Application Framework para Node (disponível por meio de um módulo NPM) que permite criar um servidor Web HTTP. É importante notar que o Express não é o único framework para fazer isso (existe Koa, Fastify, etc.), e que, como visto no artigo anterior, o Node pode funcionar sem o Express como uma entidade autônoma. (Express é apenas um módulo que foi projetado para o Node — o Node pode fazer muitas coisas sem ele, embora o Express seja popular para servidores Web).

Mais uma vez, deixe-me fazer uma distinção muito importante. Existe uma dicotomia presente entre Node/JavaScript e Express. Node, o ambiente/tempo de execução no qual você executa o JavaScript, pode fazer muitas coisas — como permitir que você crie aplicativos React Native, aplicativos de desktop, ferramentas de linha de comando etc. Node/JS para construir servidores web em vez de lidar com a rede de baixo nível do Node e APIs HTTP. Você não precisa do Express para construir um servidor web.

Antes de iniciar esta seção, se você não estiver familiarizado com HTTP e HTTP Requests (GET, POST, etc.), então eu o encorajo a ler a seção correspondente do meu artigo anterior, que está no link acima.

Usando o Express, configuraremos diferentes rotas para as quais solicitações HTTP podem ser feitas, bem como os endpoints relacionados (que são funções de retorno de chamada) que serão acionados quando uma solicitação for feita para essa rota. Não se preocupe se as rotas e os endpoints não fizerem sentido no momento - eu os explicarei mais tarde.

Ao contrário de outros artigos, adotarei a abordagem de escrever o código-fonte à medida que avançamos, linha por linha, em vez de despejar toda a base de código em um trecho e depois explicar mais tarde. Vamos começar abrindo um terminal (estou usando o Terminus em cima do Git Bash no Windows - que é uma boa opção para usuários do Windows que desejam um Bash Shell sem configurar o Subsistema Linux), configurando o clichê do nosso projeto e abrindo-o no código do Visual Studio.

mkdir server && cd server touch server.js npm init -y npm install express code . Dentro do arquivo server.js , começarei solicitando express usando a função require() .

const express = require('express'); require('express') diz ao Node para sair e obter o módulo Express que instalamos anteriormente, que está atualmente dentro da pasta node_modules (para isso é o que npm install faz - crie uma pasta node_modules e coloque os módulos e suas dependências lá). Por convenção, e ao lidar com Express, chamamos a variável que contém o resultado de retorno de require('express') express , embora possa ser chamada de qualquer coisa.

This returned result, which we have called express , is actually a function — a function we'll have to invoke to create our Express app and set up our routes. Again, by convention, we call this app — app being the return result of express() — that is, the return result of calling the function that has the name express as express() .

const express = require('express'); const app = express(); // Note that the above variable names are the convention, but not required. // An example such as that below could also be used. const foo = require('express'); const bar = foo(); // Note also that the node module we installed is called express. The line const app = express(); simply puts a new Express Application inside of the app variable. It calls a function named express (the return result of require('express') ) and stores its return result in a constant named app . If you come from an object-oriented programming background, consider this equivalent to instantiating a new object of a class, where app would be the object and where express() would call the constructor function of the express class. Remember, JavaScript allows us to store functions in variables — functions are first-class citizens. The express variable, then, is nothing more than a mere function. It's provided to us by the developers of Express.

I apologize in advance if I'm taking a very long time to discuss what is actually very basic, but the above, although primitive, confused me quite a lot when I was first learning back-end development with Node.

Inside the Express source code, which is open-source on GitHub, the variable we called express is a function entitled createApplication , which, when invoked, performs the work necessary to create an Express Application:

A snippet of Express source code:

exports = module.exports = createApplication; /* * Create an express application */ // This is the function we are storing in the express variable. (- Jamie) function createApplication() { // This is what I mean by "Express App" (- Jamie) var app = function(req, res, next) { app.handle(req, res, next); }; mixin(app, EventEmitter.prototype, false); mixin(app, proto, false); // expose the prototype that will get set on requests app.request = Object.create(req, { app: { configurable: true, enumerable: true, writable: true, value: app } }) // expose the prototype that will get set on responses app.response = Object.create(res, { app: { configurable: true, enumerable: true, writable: true, value: app } }) app.init(); // See - `app` gets returned. (- Jamie) return app; }GitHub: https://github.com/expressjs/express/blob/master/lib/express.js

With that short deviation complete, let's continue setting up Express. Thus far, we have required the module and set up our app variable.

const express = require('express'); const app = express(); From here, we have to tell Express to listen on a port. Any HTTP Requests made to the URL and Port upon which our application is listening will be handled by Express. We do that by calling app.listen(...) , passing to it the port and a callback function which gets called when the server starts running:

const PORT = 3000; app.listen(PORT, () => console.log(`Server is up on port {PORT}.`)); We notate the PORT variable in capital by convention, for it is a constant variable that will never change. You could do that with all variables that you declare const , but that would look messy. It's up to the developer or development team to decide on notation, so we'll use the above sparsely. I use const everywhere as a method of “defensive coding” — that is, if I know that a variable is never going to change then I might as well just declare it const . Since I define everything const , I make the distinction between what variables should remain the same on a per-request basis and what variables are true actual global constants.

Here is what we have thus far:

const express = require('express'); const app = express(); const PORT = 3000; // We will build our API here. // ... // Binding our application to port 3000. app.listen(PORT, () => { console.log(`Server is up on port ${PORT}.`); });Let's test this to see if the server starts running on port 3000.

I'll open a terminal and navigate to our project's root directory. I'll then run node server/server.js . Note that this assumes you have Node already installed on your system (You can check with node -v ).

If everything works, you should see the following in the terminal:

Server is up on port 3000.

Go ahead and hit Ctrl + C to bring the server back down.

If this doesn't work for you, or if you see an error such as EADDRINUSE , then it means you may have a service already running on port 3000. Pick another port number, like 3001, 3002, 5000, 8000, etc. Be aware, lower number ports are reserved and there is an upper bound of 65535.

At this point, it's worth taking another small deviation as to understand servers and ports in the context of computer networking. We'll return to Express in a moment. I take this approach, rather than introducing servers and ports first, for the purpose of relevance. That is, it is difficult to learn a concept if you fail to see its applicability. In this way, you are already aware of the use case for ports and servers with Express, so the learning experience will be more pleasurable.

A Brief Look At Servers And Ports

A server is simply a computer or computer program that provides some sort of “functionality” to the clients that talk to it. More generally, it's a device, usually connected to the Internet, that handles connections in a pre-defined manner. In our case, that “pre-defined manner” will be HTTP or the HyperText Transfer Protocol. Servers that use the HTTP Protocol are called Web Servers.

When building an application, the server is a critical component of the “client-server model”, for it permits the sharing and syncing of data (generally via databases or file systems) across devices. It's a cross-platform approach, in a way, for the SDKs of platforms against which you may want to code — be they web, mobile, or desktop — all provide methods (APIs) to interact with a server over HTTP or TCP/UDP Sockets. It's important to make a distinction here — by APIs, I mean programming language constructs to talk to a server, like XMLHttpRequest or the Fetch API in JavaScript, or HttpUrlConnection in Java, or even HttpClient in C#/.NET. This is different from the kind of REST API we'll be building in this article to perform CRUD Operations on a database.

To talk about ports, it's important to understand how clients connect to a server. A client requires the IP Address of the server and the Port Number of our specific service on that server. An IP Address, or Internet Protocol Address, is just an address that uniquely identifies a device on a network. Public and private IPs exist, with private addresses commonly used behind a router or Network Address Translator on a local network. You might see private IP Addresses of the form 192.168.XXX.XXX or 10.0.XXX.XXX . When articulating an IP Address, decimals are called “dots”. So 192.168.0.1 (a common router IP Addr.) might be pronounced, “one nine two dot one six eight dot zero dot one”. (By the way, if you're ever in a hotel and your phone/laptop won't direct you to the AP captive portal, try typing 192.168.0.1 or 192.168.1.1 or similar directly into Chrome).

For simplicity, and since this is not an article about the complexities of computer networking, assume that an IP Address is equivalent to a house address, allowing you to uniquely identify a house (where a house is analogous to a server, client, or network device) in a neighborhood. One neighborhood is one network. Put together all of the neighborhoods in the United States, and you have the public Internet. (This is a basic view, and there are many more complexities — firewalls, NATs, ISP Tiers (Tier One, Tier Two, and Tier Three), fiber optics and fiber optic backbones, packet switches, hops, hubs, etc., subnet masks, etc., to name just a few — in the real networking world.) The traceroute Unix command can provide more insight into the above, displaying the path (and associated latency) that packets take through a network as a series of “hops”.

Um número de porta identifica um serviço específico em execução em um servidor. SSH, ou Secure Shell, que permite o acesso remoto do shell a um dispositivo, geralmente é executado na porta 22. FTP ou File Transfer Protocol (que pode, por exemplo, ser usado com um cliente FTP para transferir ativos estáticos para um servidor) geralmente é executado em Porta 21. Poderíamos dizer, então, que as portas são cômodos específicos dentro de cada casa em nossa analogia acima, pois os cômodos das casas são feitos para coisas diferentes – um quarto para dormir, uma cozinha para preparar alimentos, uma sala de jantar para consumo do referido alimentos, etc., assim como os portos correspondem a programas que realizam serviços específicos. Para nós, os Servidores Web geralmente rodam na Porta 80, embora você seja livre para especificar o Número da Porta que desejar, desde que não estejam sendo usados por algum outro serviço (eles não podem colidir).

Para acessar um site, você precisa do endereço IP do site. Apesar disso, normalmente acessamos sites por meio de uma URL. Nos bastidores, um DNS, ou Domain Name Server, converte essa URL em um endereço IP, permitindo que o navegador faça uma solicitação GET para o servidor, obtenha o HTML e o renderize na tela. 8.8.8.8 é o endereço de um dos Servidores DNS Públicos do Google. Você pode imaginar que exigir a resolução de um nome de host para um endereço IP por meio de um servidor DNS remoto levará tempo, e você está certo. Para reduzir a latência, os sistemas operacionais têm um cache DNS — um banco de dados temporário que armazena informações de pesquisa de DNS, reduzindo assim a frequência com que essas pesquisas devem ocorrer. O DNS Resolver Cache pode ser visualizado no Windows com o comando ipconfig /displaydns CMD e removido por meio do comando ipconfig /flushdns .

Em um servidor Unix, as portas de número inferior mais comuns, como 80, exigem privilégios de nível raiz ( escalonados se você vier de um plano de fundo do Windows). Por esse motivo, usaremos a porta 3000 para nosso trabalho de desenvolvimento, mas permitiremos que o servidor escolha o número da porta (o que estiver disponível) quando implantarmos em nosso ambiente de produção.

Por fim, observe que podemos digitar endereços IP diretamente na barra de pesquisa do Google Chrome, ignorando o mecanismo de resolução de DNS. Digitar 216.58.194.36 , por exemplo, levará você ao Google.com. Em nosso ambiente de desenvolvimento, ao usar nosso próprio computador como nosso servidor de desenvolvimento, usaremos localhost e porta 3000. Um endereço é formatado como hostname:port , então nosso servidor estará em localhost:3000 . Localhost, ou 127.0.0.1 , é o endereço de loopback e significa o endereço de “este computador”. É um nome de host e seu endereço IPv4 resolve para 127.0.0.1 . Tente pingar localhost em sua máquina agora. Você pode obter ::1 back — que é o endereço de loopback IPv6 ou 127.0.0.1 back — que é o endereço de loopback IPv4. IPv4 e IPv6 são dois formatos de endereço IP diferentes associados a padrões diferentes — alguns endereços IPv6 podem ser convertidos para IPv4, mas não todos.

Voltando ao Expresso

Mencionei solicitações HTTP, verbos e códigos de status em meu artigo anterior, Introdução ao nó: uma introdução às APIs, HTTP e JavaScript ES6+. Se você não tiver uma compreensão geral do protocolo, sinta-se à vontade para pular para a seção “Solicitações HTTP e HTTP” dessa parte.

Para ter uma ideia do Express, vamos simplesmente configurar nossos terminais para as quatro operações fundamentais que realizaremos no banco de dados — Criar, Ler, Atualizar e Excluir, conhecidas coletivamente como CRUD.

Lembre-se de que acessamos endpoints por rotas na URL. Ou seja, embora as palavras “rota” e “endpoint” sejam comumente usadas de forma intercambiável, um endpoint é tecnicamente uma função de linguagem de programação (como ES6 Arrow Functions) que executa alguma operação do lado do servidor, enquanto uma rota é o que o endpoint está localizado atrás . de . Especificamos esses endpoints como funções de retorno de chamada, que o Express acionará quando a solicitação apropriada for feita do cliente para a rota atrás da qual o endpoint reside. Você pode se lembrar do que foi dito acima percebendo que são os endpoints que executam uma função e a rota é o nome que é usado para acessar os endpoints. Como veremos, a mesma rota pode ser associada a vários endpoints usando diferentes verbos HTTP (semelhante à sobrecarga de métodos se você tiver um histórico de OOP clássico com polimorfismo).

Lembre-se de que estamos seguindo a arquitetura REST (REpresentational State Transfer) permitindo que os clientes façam solicitações ao nosso servidor. Afinal, trata-se de uma API REST ou RESTful. Solicitações específicas feitas a rotas específicas acionarão endpoints específicos que farão coisas específicas. Um exemplo de tal “coisa” que um endpoint pode fazer é adicionar novos dados a um banco de dados, remover dados, atualizar dados etc.

O Express sabe qual endpoint disparar porque informamos explicitamente o método de solicitação (GET, POST, etc.) e a rota — definimos quais funções disparar para combinações específicas dos itens acima e o cliente faz a solicitação, especificando percurso e método. Para simplificar, com o Node, diremos ao Express — “Ei, se alguém fizer uma solicitação GET para esta rota, vá em frente e dispare esta função (use este endpoint)”. As coisas podem ficar mais complicadas: “Expresso, se alguém fizer uma solicitação GET para essa rota, mas não enviar um token de portador de autorização válido no cabeçalho da solicitação, responda com um HTTP 401 Unauthorized . Se eles possuírem um token de portador válido, envie qualquer recurso protegido que eles estivessem procurando disparando o endpoint. Muito obrigado e tenha um bom dia.” De fato, seria bom se as linguagens de programação pudessem ser de alto nível sem vazar ambiguidade, mas mesmo assim demonstra os conceitos básicos.

Lembre-se, o ponto final, de certa forma, mora atrás da rota. Portanto, é imperativo que o cliente forneça, no cabeçalho da solicitação, qual método deseja usar para que o Express possa descobrir o que fazer. A solicitação será feita para uma rota específica, que o cliente especificará (junto com o tipo de solicitação) ao entrar em contato com o servidor, permitindo que o Express faça o que precisa fazer e nós façamos o que precisamos fazer quando o Express disparar nossos retornos de chamada . É nisso que tudo se resume.

Nos exemplos de código anteriores, chamamos a função listen que estava disponível em app , passando para ela uma porta e um retorno de chamada. app em si, se você se lembra, é o resultado de retorno de chamar a variável express como uma função (ou seja, express() ), e a variável express é o que chamamos de resultado de retorno ao exigir 'express' de nossa pasta node_modules . Assim como listen é chamado no app , especificamos os endpoints de solicitação HTTP chamando-os no app . Vejamos o GET:

app.get('/my-test-route', () => { // ... }); O primeiro parâmetro é uma string , e é a rota por trás da qual o endpoint ficará. A função de retorno de chamada é o ponto de extremidade. Direi isso novamente: a função de retorno de chamada — o segundo parâmetro — é o ponto de extremidade que será acionado quando uma solicitação HTTP GET for feita para qualquer rota que especificarmos como o primeiro argumento ( /my-test-route neste caso).

Agora, antes de trabalharmos mais com o Express, precisamos saber como as rotas funcionam. A rota que especificamos como uma string será chamada fazendo a solicitação para www.domain.com/the-route-we-chose-earlier-as-a-string . No nosso caso, o domínio é localhost:3000 , o que significa que, para acionar a função de retorno de chamada acima, temos que fazer uma solicitação GET para localhost:3000/my-test-route . Se usássemos uma string diferente como o primeiro argumento acima, a URL teria que ser diferente para corresponder ao que especificamos em JavaScript.

Ao falar sobre essas coisas, você provavelmente ouvirá falar de Glob Patterns. Poderíamos dizer que todas as rotas da nossa API estão localizadas em localhost:3000/** Glob Pattern, onde ** é um curinga que significa qualquer diretório ou subdiretório (observe que as rotas não são diretórios) para o qual a raiz é pai — isto é, tudo.

Vamos em frente e adicionar uma instrução de log nessa função de retorno de chamada para que tenhamos:

// Getting the module from node_modules. const express = require('express'); // Creating our Express Application. const app = express(); // Defining the port we'll bind to. const PORT = 3000; // Defining a new endpoint behind the "/my-test-route" route. app.get('/my-test-route', () => { console.log('A GET Request was made to /my-test-route.'); }); // Binding the server to port 3000. app.listen(PORT, () => { console.log(`Server is up on port ${PORT}.`) }); Colocaremos nosso servidor em funcionamento executando node server/server.js (com o Node instalado em nosso sistema e acessível globalmente a partir de variáveis de ambiente do sistema) no diretório raiz do projeto. Como anteriormente, você deve ver a mensagem de que o servidor está ativo no console. Agora que o servidor está em execução, abra um navegador e visite localhost:3000 na barra de URL.

Você deve ser saudado com uma mensagem de erro informando Cannot GET / . Pressione Ctrl + Shift + I no Windows no Chrome para visualizar o console do desenvolvedor. Lá, você deve ver que temos um 404 (Recurso não encontrado). Isso faz sentido - nós apenas dissemos ao servidor o que fazer quando alguém visita localhost:3000/my-test-route . O navegador não tem nada para renderizar em localhost:3000 (que é equivalente a localhost:3000/ com uma barra).

Se você olhar para a janela do terminal onde o servidor está sendo executado, não deve haver novos dados. Agora, visite localhost:3000/my-test-route na barra de URL do seu navegador. Você pode ver o mesmo erro no console do Chrome (porque o navegador está armazenando o conteúdo em cache e ainda não tem HTML para renderizar), mas se você visualizar seu terminal onde o processo do servidor está sendo executado, verá que a função de retorno de chamada realmente foi acionada e a mensagem de log foi realmente registrada.

Desligue o servidor com Ctrl + C.

Agora, vamos dar ao navegador algo para renderizar quando uma solicitação GET for feita para essa rota para que possamos perder a mensagem Cannot GET / . Vou pegar nosso app.get() de antes, e na função de retorno de chamada, vou adicionar dois argumentos. Lembre-se, a função de retorno de chamada que estamos passando está sendo chamada pelo Express nos bastidores, e o Express pode adicionar quaisquer argumentos que desejar. Na verdade, ele adiciona dois (bem, tecnicamente três, mas veremos isso mais tarde), e embora ambos sejam extremamente importantes, não nos importamos com o primeiro por enquanto. O segundo argumento é chamado res , abreviação de response , e vou acessá-lo definindo undefined como o primeiro parâmetro:

app.get('/my-test-route', (undefined, res) => { console.log('A GET Request was made to /my-test-route.'); }); Novamente, podemos chamar o argumento res como quisermos, mas res é convenção ao lidar com Express. res é na verdade um objeto, e sobre ele existem diferentes métodos para enviar dados de volta ao cliente. Neste caso, vou acessar a função send(...) disponível em res para enviar de volta o HTML que o navegador irá renderizar. No entanto, não estamos limitados a enviar de volta HTML e podemos optar por enviar de volta texto, um Objeto JavaScript, um fluxo (fluxos são especialmente bonitos) ou qualquer outra coisa.

app.get('/my-test-route', (undefined, res) => { console.log('A GET Request was made to /my-test-route.'); res.send('<h1>Hello, World!</h1>'); }); Se você desligar o servidor e, em seguida, ativá-lo novamente e, em seguida, atualizar seu navegador na /my-test-route , você verá o HTML sendo renderizado.

A guia Rede das Ferramentas do desenvolvedor do Chrome permitirá que você veja esta solicitação GET com mais detalhes no que diz respeito aos cabeçalhos.

Neste ponto, será bom começar a aprender sobre o Express Middleware — funções que podem ser disparadas globalmente depois que um cliente faz uma solicitação.

Middleware expresso

O Express fornece métodos para definir middleware customizado para seu aplicativo. De fato, o significado de Express Middleware é melhor definido no Express Docs, aqui)

As funções de middleware são funções que têm acesso ao objeto de solicitação (

req), ao objeto de resposta (res) e à próxima função de middleware no ciclo de solicitação-resposta do aplicativo. A próxima função de middleware é comumente denotada por uma variável chamadanext.

As funções de middleware podem executar as seguintes tarefas:

- Execute qualquer código.

- Faça alterações na solicitação e nos objetos de resposta.

- Encerre o ciclo de solicitação-resposta.

- Chame a próxima função de middleware na pilha.

Em outras palavras, uma função de middleware é uma função personalizada que nós (o desenvolvedor) podemos definir e que atuará como um intermediário entre quando o Express recebe a solicitação e quando nossa função de retorno de chamada apropriada é acionada. Podemos fazer uma função de log , por exemplo, que registrará toda vez que uma solicitação for feita. Observe que também podemos optar por fazer com que essas funções de middleware sejam acionadas depois que nosso endpoint for acionado, dependendo de onde você o colocar na pilha - algo que veremos mais tarde.

Para especificar o middleware personalizado, temos que defini-lo como uma função e passá-lo para app.use(...) .

const myMiddleware = (req, res, next) => { console.log(`Middleware has fired at time ${Date().now}`); next(); } app.use(myMiddleware); // This is the app variable returned from express().Todos juntos, temos agora:

// Getting the module from node_modules. const express = require('express'); // Creating our Express Application. const app = express(); // Our middleware function. const myMiddleware = (req, res, next) => { console.log(`Middleware has fired at time ${Date().now}`); next(); } // Tell Express to use the middleware. app.use(myMiddleware); // Defining the port we'll bind to. const PORT = 3000; // Defining a new endpoint behind the "/my-test-route" route. app.get('/my-test-route', () => { console.log('A GET Request was made to /my-test-route.'); }); // Binding the server to port 3000. app.listen(PORT, () => { console.log(`Server is up on port ${PORT}.`) }); Se você fizer as solicitações pelo navegador novamente, deverá ver agora que sua função de middleware está disparando e registrando registros de data e hora. Para estimular a experimentação, tente remover a chamada para a next função e veja o que acontece.

A função de retorno de chamada de middleware é chamada com três argumentos, req , res e next . req é o parâmetro que ignoramos ao construir o manipulador GET anteriormente e é um objeto que contém informações sobre a solicitação, como cabeçalhos, cabeçalhos personalizados, parâmetros e qualquer corpo que possa ter sido enviado do cliente (como você faz com uma solicitação POST). Eu sei que estamos falando de middleware aqui, mas tanto os endpoints quanto a função de middleware são chamados com req e res . req e res serão os mesmos (a menos que um ou outro o altere) no middleware e no endpoint dentro do escopo de uma única solicitação do cliente. Isso significa, por exemplo, que você pode usar uma função de middleware para limpar os dados removendo quaisquer caracteres que possam ter como objetivo executar injeções SQL ou NoSQL e, em seguida, entregando a req segura ao endpoint.

res , como visto anteriormente, permite que você envie dados de volta ao cliente de várias maneiras diferentes.

next é uma função de retorno de chamada que você deve executar quando o middleware terminar de fazer seu trabalho para chamar a próxima função de middleware na pilha ou no terminal. Certifique-se de observar que você terá que chamar isso no bloco then de qualquer função assíncrona que você acionar no middleware. Dependendo da sua operação assíncrona, você pode ou não querer chamá-la no bloco catch . Ou seja, a função myMiddleware é acionada depois que a solicitação é feita do cliente, mas antes que a função de terminal da solicitação seja acionada. Quando executamos este código e fazemos uma solicitação, você deve ver a mensagem Middleware has fired... antes da mensagem A GET Request was made to... no console. Se você não chamar next() , a última parte nunca será executada — sua função de endpoint para a solicitação não será acionada.

Observe também que eu poderia ter definido essa função anonimamente, como tal (uma convenção à qual vou aderir):

app.use((req, res, next) => { console.log(`Middleware has fired at time ${Date().now}`); next(); }); Para quem é novo em JavaScript e ES6, se a maneira como o acima funciona não faz sentido imediato, o exemplo abaixo deve ajudar. Estamos simplesmente definindo uma função de retorno de chamada (a função anônima) que recebe outra função de retorno de chamada ( next ) como argumento. Chamamos uma função que recebe um argumento de função de Função de Ordem Superior. Veja da maneira abaixo - ele mostra um exemplo básico de como o Express Source Code pode funcionar nos bastidores:

console.log('Suppose a request has just been made from the client.\n'); // This is what (it's not exactly) the code behind app.use() might look like. const use = callback => { // Simple log statement to see where we are. console.log('Inside use() - the "use" function has been called.'); // This depicts the termination of the middleware. const next = () => console.log('Terminating Middleware!\n'); // Suppose req and res are defined above (Express provides them). const req = res = null; // "callback" is the "middleware" function that is passed into "use". // "next" is the above function that pretends to stop the middleware. callback(req, res, next); }; // This is analogous to the middleware function we defined earlier. // It gets passed in as "callback" in the "use" function above. const myMiddleware = (req, res, next) => { console.log('Inside the myMiddleware function!'); next(); } // Here, we are actually calling "use()" to see everything work. use(myMiddleware); console.log('Moving on to actually handle the HTTP Request or the next middleware function.'); Chamamos primeiro use que usa myMiddleware como argumento. myMiddleware , por si só, é uma função que recebe três argumentos - req , res e next . Dentro de use , myMiddlware é chamado e esses três argumentos são passados. next é uma função definida em use . myMiddleware é definido como callback no método use . Se eu tivesse colocado use , neste exemplo, em um objeto chamado app , poderíamos ter imitado totalmente a configuração do Express, embora sem nenhum soquete ou conectividade de rede.

Nesse caso, myMiddleware e callback são funções de ordem superior, porque ambos recebem funções como argumentos.

Se você executar esse código, verá a seguinte resposta:

Suppose a request has just been made from the client. Inside use() - the "use" function has been called. Inside the middleware function! Terminating Middleware! Moving on to actually handle the HTTP Request or the next middleware function.Observe que eu também poderia ter usado funções anônimas para obter o mesmo resultado:

console.log('Suppose a request has just been made from the client.'); // This is what (it's not exactly) the code behind app.use() might look like. const use = callback => { // Simple log statement to see where we are. console.log('Inside use() - the "use" function has been called.'); // This depicts the termination of the middlewear. const next = () => console.log('Terminating Middlewear!'); // Suppose req and res are defined above (Express provides them). const req = res = null; // "callback" is the function which is passed into "use". // "next" is the above function that pretends to stop the middlewear. callback(req, res, () => { console.log('Terminating Middlewear!'); }); }; // Here, we are actually calling "use()" to see everything work. use((req, res, next) => { console.log('Inside the middlewear function!'); next(); }); console.log('Moving on to actually handle the HTTP Request.');Com isso esperançosamente resolvido, agora podemos retornar à tarefa real em mãos - configurar nosso middleware.

O fato é que você normalmente terá que enviar dados por meio de uma solicitação HTTP. Você tem algumas opções diferentes para fazer isso - enviar parâmetros de consulta de URL, enviar dados que estarão acessíveis no objeto req que aprendemos anteriormente etc. Esse objeto não está disponível apenas no retorno de chamada para chamar app.use() , mas também para qualquer ponto de extremidade. Usamos undefined como um preenchimento anteriormente para que pudéssemos nos concentrar em res para enviar o HTML de volta ao cliente, mas agora precisamos acessá-lo.

app.use('/my-test-route', (req, res) => { // The req object contains client-defined data that is sent up. // The res object allows the server to send data back down. });As solicitações HTTP POST podem exigir que enviemos um objeto de corpo para o servidor. Se você tiver um formulário no cliente e pegar o nome e o e-mail do usuário, provavelmente enviará esses dados para o servidor no corpo da solicitação.

Vamos dar uma olhada em como isso pode parecer no lado do cliente:

<!DOCTYPE html> <html> <body> <form action="https://localhost:3000/email-list" method="POST" > <input type="text" name="nameInput"> <input type="email" name="emailInput"> <input type="submit"> </form> </body> </html>Do lado do servidor:

app.post('/email-list', (req, res) => { // What do we now? // How do we access the values for the user's name and email? }); Para acessar o nome e e-mail do usuário, teremos que usar um tipo específico de middleware. Isso colocará os dados em um objeto chamado body disponível em req . O Body Parser era um método popular de fazer isso, disponível pelos desenvolvedores do Express como um módulo NPM autônomo. Agora, o Express vem pré-empacotado com seu próprio middleware para fazer isso, e vamos chamá-lo assim:

app.use(express.urlencoded({ extended: true }));Agora podemos fazer:

app.post('/email-list', (req, res) => { console.log('User Name: ', req.body.nameInput); console.log('User Email: ', req.body.emailInput); }); Tudo o que isso faz é pegar qualquer entrada definida pelo usuário que é enviada do cliente e disponibilizá-la no objeto body de req . Observe que em req.body , agora temos nameInput e emailInput , que são os nomes das tags de input no HTML. Agora, esses dados definidos pelo cliente devem ser considerados perigosos (nunca, nunca confie no cliente) e precisam ser higienizados, mas abordaremos isso mais tarde.

Outro tipo de middleware fornecido pelo express é express.json() . express.json é usado para empacotar qualquer carga útil JSON enviada em uma solicitação do cliente para req.body , enquanto express.urlencoded empacotará todas as solicitações recebidas com strings, matrizes ou outros dados codificados por URL em req.body . Em resumo, ambos manipulam req.body , mas .json() é para cargas JSON e .urlencoded() é para, entre outros, parâmetros de consulta POST.

Outra maneira de dizer isso é que solicitações recebidas com um cabeçalho Content-Type: application/json (como especificar um POST Body com a API de fetch ) serão tratadas por express.json() , enquanto solicitações com cabeçalho Content-Type: application/x-www-form-urlencoded (como HTML Forms) será tratado com express.urlencoded() . Espero que agora faça sentido.

Iniciando nossas rotas CRUD para MongoDB

Observação : ao realizar solicitações de PATCH neste artigo, não seguiremos a especificação JSONPatch RFC — um problema que corrigiremos no próximo artigo desta série.

Considerando que entendemos que especificamos cada endpoint chamando a função relevante em app , passando para ela a route e uma função callback contendo os objetos request e response, podemos começar a definir nossas Rotas CRUD para a API Bookshelf. De fato, e considerando que este é um artigo introdutório, não terei o cuidado de seguir completamente as especificações HTTP e REST, nem tentarei usar a arquitetura mais limpa possível. Isso virá em um artigo futuro.

Vou abrir o arquivo server.js que estamos usando até agora e esvaziar tudo para começar a partir da lousa abaixo:

// Getting the module from node_modules. const express = require('express'); // This creates our Express App. const app = express(); // Define middleware. app.use(express.json()); app.use(express.urlencoded({ extended: true )); // Listening on port 3000 (arbitrary). // Not a TCP or UDP well-known port. // Does not require superuser privileges. const PORT = 3000; // We will build our API here. // ... // Binding our application to port 3000. app.listen(PORT, () => console.log(`Server is up on port ${PORT}.`)); Considere todo o código a seguir para ocupar a parte // ... do arquivo acima.

Para definir nossos endpoints, e porque estamos construindo uma API REST, devemos discutir a maneira correta de nomear rotas. Novamente, você deve dar uma olhada na seção HTTP do meu artigo anterior para obter mais informações. Estamos lidando com livros, então todas as rotas estarão localizadas atrás /books (a convenção de nomenclatura plural é padrão).

| Solicitação | Rota |

|---|---|

| PUBLICAR | /books |

| PEGAR | /books/id |

| CORREÇÃO | /books/id |

| EXCLUIR | /books/id |

Como você pode ver, um ID não precisa ser especificado ao postar um livro porque nós (ou melhor, MongoDB), o estaremos gerando para nós, automaticamente, do lado do servidor. Os livros GETting, PATCHing e DELETing exigirão que passemos esse ID para nosso endpoint, que discutiremos mais tarde. Por enquanto, vamos simplesmente criar os endpoints:

// HTTP POST /books app.post('/books', (req, res) => { // ... console.log('A POST Request was made!'); }); // HTTP GET /books/:id app.get('/books/:id', (req, res) => { // ... console.log(`A GET Request was made! Getting book ${req.params.id}`); }); // HTTP PATCH /books/:id app.patch('/books/:id', (req, res) => { // ... console.log(`A PATCH Request was made! Updating book ${req.params.id}`); }); // HTTP DELETE /books/:id app.delete('/books/:id', (req, res) => { // ... console.log(`A DELETE Request was made! Deleting book ${req.params.id}`); }); A sintaxe :id informa ao Express que id é um parâmetro dinâmico que será passado na URL. Temos acesso a ele no objeto params que está disponível em req . Eu sei que “nós temos acesso a ele quando req ” soa como mágica e mágica (que não existe) é perigosa em programação, mas você tem que lembrar que o Express não é uma caixa preta. É um projeto de código aberto disponível no GitHub sob uma licença do MIT. Você pode visualizar facilmente seu código-fonte se quiser ver como os parâmetros de consulta dinâmica são colocados no objeto req .

Todos juntos, agora temos o seguinte em nosso arquivo server.js :

// Getting the module from node_modules. const express = require('express'); // This creates our Express App. const app = express(); // Define middleware. app.use(express.json()); app.use(express.urlencoded({ extended: true })); // Listening on port 3000 (arbitrary). // Not a TCP or UDP well-known port. // Does not require superuser privileges. const PORT = 3000; // We will build our API here. // HTTP POST /books app.post('/books', (req, res) => { // ... console.log('A POST Request was made!'); }); // HTTP GET /books/:id app.get('/books/:id', (req, res) => { // ... console.log(`A GET Request was made! Getting book ${req.params.id}`); }); // HTTP PATCH /books/:id app.patch('/books/:id', (req, res) => { // ... console.log(`A PATCH Request was made! Updating book ${req.params.id}`); }); // HTTP DELETE /books/:id app.delete('/books/:id', (req, res) => { // ... console.log(`A DELETE Request was made! Deleting book ${req.params.id}`); }); // Binding our application to port 3000. app.listen(PORT, () => console.log(`Server is up on port ${PORT}.`)); Vá em frente e inicie o servidor, executando o node server.js a partir do terminal ou da linha de comando e visite seu navegador. Abra o Chrome Development Console e, na barra URL (Uniform Resource Locator), visite localhost:3000/books . Você já deve ver o indicador no terminal do seu sistema operacional de que o servidor está ativo, bem como a instrução de log para GET.

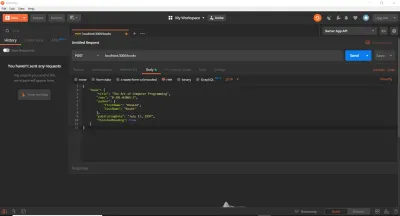

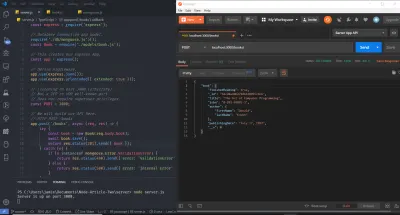

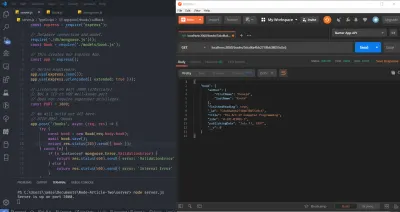

Até agora, usamos um navegador da Web para realizar solicitações GET. Isso é bom para começar, mas descobriremos rapidamente que existem ferramentas melhores para testar rotas de API. De fato, poderíamos colar as chamadas de fetch diretamente no console ou usar algum serviço online. No nosso caso, e para economizar tempo, usaremos cURL e Postman. Eu uso ambos neste artigo (embora você possa usar um ou outro) para que eu possa apresentá-los se você não os tiver usado. cURL é uma biblioteca (uma biblioteca muito, muito importante) e uma ferramenta de linha de comando projetada para transferir dados usando vários protocolos. Postman é uma ferramenta baseada em GUI para testar APIs. Depois de seguir as instruções de instalação relevantes para ambas as ferramentas em seu sistema operacional, verifique se o servidor ainda está em execução e execute os seguintes comandos (um por um) em um novo terminal. É importante digitá-los e executá-los individualmente e, em seguida, observar a mensagem de log no terminal separado do seu servidor. Além disso, observe que o símbolo de comentário da linguagem de programação padrão // não é um símbolo válido no Bash ou no MS-DOS. Você terá que omitir essas linhas, e eu as uso aqui apenas para descrever cada bloco de comandos cURL .

// HTTP POST Request (Localhost, IPv4, IPv6) curl -X POST https://localhost:3000/books curl -X POST https://127.0.0.1:3000/books curl -X POST https://[::1]:3000/books // HTTP GET Request (Localhost, IPv4, IPv6) curl -X GET https://localhost:3000/books/123abc curl -X GET https://127.0.0.1:3000/books/book-id-123 curl -X GET https://[::1]:3000/books/book-abc123 // HTTP PATCH Request (Localhost, IPv4, IPv6) curl -X PATCH https://localhost:3000/books/456 curl -X PATCH https://127.0.0.1:3000/books/218 curl -X PATCH https://[::1]:3000/books/some-id // HTTP DELETE Request (Localhost, IPv4, IPv6) curl -X DELETE https://localhost:3000/books/abc curl -X DELETE https://127.0.0.1:3000/books/314 curl -X DELETE https://[::1]:3000/books/217 Como você pode ver, o ID que é passado como um parâmetro de URL pode ser qualquer valor. O sinalizador -X especifica o tipo de solicitação HTTP (pode ser omitido para GET) e fornecemos a URL para a qual a solicitação será feita posteriormente. Dupliquei cada solicitação três vezes, permitindo que você veja que tudo ainda funciona se você usar o nome do host localhost , o endereço IPv4 ( 127.0.0.1 ) para o qual o localhost resolve ou o endereço IPv6 ( ::1 ) para o qual o localhost resolve . Observe que o cURL requer que os endereços IPv6 sejam agrupados entre colchetes.

Estamos em um lugar decente agora - temos a estrutura simples de nossas rotas e endpoints configuradas. O servidor funciona corretamente e aceita solicitações HTTP como esperamos. Ao contrário do que você pode esperar, não há muito tempo a percorrer neste momento - nós apenas temos que configurar nosso banco de dados, hospedá-lo (usando um banco de dados como serviço - MongoDB Atlas) e persistir os dados nele (e executar validação e criar respostas de erro).

Configurando um banco de dados MongoDB de produção

Para configurar um banco de dados de produção, vamos até a página inicial do MongoDB Atlas e nos inscrevemos para uma conta gratuita. Depois disso, crie um novo cluster. Você pode manter as configurações padrão, escolhendo uma região aplicável ao nível de taxa. Em seguida, clique no botão “Criar cluster”. O cluster levará algum tempo para ser criado e, em seguida, você poderá obter a URL e a senha do banco de dados. Tome nota destes quando os vir. Vamos codificá-los por enquanto e depois armazená-los em variáveis de ambiente para fins de segurança. Para obter ajuda na criação e conexão com um cluster, vou encaminhá-lo para a Documentação do MongoDB, particularmente esta página e esta página, ou você pode deixar um comentário abaixo e tentarei ajudar.

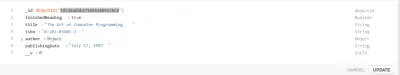

Criando um modelo de mangusto

É recomendável que você tenha uma compreensão dos significados de Documentos e Coleções no contexto de NoSQL (Not Only SQL — Structured Query Language). Para referência, você pode querer ler o Guia de início rápido do Mongoose e a seção MongoDB do meu artigo anterior.

Agora temos um banco de dados pronto para aceitar operações CRUD. Mongoose é um módulo Node (ou ODM — Object Document Mapper) que nos permitirá realizar essas operações (abstraindo algumas das complexidades), bem como configurar o esquema, ou estrutura, da coleção de banco de dados.

Como um aviso importante, há muita controvérsia em torno de ORMs e padrões como Active Record ou Data Mapper. Alguns desenvolvedores juram pelos ORMs e outros juram contra eles (acreditando que eles atrapalham). Também é importante notar que os ORMs abstraem muito, como pool de conexões, conexões de soquete e manuseio, etc. Você poderia facilmente usar o driver nativo do MongoDB (outro módulo NPM), mas daria muito mais trabalho. Embora seja recomendado que você jogue com o driver nativo antes de usar os ORMs, omito o driver nativo aqui por brevidade. Para operações SQL complexas em um banco de dados relacional, nem todos os ORMs serão otimizados para velocidade de consulta e você pode acabar escrevendo seu próprio SQL bruto. ORMs can come into play a lot with Domain-Driven Design and CQRS, among others. They are an established concept in the .NET world, and the Node.js community has not completely caught up yet — TypeORM is better, but it's not NHibernate or Entity Framework.

To create our Model, I'll create a new folder in the server directory entitled models , within which I'll create a single file with the name book.js . Thus far, our project's directory structure is as follows:

- server - node_modules - models - book.js - package.json - server.js Indeed, this directory structure is not required, but I use it here because it's simple. Allow me to note that this is not at all the kind of architecture you want to use for larger applications (and you might not even want to use JavaScript — TypeScript could be a better option), which I discuss in this article's closing. The next step will be to install mongoose , which is performed via, as you might expect, npm i mongoose .

The meaning of a Model is best ascertained from the Mongoose documentation:

Models are fancy constructors compiled from

Schemadefinitions. An instance of a model is called a document. Models are responsible for creating and reading documents from the underlying MongoDB database.

Before creating the Model, we'll define its Schema. A Schema will, among others, make certain expectations about the value of the properties provided. MongoDB is schemaless, and thus this functionality is provided by the Mongoose ODM. Let's start with a simple example. Suppose I want my database to store a user's name, email address, and password. Traditionally, as a plain old JavaScript Object (POJO), such a structure might look like this:

const userDocument = { name: 'Jamie Corkhill', email: '[email protected]', password: 'Bcrypt Hash' };If that above object was how we expected our user's object to look, then we would need to define a schema for it, like this: