Pierwsze kroki z Expressem i stosem JavaScript ES6+

Opublikowany: 2022-03-10Ten artykuł jest drugą częścią serii, z częścią pierwszą znajdującą się tutaj, która zapewnia podstawowy i (miejmy nadzieję) intuicyjny wgląd w Node.js, JavaScript ES6+, funkcje wywołania zwrotnego, funkcje strzałek, interfejsy API, protokół HTTP, JSON, MongoDB i jeszcze.

W tym artykule będziemy opierać się na umiejętnościach, które zdobyliśmy w poprzednim, nauczymy się, jak zaimplementować i wdrożyć bazę danych MongoDB do przechowywania informacji o listach użytkowników, zbudować interfejs API z Node.js i framework Express Web Application w celu udostępnienia tej bazy danych i wykonuj na nim operacje CRUD i nie tylko. Po drodze omówimy ES6 Object Destructuring, ES6 Object Shorthand, Async/Await Operator, Spread Operator, a także przyjrzymy się pokrótce CORS, Same Origin Policy i nie tylko.

W kolejnym artykule dokonamy refaktoryzacji naszej bazy kodu, aby oddzielić problemy, wykorzystując architekturę trójwarstwową i osiągając odwrócenie kontroli poprzez wstrzykiwanie zależności, wykonamy zabezpieczenia i kontrolę dostępu w oparciu o JSON Web Token i Firebase Authentication, dowiedz się, jak bezpiecznie przechowuj hasła i korzystaj z usługi AWS Simple Storage Service do przechowywania awatarów użytkowników za pomocą buforów i strumieni Node.js — przez cały czas wykorzystując PostgreSQL do utrwalania danych. Po drodze przepiszemy naszą bazę kodu od podstaw w TypeScript, aby zbadać klasyczne koncepcje OOP (takie jak polimorfizm, dziedziczenie, kompozycja itd.), a nawet wzorce projektowe, takie jak fabryki i adaptery.

Słowo ostrzeżenia

Istnieje problem z większością artykułów omawiających obecnie Node.js. Większość z nich, nie wszystkie, nie wykracza poza przedstawienie sposobu konfiguracji Express Routing, integracji Mongoose i być może wykorzystania uwierzytelniania JSON Web Token Authentication. Problem polega na tym, że nie mówią o architekturze, najlepszych praktykach bezpieczeństwa, zasadach czystego kodowania, zgodności z ACID, relacyjnych bazach danych, piątej postaci normalnej, twierdzeniu CAP czy transakcjach. Zakłada się, że wiesz o tym wszystkim, co się pojawi, albo że nie będziesz budować projektów na tyle dużych lub popularnych, aby uzasadnić wspomnianą wiedzę.

Wydaje się, że istnieje kilka różnych typów programistów węzłów — między innymi niektórzy są nowicjuszami w programowaniu w ogóle, a inni wywodzą się z długiej historii rozwoju przedsiębiorstw z C# i .NET Framework lub Java Spring Framework. Większość artykułów dotyczy pierwszej grupy.

W tym artykule zamierzam zrobić dokładnie to, co właśnie powiedziałem, że zbyt wiele artykułów robi, ale w kolejnym artykule całkowicie zrefaktoryzujemy naszą bazę kodu, co pozwoli mi wyjaśnić zasady, takie jak Dependency Injection, Three- Architektura warstw (kontroler/usługa/repozytorium), mapowanie danych i rekord aktywny, wzorce projektowe, testowanie jednostek, integracji i mutacji, zasady SOLID, jednostka pracy, kodowanie względem interfejsów, najlepsze praktyki bezpieczeństwa, takie jak HSTS, CSRF, NoSQL i SQL Injection Zapobieganie i tak dalej. Przeprowadzimy również migrację z MongoDB do PostgreSQL, używając prostego kreatora zapytań Knex zamiast ORM – co pozwoli nam zbudować własną infrastrukturę dostępu do danych oraz zbliżyć się i osobiście za pomocą Structured Query Language, różnych typów relacji (jeden- do jednego, wiele do wielu itd.) i nie tylko. Ten artykuł powinien zatem przemawiać do początkujących, ale kilka następnych powinno zadowolić bardziej średniozaawansowanych programistów, którzy chcą ulepszyć swoją architekturę.

W tym przypadku będziemy się martwić tylko o utrwalenie danych księgowych. Nie zajmiemy się uwierzytelnianiem użytkowników, haszowaniem haseł, architekturą ani niczym skomplikowanym. Wszystko to pojawi się w następnych i przyszłych artykułach. Na razie, iw zasadzie, po prostu zbudujemy metodę, która pozwoli klientowi komunikować się z naszym serwerem sieciowym za pośrednictwem protokołu HTTP w celu zapisania informacji o książkach w bazie danych.

Uwaga : celowo zachowałem to niezwykle prosto i być może nie aż tak praktyczne, ponieważ ten artykuł sam w sobie jest bardzo długi, ponieważ pozwoliłem sobie na odejście, aby omówić dodatkowe tematy. W związku z tym będziemy stopniowo poprawiać jakość i złożoność interfejsu API w tej serii, ale znowu, ponieważ uważam to za jedno z twoich pierwszych wprowadzeń do Express, celowo staram się, aby wszystko było niezwykle proste.

- ES6 Destrukturyzacja obiektów

- Skrót obiektu ES6

- Operator rozrzutu ES6 (...)

- Zbliża się...

ES6 Destrukturyzacja obiektów

ES6 Object Destructuring lub destructuring Assignment Syntax to metoda wyodrębniania lub rozpakowywania wartości z tablic lub obiektów do ich własnych zmiennych. Zaczniemy od właściwości obiektu, a następnie omówimy elementy tablicy.

const person = { name: 'Richard P. Feynman', occupation: 'Theoretical Physicist' }; // Log properties: console.log('Name:', person.name); console.log('Occupation:', person.occupation); Taka operacja jest dość prymitywna, ale może być trochę kłopotliwa, biorąc pod uwagę, że musimy wszędzie person.something się do osoby. Załóżmy, że w naszym kodzie było 10 innych miejsc, w których musielibyśmy to zrobić — byłoby to dość uciążliwe i dość szybkie. Metodą zwięzłości byłoby przypisanie tych wartości do ich własnych zmiennych.

const person = { name: 'Richard P. Feynman', occupation: 'Theoretical Physicist' }; const personName = person.name; const personOccupation = person.occupation; // Log properties: console.log('Name:', personName); console.log('Occupation:', personOccupation); Być może wygląda to rozsądnie, ale co by było, gdybyśmy mieli 10 innych właściwości zagnieżdżonych również w obiekcie person ? Byłoby wiele niepotrzebnych wierszy tylko po to, aby przypisać wartości do zmiennych — w tym momencie jesteśmy w niebezpieczeństwie, ponieważ jeśli właściwości obiektu zostaną zmutowane, nasze zmienne nie będą odzwierciedlać tej zmiany (pamiętaj, że tylko odniesienia do obiektu są niezmienne w przypadku const przypisania, nie właściwości obiektu), więc w zasadzie nie możemy dłużej utrzymywać „stanu” (a używam tego słowa luźno) w synchronizacji. Przekazywanie przez odniesienie vs przekazywanie przez wartość może mieć tutaj znaczenie, ale nie chcę odchodzić zbyt daleko od zakresu tej sekcji.

ES6 Object Destructing w zasadzie pozwala nam to zrobić:

const person = { name: 'Richard P. Feynman', occupation: 'Theoretical Physicist' }; // This is new. It's called Object Destructuring. const { name, occupation } = person; // Log properties: console.log('Name:', name); console.log('Occupation:', occupation); Nie tworzymy nowego literału obiektu/obiektu, rozpakowujemy właściwości name i occupation z oryginalnego obiektu i umieszczamy je w ich własnych zmiennych o tej samej nazwie. Nazwy, których używamy, muszą odpowiadać nazwom właściwości, które chcemy wyodrębnić.

Ponownie, składnia const { a, b } = someObject; mówi konkretnie, że oczekujemy istnienia pewnej właściwości a i pewnej właściwości b w ramach someObject (tj. someObject może być na przykład { a: 'dataA', b: 'dataB' } ) i że chcemy umieścić dowolne wartości tych kluczy/właściwości w ramach const zmiennych o tej samej nazwie. Dlatego powyższa składnia dostarczyłaby nam dwóch zmiennych const a = someObject.a i const b = someObject.b .

Oznacza to, że destrukturyzacja obiektów ma dwie strony. Strona „Szablon” i „Źródło”, gdzie strona const { a, b } (lewa strona) to szablon, a strona someObject (prawa strona) to strona źródłowa — co ma sens — definiujemy strukturę lub „szablon” po lewej stronie, który odzwierciedla dane po stronie „źródła”.

Ponownie, aby to wyjaśnić, oto kilka przykładów:

// ----- Destructure from Object Variable with const ----- // const objOne = { a: 'dataA', b: 'dataB' }; // Destructure const { a, b } = objOne; console.log(a); // dataA console.log(b); // dataB // ----- Destructure from Object Variable with let ----- // let objTwo = { c: 'dataC', d: 'dataD' }; // Destructure let { c, d } = objTwo; console.log(c); // dataC console.log(d); // dataD // Destructure from Object Literal with const ----- // const { e, f } = { e: 'dataE', f: 'dataF' }; // <-- Destructure console.log(e); // dataE console.log(f); // dataF // Destructure from Object Literal with let ----- // let { g, h } = { g: 'dataG', h: 'dataH' }; // <-- Destructure console.log(g); // dataG console.log(h); // dataHW przypadku właściwości zagnieżdżonych, odwzoruj tę samą strukturę w swoim przypisaniu destrukcyjnym:

const person = { name: 'Richard P. Feynman', occupation: { type: 'Theoretical Physicist', location: { lat: 1, lng: 2 } } }; // Attempt one: const { name, occupation } = person; console.log(name); // Richard P. Feynman console.log(occupation); // The entire `occupation` object. // Attempt two: const { occupation: { type, location } } = person; console.log(type); // Theoretical Physicist console.log(location) // The entire `location` object. // Attempt three: const { occupation: { location: { lat, lng } } } = person; console.log(lat); // 1 console.log(lng); // 2Jak widać, właściwości, które zdecydujesz się pobrać, są opcjonalne, a aby rozpakować właściwości zagnieżdżone, po prostu odzwierciedlaj strukturę oryginalnego obiektu (źródła) po stronie szablonu swojej składni destrukturyzacyjnej. Jeśli spróbujesz zdestrukturyzować właściwość, która nie istnieje w oryginalnym obiekcie, ta wartość będzie niezdefiniowana.

Możemy dodatkowo zdestrukturyzować zmienną bez wcześniejszej deklaracji — przypisanie bez deklaracji — używając następującej składni:

let name, occupation; const person = { name: 'Richard P. Feynman', occupation: 'Theoretical Physicist' }; ;({ name, occupation } = person); console.log(name); // Richard P. Feynman console.log(occupation); // Theoretical PhysicistWyrażenie poprzedzamy średnikiem, aby upewnić się, że przypadkowo nie utworzymy IIFE (Immediately Invoked Function Expression) z funkcją w poprzednim wierszu (jeśli taka funkcja istnieje), a nawiasy wokół instrukcji przypisania są wymagane, aby powstrzymaj JavaScript przed traktowaniem lewej strony (szablonu) jako bloku.

Bardzo powszechny przypadek użycia destrukturyzacji występuje w argumentach funkcji:

const config = { baseUrl: '<baseURL>', awsBucket: '<bucket>', secret: '<secret-key>' // <- Make this an env var. }; // Destructures `baseUrl` and `awsBucket` off `config`. const performOperation = ({ baseUrl, awsBucket }) => { fetch(baseUrl).then(() => console.log('Done')); console.log(awsBucket); // <bucket> }; performOperation(config);Jak widać, mogliśmy po prostu użyć normalnej składni destrukturyzacyjnej, do której jesteśmy teraz przyzwyczajeni, wewnątrz funkcji, na przykład:

const config = { baseUrl: '<baseURL>', awsBucket: '<bucket>', secret: '<secret-key>' // <- Make this an env var. }; const performOperation = someConfig => { const { baseUrl, awsBucket } = someConfig; fetch(baseUrl).then(() => console.log('Done')); console.log(awsBucket); // <bucket> }; performOperation(config);Ale umieszczenie wspomnianej składni w sygnaturze funkcji powoduje automatyczną destrukturyzację i oszczędza nam linię.

Rzeczywisty przypadek użycia tego znajduje się w React Functional Components dla props :

import React from 'react'; // Destructure `titleText` and `secondaryText` from `props`. export default ({ titleText, secondaryText }) => ( <div> <h1>{titleText}</h1> <h3>{secondaryText}</h3> </div> );W przeciwieństwie do:

import React from 'react'; export default props => ( <div> <h1>{props.titleText}</h1> <h3>{props.secondaryText}</h3> </div> );W obu przypadkach możemy również ustawić domyślne wartości właściwości:

const personOne = { name: 'User One', password: 'BCrypt Hash' }; const personTwo = { password: 'BCrypt Hash' }; const createUser = ({ name = 'Anonymous', password }) => { if (!password) throw new Error('InvalidArgumentException'); console.log(name); console.log(password); return { id: Math.random().toString(36) // <--- Should follow RFC 4122 Spec in real app. .substring(2, 15) + Math.random() .toString(36).substring(2, 15), name: name, // <-- We'll discuss this next. password: password // <-- We'll discuss this next. }; } createUser(personOne); // User One, BCrypt Hash createUser(personTwo); // Anonymous, BCrypt Hash Jak widać, w przypadku, gdy ta name nie jest obecna podczas destrukturyzacji, podajemy jej wartość domyślną. Możemy to zrobić również z poprzednią składnią:

const { a, b, c = 'Default' } = { a: 'dataA', b: 'dataB' }; console.log(a); // dataA console.log(b); // dataB console.log(c); // DefaultTablice można również destrukturyzować:

const myArr = [4, 3]; // Destructuring happens here. const [valOne, valTwo] = myArr; console.log(valOne); // 4 console.log(valTwo); // 3 // ----- Destructuring without assignment: ----- // let a, b; // Destructuring happens here. ;([a, b] = [10, 2]); console.log(a + b); // 12Praktyczny powód destrukturyzacji tablicy występuje w przypadku haków reakcyjnych. (I jest wiele innych powodów, po prostu używam Reacta jako przykładu).

import React, { useState } from "react"; export default () => { const [buttonText, setButtonText] = useState("Default"); return ( <button onClick={() => setButtonText("Toggled")}> {buttonText} </button> ); } Zauważ, że useState jest destrukturyzowana przez eksport, a funkcje/wartości tablicowe są destrukturyzowane przez hak useState . Ponownie, nie martw się, jeśli powyższe nie ma sensu — musisz zrozumieć React — a ja używam go tylko jako przykładu.

Chociaż destrukturyzacja obiektów w ES6 to coś więcej, omówię tutaj jeszcze jeden temat: Destrukturyzacja Zmiana nazwy, która jest przydatna, aby zapobiec kolizjom zakresów lub zmiennym cieniom itp. Załóżmy, że chcemy zdestrukturyzować właściwość o nazwie name z obiektu o nazwie person , ale istnieje już zmienna o nazwie name w zakresie. Możemy zmienić nazwę w locie za pomocą dwukropka:

// JS Destructuring Naming Collision Example: const name = 'Jamie Corkhill'; const person = { name: 'Alan Turing' }; // Rename `name` from `person` to `personName` after destructuring. const { name: personName } = person; console.log(name); // Jamie Corkhill <-- As expected. console.log(personName); // Alan Turing <-- Variable was renamed.Na koniec możemy ustawić wartości domyślne ze zmianą nazwy:

const name = 'Jamie Corkhill'; const person = { location: 'New York City, United States' }; const { name: personName = 'Anonymous', location } = person; console.log(name); // Jamie Corkhill console.log(personName); // Anonymous console.log(location); // New York City, United States Jak widać, w tym przypadku name person ( person.name ) zostanie zmieniona na personName i ustawiona na domyślną wartość Anonymous , jeśli nie istnieje.

I oczywiście to samo można wykonać w sygnaturach funkcji:

const personOne = { name: 'User One', password: 'BCrypt Hash' }; const personTwo = { password: 'BCrypt Hash' }; const createUser = ({ name: personName = 'Anonymous', password }) => { if (!password) throw new Error('InvalidArgumentException'); console.log(personName); console.log(password); return { id: Math.random().toString(36).substring(2, 15) + Math.random().toString(36).substring(2, 15), name: personName, password: password // <-- We'll discuss this next. }; } createUser(personOne); // User One, BCrypt Hash createUser(personTwo); // Anonymous, BCrypt HashSkrót obiektu ES6

Załóżmy, że masz następującą fabrykę: (fabryki omówimy później)

const createPersonFactory = (name, location, position) => ({ name: name, location: location, position: position }); Można użyć tej fabryki do stworzenia obiektu person w następujący sposób. Należy również zauważyć, że fabryka niejawnie zwraca obiekt, co widać po nawiasach wokół nawiasów funkcji strzałek.

const person = createPersonFactory('Jamie', 'Texas', 'Developer'); console.log(person); // { ... } To już wiemy ze składni literowej obiektu ES5. Zwróć jednak uwagę, że w funkcji fabryki wartość każdej właściwości jest taka sama jak identyfikator właściwości (klucz). To znaczy — location: location lub name: name . Okazało się, że było to dość częste zjawisko wśród programistów JS.

Używając skróconej składni z ES6, możemy osiągnąć ten sam wynik, przepisując fabrykę w następujący sposób:

const createPersonFactory = (name, location, position) => ({ name, location, position }); const person = createPersonFactory('Jamie', 'Texas', 'Developer'); console.log(person);Wytwarzanie wyjścia:

{ name: 'Jamie', location: 'Texas', position: 'Developer' }Ważne jest, aby zdać sobie sprawę, że możemy użyć tego skrótu tylko wtedy, gdy obiekt, który chcemy utworzyć, jest tworzony dynamicznie na podstawie zmiennych, gdzie nazwy zmiennych są takie same, jak nazwy właściwości, do których chcemy przypisać zmienne.

Ta sama składnia działa z wartościami obiektów:

const createPersonFactory = (name, location, position, extra) => ({ name, location, position, extra // <- right here. }); const extra = { interests: [ 'Mathematics', 'Quantum Mechanics', 'Spacecraft Launch Systems' ], favoriteLanguages: [ 'JavaScript', 'C#' ] }; const person = createPersonFactory('Jamie', 'Texas', 'Developer', extra); console.log(person);Wytwarzanie wyjścia:

{ name: 'Jamie', location: 'Texas', position: 'Developer', extra: { interests: [ 'Mathematics', 'Quantum Mechanics', 'Spacecraft Launch Systems' ], favoriteLanguages: [ 'JavaScript', 'C#' ] } }Jako ostatni przykład działa to również z literałami obiektowymi:

const id = '314159265358979'; const name = 'Archimedes of Syracuse'; const location = 'Syracuse'; const greatMathematician = { id, name, location };Operator rozprzestrzeniania się ES6 (…)

Operator rozproszenia pozwala nam robić różne rzeczy, niektóre z nich omówimy tutaj.

Po pierwsze, możemy rozłożyć właściwości z jednego obiektu na inny:

const myObjOne = { a: 'a', b: 'b' }; const myObjTwo = { ...myObjOne }: Powoduje to umieszczenie wszystkich właściwości myObjOne na myObjTwo , tak że myObjTwo to teraz { a: 'a', b: 'b' } . Możemy użyć tej metody do zastąpienia poprzednich właściwości. Załóżmy, że użytkownik chce zaktualizować swoje konto:

const user = { name: 'John Doe', email: '[email protected]', password: ' ', bio: 'Lorem ipsum' }; const updates = { password: ' ', bio: 'Ipsum lorem', email: '[email protected]' }; const updatedUser = { ...user, // <- original ...updates // <- updates }; console.log(updatedUser); /* { name: 'John Doe', email: '[email protected]', // Updated password: ' ', // Updated bio: 'Ipsum lorem' } */const user = { name: 'John Doe', email: '[email protected]', password: ' ', bio: 'Lorem ipsum' }; const updates = { password: ' ', bio: 'Ipsum lorem', email: '[email protected]' }; const updatedUser = { ...user, // <- original ...updates // <- updates }; console.log(updatedUser); /* { name: 'John Doe', email: '[email protected]', // Updated password: ' ', // Updated bio: 'Ipsum lorem' } */const user = { name: 'John Doe', email: '[email protected]', password: ' ', bio: 'Lorem ipsum' }; const updates = { password: ' ', bio: 'Ipsum lorem', email: '[email protected]' }; const updatedUser = { ...user, // <- original ...updates // <- updates }; console.log(updatedUser); /* { name: 'John Doe', email: '[email protected]', // Updated password: ' ', // Updated bio: 'Ipsum lorem' } */const user = { name: 'John Doe', email: '[email protected]', password: ' ', bio: 'Lorem ipsum' }; const updates = { password: ' ', bio: 'Ipsum lorem', email: '[email protected]' }; const updatedUser = { ...user, // <- original ...updates // <- updates }; console.log(updatedUser); /* { name: 'John Doe', email: '[email protected]', // Updated password: ' ', // Updated bio: 'Ipsum lorem' } */

To samo można wykonać z tablicami:

const apollo13Astronauts = ['Jim', 'Jack', 'Fred']; const apollo11Astronauts = ['Neil', 'Buz', 'Michael']; const unionOfAstronauts = [...apollo13Astronauts, ...apollo11Astronauts]; console.log(unionOfAstronauts); // ['Jim', 'Jack', 'Fred', 'Neil', 'Buz, 'Michael'];Zauważ, że utworzyliśmy połączenie obu zestawów (tablic), rozkładając tablice na nową tablicę.

Operator odpoczynku/rozkładania ma o wiele więcej, ale wykracza to poza zakres tego artykułu. Można go na przykład użyć do uzyskania wielu argumentów funkcji. Jeśli chcesz dowiedzieć się więcej, przejrzyj dokumentację MDN tutaj.

ES6 Async/Oczekiwanie

Async/Await to składnia łagodząca ból związany z łączeniem obietnic.

Zastrzeżone słowo kluczowe await pozwala na „oczekiwanie” na rozliczenie obietnicy, ale może być używane tylko w funkcjach oznaczonych słowem kluczowym async . Załóżmy, że mam funkcję, która zwraca obietnicę. W nowej funkcji async mogę await na wynik tej obietnicy zamiast używać .then i .catch .

// Returns a promise. const myFunctionThatReturnsAPromise = () => { return new Promise((resolve, reject) => { setTimeout(() => resolve('Hello'), 3000); }); } const myAsyncFunction = async () => { const promiseResolutionResult = await myFunctionThatReturnsAPromise(); console.log(promiseResolutionResult); }; // Writes the log statement after three seconds. myAsyncFunction(); Należy tutaj zwrócić uwagę na kilka rzeczy. Kiedy używamy await w funkcji async , tylko rozwiązana wartość trafia do zmiennej po lewej stronie. Jeśli funkcja odrzuca, jest to błąd, który musimy wyłapać, jak zobaczymy za chwilę. Ponadto każda funkcja oznaczona jako async domyślnie zwróci obietnicę.

Załóżmy, że musiałem wykonać dwa wywołania API, jedno z odpowiedzią z pierwszego. Używając obietnic i łańcuchów obietnic, możesz to zrobić w ten sposób:

const makeAPICall = route => new Promise((resolve, reject) => { console.log(route) resolve(route); }); const main = () => { makeAPICall('/whatever') .then(response => makeAPICall(response + ' second call')) .then(response => console.log(response + ' logged')) .catch(err => console.error(err)) }; main(); // Result: /* /whatever /whatever second call /whatever second call logged */ To, co się tutaj dzieje, polega na tym, że najpierw wywołujemy makeAPICall przekazując do niego /whatever , który jest rejestrowany za pierwszym razem. Obietnica rozwiązuje się z tą wartością. Następnie ponownie wywołujemy makeAPICall , przekazując do niego /whatever second call , które jest rejestrowane, i ponownie obietnica zostaje rozwiązana z tą nową wartością. Na koniec bierzemy tę nową wartość /whatever second call , za pomocą którego właśnie rozwiązano obietnicę, i logujemy ją sami w końcowym dzienniku, dopisując na końcu logged . Jeśli to nie ma sensu, powinieneś przyjrzeć się wiązaniu obietnic.

Używając async / await , możemy dokonać refaktoryzacji do następującego:

const main = async () => { const resultOne = await makeAPICall('/whatever'); const resultTwo = await makeAPICall(resultOne + ' second call'); console.log(resultTwo + ' logged'); }; Oto, co się stanie. Cała funkcja przestanie wykonywać przy pierwszej instrukcji await , dopóki nie zostanie rozwiązana obietnica z pierwszego wywołania makeAPICall , po rozwiązaniu rozwiązana wartość zostanie umieszczona w resultOne . Kiedy tak się stanie, funkcja przejdzie do drugiej instrukcji await , ponownie zatrzymując się tam na czas realizacji obietnicy. Gdy obietnica zostanie rozwiązana, wynik rozstrzygnięcia zostanie umieszczony w resultTwo . Jeśli pomysł na wykonanie funkcji brzmi blokująco, nie obawiaj się, nadal jest asynchroniczny, a za chwilę omówię dlaczego.

To tylko przedstawia „szczęśliwą” ścieżkę. W przypadku odrzucenia jednej z obietnic, możemy to złapać za pomocą try/catch, ponieważ jeśli obietnica zostanie odrzucona, zostanie zgłoszony błąd — który będzie dowolnym błędem, z którym odrzucono obietnicę.

const main = async () => { try { const resultOne = await makeAPICall('/whatever'); const resultTwo = await makeAPICall(resultOne + ' second call'); console.log(resultTwo + ' logged'); } catch (e) { console.log(e) } }; Jak powiedziałem wcześniej, każda funkcja zadeklarowana jako async zwróci obietnicę. Tak więc, jeśli chcesz wywołać funkcję asynchroniczną z innej funkcji, możesz użyć normalnych obietnic lub await , jeśli zadeklarujesz funkcję wywołującą async . Jeśli jednak chcesz wywołać funkcję async z kodu najwyższego poziomu i czekać na jej wynik, musisz użyć .then i .catch .

Na przykład:

const returnNumberOne = async () => 1; returnNumberOne().then(value => console.log(value)); // 1Lub możesz użyć natychmiastowo wywołanego wyrażenia funkcji (IIFE):

(async () => { const value = await returnNumberOne(); console.log(value); // 1 })(); Gdy używasz await w funkcji async , wykonywanie funkcji zostanie zatrzymane na tej instrukcji await do momentu spełnienia obietnicy. Jednak wszystkie inne funkcje mogą kontynuować wykonywanie, dlatego nie są przydzielane żadne dodatkowe zasoby procesora ani wątek nigdy nie jest blokowany. Powiem to jeszcze raz — operacje w tej konkretnej funkcji w tym konkretnym czasie zostaną zatrzymane do czasu spełnienia obietnicy, ale wszystkie inne funkcje można uruchomić za darmo. Rozważmy serwer WWW HTTP — na podstawie żądania wszystkie funkcje mogą być uruchamiane za darmo dla wszystkich użytkowników jednocześnie w miarę składania żądań, po prostu składnia async/await zapewni iluzję , że operacja jest synchroniczna i blokuje obiecuje, że łatwiej się z tym pracuje, ale znowu wszystko pozostanie ładne i asynchroniczne.

To nie wszystko, co trzeba zrobić, aby async / await , ale powinno to pomóc w zrozumieniu podstawowych zasad.

Klasyczne fabryki OOP

Teraz opuścimy świat JavaScript i wejdziemy do świata Javy . Może nadejść czas, kiedy proces tworzenia obiektu (w tym przypadku instancji klasy — znowu Java) jest dość złożony lub gdy chcemy stworzyć różne obiekty na podstawie szeregu parametrów. Przykładem może być funkcja, która tworzy różne obiekty błędów. Fabryka jest powszechnym wzorcem projektowym w programowaniu zorientowanym obiektowo i jest w zasadzie funkcją, która tworzy obiekty. Aby to zbadać, odejdźmy od JavaScriptu do świata Javy. Będzie to miało sens dla programistów, którzy wywodzą się z klasycznego OOP (tj. nie prototypowego), statycznie wpisanego języka. Jeśli nie jesteś jednym z takich programistów, możesz pominąć tę sekcję. Jest to małe odchylenie, więc jeśli podążanie w tym miejscu zakłóci przepływ JavaScript, to ponownie pomiń tę sekcję.

Powszechny wzorzec twórczy, wzorzec fabryki, pozwala nam tworzyć obiekty bez ujawniania wymaganej logiki biznesowej do wykonania wspomnianego tworzenia.

Załóżmy, że piszemy program, który pozwala nam wizualizować kształty pierwotne w n-wymiarach. Jeśli dostarczymy sześcian, na przykład, zobaczymy sześcian 2D (kwadrat), sześcian 3D (sześcian) i sześcian 4D (Tesseract lub Hypercube). Oto, jak można to zrobić, trywialnie i z wyłączeniem rzeczywistej części rysunkowej, w Javie.

// Main.java // Defining an interface for the shape (can be used as a base type) interface IShape { void draw(); } // Implementing the interface for 2-dimensions: class TwoDimensions implements IShape { @Override public void draw() { System.out.println("Drawing a shape in 2D."); } } // Implementing the interface for 3-dimensions: class ThreeDimensions implements IShape { @Override public void draw() { System.out.println("Drawing a shape in 3D."); } } // Implementing the interface for 4-dimensions: class FourDimensions implements IShape { @Override public void draw() { System.out.println("Drawing a shape in 4D."); } } // Handles object creation class ShapeFactory { // Factory method (notice return type is the base interface) public IShape createShape(int dimensions) { switch(dimensions) { case 2: return new TwoDimensions(); case 3: return new ThreeDimensions(); case 4: return new FourDimensions(); default: throw new IllegalArgumentException("Invalid dimension."); } } } // Main class and entry point. public class Main { public static void main(String[] args) throws Exception { ShapeFactory shapeFactory = new ShapeFactory(); IShape fourDimensions = shapeFactory.createShape(4); fourDimensions.draw(); // Drawing a shape in 4D. } } Jak widać, definiujemy interfejs, który określa sposób rysowania kształtu. Mając różne klasy implementujące interfejs, możemy zagwarantować, że wszystkie kształty mogą zostać narysowane (ponieważ wszystkie muszą mieć nadpisaną metodę draw zgodnie z definicją interfejsu). Biorąc pod uwagę, że ten kształt jest rysowany w różny sposób w zależności od wymiarów, w których jest oglądany, definiujemy klasy pomocnicze, które implementują interfejs, aby wykonywać intensywną pracę GPU polegającą na symulowaniu renderowania n-wymiarowego. ShapeFactory wykonuje pracę polegającą na tworzeniu instancji właściwej klasy — metoda createShape jest fabryką i podobnie jak powyższa definicja jest metodą zwracającą obiekt klasy. Typem zwracanym przez createShape jest interfejs IShape , ponieważ interfejs IShape jest typem podstawowym wszystkich kształtów (ponieważ mają metodę draw ).

Ten przykład Javy jest dość trywialny, ale możesz łatwo zobaczyć, jak przydatny staje się w większych aplikacjach, w których konfiguracja tworzenia obiektu może nie być taka prosta. Przykładem może być gra wideo. Załóżmy, że użytkownik musi przetrwać różnych wrogów. Klasy abstrakcyjne i interfejsy mogą być używane do definiowania podstawowych funkcji dostępnych dla wszystkich wrogów (i metod, które mogą być nadpisane), być może wykorzystując wzorzec delegowania (przedstawiaj kompozycję nad dziedziczeniem, jak sugerowała Gang of Four, aby nie zostać zablokowanym w rozszerzaniu pojedynczą klasę bazową oraz w celu ułatwienia testowania/mocowania/DI). W przypadku obiektów wroga utworzonych na różne sposoby interfejs umożliwiałby tworzenie obiektów fabrycznych, korzystając z ogólnego typu interfejsu. Byłoby to bardzo istotne, gdyby wróg był tworzony dynamicznie.

Innym przykładem jest funkcja konstruktora. Załóżmy, że używamy wzorca delegacji, aby delegat klasy działał z innymi klasami, które honorują interfejs. Moglibyśmy umieścić statyczną metodę build w klasie, aby skonstruowała ona własną instancję (zakładając, że nie używasz kontenera/struktury wstrzykiwania zależności). Zamiast dzwonić do każdego rozgrywającego, możesz to zrobić:

public class User { private IMessagingService msgService; private String name; private int age; public User(String name, int age, IMessagingService msgService) { this.name = name; this.age = age; this.msgService = msgService; } public static User build(String name, int age) { return new User(name, age, new SomeMessageService()); } } Wzorzec delegowania wyjaśnię w późniejszym artykule, jeśli nie jesteś z nim zaznajomiony — zasadniczo, poprzez kompozycję i pod względem modelowania obiektów, tworzy on relację „ma-a” zamiast „jest-a” związek jak w przypadku dziedziczenia. Jeśli masz klasy Mammal i Dog , a Dog rozszerza Mammal , wtedy Dog is-a Mammal . Natomiast jeśli masz klasę Bark i właśnie przekazałeś instancje Bark do konstruktora Dog , wtedy Dog has-a Bark . Jak możesz sobie wyobrazić, szczególnie ułatwia to testowanie jednostkowe, ponieważ możesz wstrzykiwać mocki i potwierdzać fakty na temat makiety, o ile makieta przestrzega kontraktu interfejsu w środowisku testowym.

Powyższa static metoda fabryki „build” po prostu tworzy nowy obiekt User i przekazuje konkretną MessageService . Zauważ, że wynika to z powyższej definicji — nie ujawniając logiki biznesowej w celu utworzenia obiektu klasy lub, w tym przypadku, nieujawnianie tworzenia usługi przesyłania wiadomości dzwoniącemu w fabryce.

Ponownie, niekoniecznie jest to sposób, w jaki robiłbyś rzeczy w prawdziwym świecie, ale całkiem dobrze przedstawia ideę funkcji/metody fabryki. Zamiast tego możemy użyć kontenera Dependency Injection. Wróćmy teraz do JavaScriptu.

Zaczynając od Express

Express to Web Application Framework for Node (dostępny za pośrednictwem modułu NPM), który pozwala na utworzenie serwera WWW HTTP. Należy zauważyć, że Express nie jest jedynym frameworkiem, który to umożliwia (istnieje Koa, Fastify itp.) i że, jak pokazano w poprzednim artykule, Node może działać bez Express jako samodzielna jednostka. (Express jest jedynie modułem zaprojektowanym dla Node — Node może bez niego robić wiele rzeczy, chociaż Express jest popularny wśród serwerów WWW).

Jeszcze raz chciałbym dokonać bardzo ważnego rozróżnienia. Istnieje dychotomia między Node/JavaScript i Express. Węzeł, środowisko uruchomieniowe/środowisko, w którym uruchamiasz JavaScript, może robić wiele rzeczy — na przykład umożliwiać tworzenie aplikacji React Native, aplikacji desktopowych, narzędzi wiersza poleceń itp. — Express to nic innego jak lekka platforma, która pozwala na używanie Node/JS do budowania serwerów internetowych w przeciwieństwie do obsługi niskopoziomowej sieci Node i interfejsów API HTTP. Nie potrzebujesz Express, aby zbudować serwer WWW.

Przed rozpoczęciem tej sekcji, jeśli nie jesteś zaznajomiony z żądaniami HTTP i HTTP (GET, POST itp.), zachęcam do przeczytania odpowiedniej sekcji mojego poprzedniego artykułu, do którego link znajduje się powyżej.

Korzystając z Express, skonfigurujemy różne trasy, do których mogą być wysyłane żądania HTTP, a także powiązane punkty końcowe (które są funkcjami zwrotnymi), które zostaną uruchomione, gdy zostanie wysłane żądanie do tej trasy. Nie martw się, jeśli trasy i punkty końcowe są obecnie bezsensowne — wyjaśnię je później.

W przeciwieństwie do innych artykułów, przyjmę podejście polegające na pisaniu kodu źródłowego na bieżąco, wiersz po wierszu, zamiast wrzucania całej bazy kodu do jednego fragmentu, a następnie wyjaśniania później. Zacznijmy od otwarcia terminala (używam Terminusa nad Git Bash w systemie Windows — co jest fajną opcją dla użytkowników systemu Windows, którzy chcą powłoki Bash bez konfigurowania podsystemu Linux), skonfigurowania szablonu naszego projektu i otwarcia go w kodzie programu Visual Studio.

mkdir server && cd server touch server.js npm init -y npm install express code . Wewnątrz pliku server.js zacznę od wymagania express przy użyciu funkcji require() .

const express = require('express'); require('express') mówi Node'owi, aby wyszedł i pobrał moduł Express, który zainstalowaliśmy wcześniej, który znajduje się obecnie w folderze node_modules (bo to właśnie robi npm install — utwórz folder node_modules i umieść tam moduły i ich zależności). Zgodnie z konwencją, i mając do czynienia z Express, zmienną przechowującą wynik zwracamy wywołujemy z require('express') express , chociaż można ją nazwać jakakolwiek.

This returned result, which we have called express , is actually a function — a function we'll have to invoke to create our Express app and set up our routes. Again, by convention, we call this app — app being the return result of express() — that is, the return result of calling the function that has the name express as express() .

const express = require('express'); const app = express(); // Note that the above variable names are the convention, but not required. // An example such as that below could also be used. const foo = require('express'); const bar = foo(); // Note also that the node module we installed is called express. The line const app = express(); simply puts a new Express Application inside of the app variable. It calls a function named express (the return result of require('express') ) and stores its return result in a constant named app . If you come from an object-oriented programming background, consider this equivalent to instantiating a new object of a class, where app would be the object and where express() would call the constructor function of the express class. Remember, JavaScript allows us to store functions in variables — functions are first-class citizens. The express variable, then, is nothing more than a mere function. It's provided to us by the developers of Express.

I apologize in advance if I'm taking a very long time to discuss what is actually very basic, but the above, although primitive, confused me quite a lot when I was first learning back-end development with Node.

Inside the Express source code, which is open-source on GitHub, the variable we called express is a function entitled createApplication , which, when invoked, performs the work necessary to create an Express Application:

A snippet of Express source code:

exports = module.exports = createApplication; /* * Create an express application */ // This is the function we are storing in the express variable. (- Jamie) function createApplication() { // This is what I mean by "Express App" (- Jamie) var app = function(req, res, next) { app.handle(req, res, next); }; mixin(app, EventEmitter.prototype, false); mixin(app, proto, false); // expose the prototype that will get set on requests app.request = Object.create(req, { app: { configurable: true, enumerable: true, writable: true, value: app } }) // expose the prototype that will get set on responses app.response = Object.create(res, { app: { configurable: true, enumerable: true, writable: true, value: app } }) app.init(); // See - `app` gets returned. (- Jamie) return app; }GitHub: https://github.com/expressjs/express/blob/master/lib/express.js

With that short deviation complete, let's continue setting up Express. Thus far, we have required the module and set up our app variable.

const express = require('express'); const app = express(); From here, we have to tell Express to listen on a port. Any HTTP Requests made to the URL and Port upon which our application is listening will be handled by Express. We do that by calling app.listen(...) , passing to it the port and a callback function which gets called when the server starts running:

const PORT = 3000; app.listen(PORT, () => console.log(`Server is up on port {PORT}.`)); We notate the PORT variable in capital by convention, for it is a constant variable that will never change. You could do that with all variables that you declare const , but that would look messy. It's up to the developer or development team to decide on notation, so we'll use the above sparsely. I use const everywhere as a method of “defensive coding” — that is, if I know that a variable is never going to change then I might as well just declare it const . Since I define everything const , I make the distinction between what variables should remain the same on a per-request basis and what variables are true actual global constants.

Here is what we have thus far:

const express = require('express'); const app = express(); const PORT = 3000; // We will build our API here. // ... // Binding our application to port 3000. app.listen(PORT, () => { console.log(`Server is up on port ${PORT}.`); });Let's test this to see if the server starts running on port 3000.

I'll open a terminal and navigate to our project's root directory. I'll then run node server/server.js . Note that this assumes you have Node already installed on your system (You can check with node -v ).

If everything works, you should see the following in the terminal:

Server is up on port 3000.

Go ahead and hit Ctrl + C to bring the server back down.

If this doesn't work for you, or if you see an error such as EADDRINUSE , then it means you may have a service already running on port 3000. Pick another port number, like 3001, 3002, 5000, 8000, etc. Be aware, lower number ports are reserved and there is an upper bound of 65535.

At this point, it's worth taking another small deviation as to understand servers and ports in the context of computer networking. We'll return to Express in a moment. I take this approach, rather than introducing servers and ports first, for the purpose of relevance. That is, it is difficult to learn a concept if you fail to see its applicability. In this way, you are already aware of the use case for ports and servers with Express, so the learning experience will be more pleasurable.

A Brief Look At Servers And Ports

A server is simply a computer or computer program that provides some sort of “functionality” to the clients that talk to it. More generally, it's a device, usually connected to the Internet, that handles connections in a pre-defined manner. In our case, that “pre-defined manner” will be HTTP or the HyperText Transfer Protocol. Servers that use the HTTP Protocol are called Web Servers.

When building an application, the server is a critical component of the “client-server model”, for it permits the sharing and syncing of data (generally via databases or file systems) across devices. It's a cross-platform approach, in a way, for the SDKs of platforms against which you may want to code — be they web, mobile, or desktop — all provide methods (APIs) to interact with a server over HTTP or TCP/UDP Sockets. It's important to make a distinction here — by APIs, I mean programming language constructs to talk to a server, like XMLHttpRequest or the Fetch API in JavaScript, or HttpUrlConnection in Java, or even HttpClient in C#/.NET. This is different from the kind of REST API we'll be building in this article to perform CRUD Operations on a database.

To talk about ports, it's important to understand how clients connect to a server. A client requires the IP Address of the server and the Port Number of our specific service on that server. An IP Address, or Internet Protocol Address, is just an address that uniquely identifies a device on a network. Public and private IPs exist, with private addresses commonly used behind a router or Network Address Translator on a local network. You might see private IP Addresses of the form 192.168.XXX.XXX or 10.0.XXX.XXX . When articulating an IP Address, decimals are called “dots”. So 192.168.0.1 (a common router IP Addr.) might be pronounced, “one nine two dot one six eight dot zero dot one”. (By the way, if you're ever in a hotel and your phone/laptop won't direct you to the AP captive portal, try typing 192.168.0.1 or 192.168.1.1 or similar directly into Chrome).

For simplicity, and since this is not an article about the complexities of computer networking, assume that an IP Address is equivalent to a house address, allowing you to uniquely identify a house (where a house is analogous to a server, client, or network device) in a neighborhood. One neighborhood is one network. Put together all of the neighborhoods in the United States, and you have the public Internet. (This is a basic view, and there are many more complexities — firewalls, NATs, ISP Tiers (Tier One, Tier Two, and Tier Three), fiber optics and fiber optic backbones, packet switches, hops, hubs, etc., subnet masks, etc., to name just a few — in the real networking world.) The traceroute Unix command can provide more insight into the above, displaying the path (and associated latency) that packets take through a network as a series of “hops”.

Numer portu identyfikuje określoną usługę działającą na serwerze. SSH lub Secure Shell, który umożliwia zdalny dostęp do powłoki do urządzenia, zwykle działa na porcie 22. FTP lub protokół przesyłania plików (który może być używany na przykład z klientem FTP do przesyłania statycznych zasobów na serwer) zwykle działa na Port 21. Możemy zatem powiedzieć, że porty są specyficznymi pokojami wewnątrz każdego domu w naszej analogii powyżej, ponieważ pokoje w domach są stworzone do różnych rzeczy – sypialnia do spania, kuchnia do przygotowywania posiłków, jadalnia do konsumpcji wspomnianego żywność itp., podobnie jak porty odpowiadają programom realizującym określone usługi. Dla nas serwery internetowe zwykle działają na porcie 80, chociaż możesz określić dowolny numer portu, o ile nie są one używane przez inne usługi (nie mogą kolidować).

Aby uzyskać dostęp do strony internetowej, potrzebujesz adresu IP strony. Mimo to zwykle uzyskujemy dostęp do stron internetowych za pośrednictwem adresu URL. Za kulisami serwer DNS lub serwer nazw domen konwertuje ten adres URL na adres IP, umożliwiając przeglądarce wykonanie żądania GET do serwera, pobranie kodu HTML i renderowanie go na ekranie. 8.8.8.8 to adres jednego z publicznych serwerów DNS firmy Google. Możesz sobie wyobrazić, że wymaganie rozwiązania nazwy hosta na adres IP za pośrednictwem zdalnego serwera DNS zajmie trochę czasu i masz rację. Aby zmniejszyć opóźnienia, systemy operacyjne mają pamięć podręczną DNS — tymczasową bazę danych, która przechowuje informacje o wyszukiwaniu DNS, zmniejszając w ten sposób częstotliwość, z jaką te wyszukiwania muszą występować. Pamięć podręczną DNS Resolver można wyświetlić w systemie Windows za pomocą polecenia ipconfig /displaydns CMD i wyczyścić za pomocą polecenia ipconfig /flushdns .

Na serwerze Unix, bardziej popularne porty o niższej liczbie, jak 80, wymagają uprawnień na poziomie administratora ( zwiększonych , jeśli pracujesz w tle Windows). Z tego powodu będziemy używać portu 3000 do naszych prac programistycznych, ale pozwolimy serwerowi wybrać numer portu (niezależnie od tego, jaki jest dostępny) podczas wdrażania w naszym środowisku produkcyjnym.

Na koniec zwróć uwagę, że możemy wpisać adresy IP bezpośrednio w pasku wyszukiwania Google Chrome, omijając w ten sposób mechanizm rozpoznawania DNS. Na przykład 216.58.194.36 spowoduje przejście do Google.com. W naszym środowisku programistycznym, używając własnego komputera jako serwera deweloperskiego, użyjemy localhost i portu 3000. Adres jest sformatowany jako hostname:port , więc nasz serwer będzie działał na localhost:3000 . Localhost lub 127.0.0.1 to adres pętli zwrotnej i oznacza adres „tego komputera”. Jest to nazwa hosta, a jej adres IPv4 jest tłumaczony na 127.0.0.1 . Spróbuj pingować localhost na swoim komputerze już teraz. Możesz otrzymać wstecz ::1 — co jest adresem sprzężenia zwrotnego IPv6 lub z powrotem 127.0.0.1 — co jest adresem sprzężenia zwrotnego IPv4. IPv4 i IPv6 to dwa różne formaty adresów IP powiązane z różnymi standardami — niektóre adresy IPv6 można przekonwertować na IPv4, ale nie wszystkie.

Powrót do ekspresu

Wspomniałem o żądaniach HTTP, czasownikach i kodach stanu w moim poprzednim artykule, Pierwsze kroki z węzłem: wprowadzenie do API, HTTP i ES6+ JavaScript. Jeśli nie masz ogólnej wiedzy na temat protokołu, możesz przejść do sekcji „Żądania HTTP i HTTP” tego fragmentu.

Aby poznać Express, po prostu skonfigurujemy nasze punkty końcowe dla czterech podstawowych operacji, które będziemy wykonywać na bazie danych — Create, Read, Update i Delete, znanych pod wspólną nazwą CRUD.

Pamiętaj, że uzyskujemy dostęp do punktów końcowych za pomocą tras w adresie URL. Oznacza to, że chociaż słowa „trasa” i „punkt końcowy” są powszechnie używane zamiennie, punkt końcowy jest technicznie funkcją języka programowania (jak funkcje strzałek ES6), która wykonuje pewne operacje po stronie serwera, podczas gdy trasa jest tym, za czym znajduje się punkt końcowy z . Określamy te punkty końcowe jako funkcje zwrotne, które Express uruchomi, gdy odpowiednie żądanie zostanie wysłane od klienta do trasy , za którą znajduje się punkt końcowy. Możesz zapamiętać powyższe, zdając sobie sprawę, że to punkty końcowe pełnią funkcję, a trasa jest nazwą używaną do uzyskania dostępu do punktów końcowych. Jak zobaczymy, ta sama trasa może być powiązana z wieloma punktami końcowymi przy użyciu różnych czasowników HTTP (podobnie do przeciążania metod, jeśli pochodzisz z klasycznego środowiska OOP z polimorfizmem).

Należy pamiętać, że postępujemy zgodnie z architekturą REST (Representational State Transfer), umożliwiając klientom przesyłanie żądań do naszego serwera. W końcu jest to REST lub RESTful API. Konkretne żądania skierowane do określonych tras uruchomią określone punkty końcowe , które wykonają określone czynności . Przykładem takiej „rzeczy”, jaką może zrobić punkt końcowy, jest dodawanie nowych danych do bazy danych, usuwanie danych, aktualizowanie danych itp.

Express wie, jaki punkt końcowy uruchomić, ponieważ mówimy mu wprost o metodzie żądania (GET, POST itp.) i trasie — definiujemy, jakie funkcje mają być uruchamiane dla konkretnych kombinacji powyższych, a klient wykonuje żądanie, podając trasa i metoda. Mówiąc prościej, w Node powiemy Expressowi — „Hej, jeśli ktoś wysyła żądanie GET do tej trasy, uruchom tę funkcję (użyj tego punktu końcowego)”. Sprawy mogą być bardziej skomplikowane: „Ekspresowo, jeśli ktoś wysyła żądanie GET do tej trasy, ale nie wyśle prawidłowego tokena na okaziciela autoryzacji w nagłówku żądania, odpowiedz za pomocą HTTP 401 Unauthorized . Jeśli posiadają ważny token okaziciela, wyślij dowolny chroniony zasób, którego szukali, uruchamiając punkt końcowy. Bardzo dziękuję i życzę miłego dnia.” Rzeczywiście, byłoby fajnie, gdyby języki programowania były na tak wysokim poziomie bez wyciekania niejednoznaczności, ale mimo to demonstruje podstawowe koncepcje.

Pamiętaj, że punkt końcowy w pewnym sensie znajduje się za trasą. Dlatego konieczne jest, aby klient podał w nagłówku żądania, jakiej metody chce użyć, aby Express mógł dowiedzieć się, co zrobić. Żądanie zostanie skierowane na konkretną trasę, którą klient określi (wraz z typem żądania) kontaktując się z serwerem, co pozwoli Expressowi zrobić to, co musi, a nam zrobić to, co musimy zrobić, gdy Express uruchomi nasze wywołania zwrotne . Do tego to wszystko się sprowadza.

We wcześniejszych przykładach kodu wywołaliśmy funkcję listen , która była dostępna w app , przekazując jej port i callback. sama app , jeśli pamiętasz, jest wynikiem powrotu wywołania zmiennej express jako funkcji (czyli express() ), a zmienna express jest tym, co nazwaliśmy wynikiem zwrotu z wymagania 'express' z naszego folderu node_modules . Podobnie jak listen jest wywoływane w app , określamy punkty końcowe żądania HTTP wywołując je w app . Spójrzmy na GET:

app.get('/my-test-route', () => { // ... }); Pierwszym parametrem jest string i jest to trasa, za którą będzie żył punkt końcowy. Funkcja zwrotna jest punktem końcowym. Powiem to jeszcze raz: funkcja wywołania zwrotnego — drugi parametr — jest punktem końcowym , który zostanie uruchomiony, gdy żądanie HTTP GET zostanie wysłane do dowolnej trasy określonej jako pierwszy argument (w tym przypadku /my-test-route ).

Teraz, zanim zaczniemy dalszą pracę z Express, musimy wiedzieć, jak działają trasy. Trasa określona jako ciąg zostanie wywołana przez wysłanie żądania do www.domain.com/the-route-we-chose-earlier-as-a-string . W naszym przypadku domeną jest localhost:3000 , co oznacza, że aby uruchomić powyższą funkcję zwrotną, musimy wykonać żądanie GET do localhost:3000/my-test-route . Gdybyśmy użyli innego ciągu jako pierwszego argumentu powyżej, URL musiałby być inny, aby pasował do tego, co określiliśmy w JavaScript.

Mówiąc o takich rzeczach, prawdopodobnie usłyszysz o Glob Patterns. Moglibyśmy powiedzieć, że wszystkie nasze trasy API znajdują się na localhost:3000/** Wzorzec Glob, gdzie ** to symbol wieloznaczny oznaczający dowolny katalog lub podkatalog (zwróć uwagę, że trasy nie są katalogami), których root jest nadrzędnym — to znaczy wszystko.

Przejdźmy dalej i dodajmy instrukcję log do tej funkcji zwrotnej, abyśmy w sumie mieli:

// Getting the module from node_modules. const express = require('express'); // Creating our Express Application. const app = express(); // Defining the port we'll bind to. const PORT = 3000; // Defining a new endpoint behind the "/my-test-route" route. app.get('/my-test-route', () => { console.log('A GET Request was made to /my-test-route.'); }); // Binding the server to port 3000. app.listen(PORT, () => { console.log(`Server is up on port ${PORT}.`) }); Uruchomimy nasz serwer, wykonując node server/server.js (z Node zainstalowanym w naszym systemie i dostępnym globalnie ze zmiennych środowiskowych systemu) w katalogu głównym projektu. Tak jak wcześniej, powinieneś zobaczyć komunikat, że serwer jest włączony w konsoli. Teraz, gdy serwer działa, otwórz przeglądarkę i odwiedź localhost:3000 w pasku adresu URL.

Powinieneś zostać powitany komunikatem o błędzie z informacją, że Cannot GET / . Naciśnij Ctrl + Shift + I w systemie Windows w Chrome, aby wyświetlić konsolę programisty. Tam powinieneś zobaczyć, że mamy 404 (Nie znaleziono zasobu). To ma sens — powiedzieliśmy serwerowi tylko, co ma zrobić, gdy ktoś odwiedzi localhost:3000/my-test-route . Przeglądarka nie ma nic do renderowania na localhost:3000 (co jest odpowiednikiem localhost:3000/ z ukośnikiem).

Jeśli spojrzysz na okno terminala, w którym działa serwer, nie powinno być żadnych nowych danych. Teraz odwiedź localhost:3000/my-test-route w pasku adresu przeglądarki. Możesz zobaczyć ten sam błąd w konsoli Chrome (ponieważ przeglądarka buforuje zawartość i nadal nie ma kodu HTML do renderowania), ale jeśli spojrzysz na terminal, na którym działa proces serwera, zobaczysz, że funkcja wywołania zwrotnego rzeczywiście się uruchomiła i komunikat dziennika rzeczywiście został zarejestrowany.

Wyłącz serwer za pomocą Ctrl + C.

Teraz dajmy przeglądarce coś do renderowania, gdy do tej trasy zostanie wysłane żądanie GET, abyśmy mogli stracić komunikat Cannot GET / . Wezmę naszą app.get() z wcześniejszej wersji, aw funkcji wywołania zwrotnego dodam dwa argumenty. Pamiętaj, że funkcja wywołania zwrotnego, którą przekazujemy, jest wywoływana przez Express za kulisami, a Express może dodać dowolne argumenty. Właściwie dodaje dwa (cóż, technicznie trzy, ale zobaczymy to później) i chociaż oba są niezwykle ważne, na razie nie obchodzi nas pierwszy. Drugi argument nazywa się res , skrót od response , i uzyskam do niego dostęp, ustawiając undefined jako pierwszy parametr:

app.get('/my-test-route', (undefined, res) => { console.log('A GET Request was made to /my-test-route.'); }); Ponownie możemy wywołać argument res , jak tylko chcemy, ale res jest konwencją w przypadku Express. res jest w rzeczywistości obiektem, a na jego podstawie istnieją różne metody wysyłania danych z powrotem do klienta. W tym przypadku zamierzam uzyskać dostęp do funkcji send(...) dostępnej w res , aby odesłać HTML, który wyrenderuje przeglądarka. Nie ograniczamy się jednak do odsyłania HTML i możemy zdecydować się na odesłanie tekstu, obiektu JavaScript, strumienia (strumienie są szczególnie piękne) lub cokolwiek innego.

app.get('/my-test-route', (undefined, res) => { console.log('A GET Request was made to /my-test-route.'); res.send('<h1>Hello, World!</h1>'); }); Jeśli zamkniesz serwer, a następnie przywrócisz go z powrotem, a następnie odświeżysz przeglądarkę na trasie /my-test-route , zobaczysz renderowany kod HTML.

Karta Sieć w narzędziach dla programistów Chrome pozwoli Ci zobaczyć to żądanie GET z bardziej szczegółowymi informacjami dotyczącymi nagłówków.

W tym momencie dobrze nam przysłuży się rozpoczęcie nauki o Express Middleware — funkcjach, które mogą być uruchamiane globalnie po złożeniu żądania przez klienta.

Ekspresowe oprogramowanie pośredniczące

Express udostępnia metody, za pomocą których można zdefiniować niestandardowe oprogramowanie pośredniczące dla aplikacji. Rzeczywiście, znaczenie Express Middleware jest najlepiej zdefiniowane w Express Docs, tutaj)

Funkcje oprogramowania pośredniego to funkcje, które mają dostęp do obiektu żądania (

req), obiektu odpowiedzi (res) i następnej funkcji oprogramowania pośredniego w cyklu żądanie-odpowiedź aplikacji. Następna funkcja oprogramowania pośredniego jest zwykle oznaczana przez zmienną o nazwienext.

Funkcje oprogramowania pośredniego mogą wykonywać następujące zadania:

- Wykonaj dowolny kod.

- Wprowadź zmiany w obiektach żądania i odpowiedzi.

- Zakończ cykl żądanie-odpowiedź.

- Wywołaj następną funkcję oprogramowania pośredniego na stosie.

Innymi słowy, funkcja oprogramowania pośredniego to funkcja niestandardowa, którą możemy (programista) zdefiniować i która będzie działać jako pośrednik między momentem odebrania żądania przez Express, a uruchomieniem naszej odpowiedniej funkcji zwrotnej. Możemy na przykład stworzyć funkcję log , która będzie rejestrować każde żądanie. Zwróć uwagę, że możemy również wybrać, aby te funkcje oprogramowania pośredniego były uruchamiane po uruchomieniu naszego punktu końcowego, w zależności od tego, gdzie umieścisz je na stosie — coś, co zobaczymy później.

Aby określić niestandardowe oprogramowanie pośredniczące, musimy zdefiniować je jako funkcję i przekazać do app.use(...) .

const myMiddleware = (req, res, next) => { console.log(`Middleware has fired at time ${Date().now}`); next(); } app.use(myMiddleware); // This is the app variable returned from express().Wszyscy razem mamy teraz:

// Getting the module from node_modules. const express = require('express'); // Creating our Express Application. const app = express(); // Our middleware function. const myMiddleware = (req, res, next) => { console.log(`Middleware has fired at time ${Date().now}`); next(); } // Tell Express to use the middleware. app.use(myMiddleware); // Defining the port we'll bind to. const PORT = 3000; // Defining a new endpoint behind the "/my-test-route" route. app.get('/my-test-route', () => { console.log('A GET Request was made to /my-test-route.'); }); // Binding the server to port 3000. app.listen(PORT, () => { console.log(`Server is up on port ${PORT}.`) }); Jeśli ponownie wyślesz żądania za pośrednictwem przeglądarki, powinieneś teraz zobaczyć, że funkcja oprogramowania pośredniego uruchamia się i rejestruje sygnatury czasowe. Aby wesprzeć eksperymentowanie, spróbuj usunąć wywołanie next funkcji i zobacz, co się stanie.

Funkcja wywołania zwrotnego oprogramowania pośredniego jest wywoływana z trzema argumentami: req , res i next . req jest parametrem, który pominęliśmy podczas budowania GET Handler wcześniej, i jest to obiekt zawierający informacje dotyczące żądania, takie jak nagłówki, niestandardowe nagłówki, parametry i wszelkie treści, które mogły zostać wysłane przez klienta (takie jak robisz z żądaniem POST). Wiem, że mówimy tutaj o oprogramowaniu pośredniczącym, ale zarówno punkty końcowe, jak i funkcja oprogramowania pośredniczącego są wywoływane z req i res . req i res będą takie same (chyba że jedno lub drugie je zmutuje) zarówno w oprogramowaniu pośredniczącym, jak i punkcie końcowym w zakresie pojedynczego żądania od klienta. Oznacza to na przykład, że możesz użyć funkcji oprogramowania pośredniczącego do oczyszczenia danych przez usunięcie wszelkich znaków, które mogą mieć na celu wykonanie wstrzyknięć SQL lub NoSQL, a następnie przekazanie bezpiecznego req do punktu końcowego.

res , jak widzieliśmy wcześniej, umożliwia wysyłanie danych z powrotem do klienta na kilka różnych sposobów.

next to funkcja wywołania zwrotnego, którą musisz wykonać, gdy oprogramowanie pośredniczące zakończy wykonywanie swojej pracy, aby wywołać następną funkcję oprogramowania pośredniego na stosie lub w punkcie końcowym. Pamiętaj, aby pamiętać, że będziesz musiał wywołać to w bloku then wszystkich funkcji asynchronicznych, które uruchamiasz w oprogramowaniu pośredniczącym. W zależności od operacji asynchronicznej możesz lub nie chcesz wywoływać jej w bloku catch . Oznacza to, że funkcja myMiddleware jest uruchamiana po wysłaniu żądania od klienta, ale przed uruchomieniem funkcji punktu końcowego żądania. Gdy wykonamy ten kod i złożymy żądanie, powinien zostać wyświetlony komunikat Middleware has fired... przed komunikatem A GET Request was made to... w konsoli. Jeśli nie wywołasz next() , druga część nigdy nie zostanie uruchomiona — twoja funkcja punktu końcowego do żądania nie zostanie uruchomiona.

Zauważ też, że mogłem zdefiniować tę funkcję anonimowo, jako taką (konwencja, której będę się trzymać):

app.use((req, res, next) => { console.log(`Middleware has fired at time ${Date().now}`); next(); }); Dla każdego, kto jest nowicjuszem w JavaScript i ES6, jeśli sposób, w jaki powyższe działa, nie ma od razu sensu, poniższy przykład powinien pomóc. Po prostu definiujemy funkcję zwrotną (funkcja anonimowa), która jako argument przyjmuje inną funkcję zwrotną ( next ). Nazywamy funkcję, która przyjmuje argument funkcji, funkcją wyższego rzędu. Spójrz na to w następujący sposób — przedstawia podstawowy przykład tego, jak ekspresowy kod źródłowy może działać za kulisami:

console.log('Suppose a request has just been made from the client.\n'); // This is what (it's not exactly) the code behind app.use() might look like. const use = callback => { // Simple log statement to see where we are. console.log('Inside use() - the "use" function has been called.'); // This depicts the termination of the middleware. const next = () => console.log('Terminating Middleware!\n'); // Suppose req and res are defined above (Express provides them). const req = res = null; // "callback" is the "middleware" function that is passed into "use". // "next" is the above function that pretends to stop the middleware. callback(req, res, next); }; // This is analogous to the middleware function we defined earlier. // It gets passed in as "callback" in the "use" function above. const myMiddleware = (req, res, next) => { console.log('Inside the myMiddleware function!'); next(); } // Here, we are actually calling "use()" to see everything work. use(myMiddleware); console.log('Moving on to actually handle the HTTP Request or the next middleware function.'); Najpierw wywołujemy use , które przyjmuje myMiddleware jako argument. myMiddleware samo w sobie jest funkcją, która przyjmuje trzy argumenty - req , res i next . Wewnątrz use , wywoływane jest myMiddlware i te trzy argumenty są przekazywane. next jest funkcja zdefiniowana w use . myMiddleware jest zdefiniowane jako callback w metodzie use . Gdybym umieścił use , w tym przykładzie, na obiekcie o nazwie app , moglibyśmy całkowicie naśladować konfigurację Express, aczkolwiek bez żadnych gniazd ani łączności sieciowej.

W tym przypadku zarówno myMiddleware , jak i callback są funkcjami wyższego rzędu, ponieważ oba przyjmują funkcje jako argumenty.

Jeśli wykonasz ten kod, zobaczysz następującą odpowiedź:

Suppose a request has just been made from the client. Inside use() - the "use" function has been called. Inside the middleware function! Terminating Middleware! Moving on to actually handle the HTTP Request or the next middleware function.Zauważ, że mogłem również użyć funkcji anonimowych, aby osiągnąć ten sam wynik:

console.log('Suppose a request has just been made from the client.'); // This is what (it's not exactly) the code behind app.use() might look like. const use = callback => { // Simple log statement to see where we are. console.log('Inside use() - the "use" function has been called.'); // This depicts the termination of the middlewear. const next = () => console.log('Terminating Middlewear!'); // Suppose req and res are defined above (Express provides them). const req = res = null; // "callback" is the function which is passed into "use". // "next" is the above function that pretends to stop the middlewear. callback(req, res, () => { console.log('Terminating Middlewear!'); }); }; // Here, we are actually calling "use()" to see everything work. use((req, res, next) => { console.log('Inside the middlewear function!'); next(); }); console.log('Moving on to actually handle the HTTP Request.');Mając to, miejmy nadzieję, załatwione, możemy teraz wrócić do aktualnego zadania — konfiguracji naszego oprogramowania pośredniczącego.

Faktem jest, że zazwyczaj będziesz musiał przesłać dane za pomocą żądania HTTP. Możesz to zrobić na kilka różnych sposobów — wysyłanie parametrów zapytania URL, wysyłanie danych, które będą dostępne dla obiektu req , o którym dowiedzieliśmy się wcześniej itp. Ten obiekt jest dostępny nie tylko w wywołaniu zwrotnym do wywołania app.use() , ale także do dowolnego punktu końcowego. Wcześniej użyliśmy undefined jako wypełniacza, aby móc skupić się na res , aby wysłać HTML z powrotem do klienta, ale teraz potrzebujemy do niego dostępu.

app.use('/my-test-route', (req, res) => { // The req object contains client-defined data that is sent up. // The res object allows the server to send data back down. });Żądania HTTP POST mogą wymagać wysłania obiektu body na serwer. Jeśli masz formularz na kliencie i weźmiesz nazwę użytkownika i adres e-mail, prawdopodobnie wyślesz te dane na serwer w treści żądania.

Przyjrzyjmy się, jak to może wyglądać po stronie klienta:

<!DOCTYPE html> <html> <body> <form action="https://localhost:3000/email-list" method="POST" > <input type="text" name="nameInput"> <input type="email" name="emailInput"> <input type="submit"> </form> </body> </html>Po stronie serwera:

app.post('/email-list', (req, res) => { // What do we now? // How do we access the values for the user's name and email? }); Aby uzyskać dostęp do nazwy użytkownika i adresu e-mail, będziemy musieli użyć określonego typu oprogramowania pośredniczącego. Spowoduje to umieszczenie danych w obiekcie o nazwie body dostępnym na req . Body Parser był popularną metodą robienia tego, dostępną przez programistów Express jako samodzielny moduł NPM. Teraz Express jest dostarczany z własnym oprogramowaniem pośredniczącym, które to umożliwia, i nazwiemy to w ten sposób:

app.use(express.urlencoded({ extended: true }));Teraz możemy zrobić:

app.post('/email-list', (req, res) => { console.log('User Name: ', req.body.nameInput); console.log('User Email: ', req.body.emailInput); }); Wszystko, co robi, to pobieranie dowolnych danych wejściowych zdefiniowanych przez użytkownika, które są wysyłane od klienta, i udostępnianie ich w obiekcie body polecenia req . Zauważ, że w req.body mamy teraz nameInput i emailInput , które są nazwami tagów input w kodzie HTML. Teraz te dane zdefiniowane przez klienta powinny być uważane za niebezpieczne (nigdy, przenigdy nie ufaj klientowi) i muszą zostać oczyszczone, ale omówimy to później.

Innym typem oprogramowania pośredniczącego dostarczanego przez express jest express.json() . express.json służy do pakowania dowolnych ładunków JSON wysyłanych w żądaniu od klienta do req.body , podczas gdy express.urlencoded pakuje wszystkie przychodzące żądania z ciągami, tablicami lub innymi danymi zakodowanymi w adresie URL na req.body . Krótko mówiąc, oba manipulują req.body , ale .json() służy do obsługi ładunków JSON, a .urlencoded() służy między innymi do parametrów zapytania POST.

Innym sposobem powiedzenia tego jest to, że przychodzące żądania z nagłówkiem Content-Type: application/json (takie jak określenie treści POST za pomocą interfejsu API fetch ) będą obsługiwane przez express.json() , podczas gdy żądania z nagłówkiem Content-Type: application/x-www-form-urlencoded (na przykład formularze HTML) będzie obsługiwany przez express.urlencoded() . Mam nadzieję, że teraz ma to sens.

Uruchamianie naszych tras CRUD dla MongoDB

Uwaga : podczas wykonywania żądań PATCH w tym artykule nie będziemy postępować zgodnie ze specyfikacją JSONPatch RFC — problem, który naprawimy w następnym artykule z tej serii.

Biorąc pod uwagę, że rozumiemy, że określamy każdy punkt końcowy, wywołując odpowiednią funkcję w app , przekazując do niej trasę i funkcję wywołania zwrotnego zawierającą obiekty żądania i odpowiedzi, możemy rozpocząć definiowanie naszych tras CRUD dla interfejsu Bookshelf API. Rzeczywiście, i biorąc pod uwagę, że jest to artykuł wprowadzający, nie będę dbał o to, aby całkowicie przestrzegać specyfikacji HTTP i REST, ani nie będę próbował używać najczystszej możliwej architektury. To pojawi się w przyszłym artykule.

Otworzę plik server.js , którego używaliśmy do tej pory i opróżnię wszystko, aby zacząć od poniższej czystej karty:

// Getting the module from node_modules. const express = require('express'); // This creates our Express App. const app = express(); // Define middleware. app.use(express.json()); app.use(express.urlencoded({ extended: true )); // Listening on port 3000 (arbitrary). // Not a TCP or UDP well-known port. // Does not require superuser privileges. const PORT = 3000; // We will build our API here. // ... // Binding our application to port 3000. app.listen(PORT, () => console.log(`Server is up on port ${PORT}.`)); Rozważ cały poniższy kod, aby zająć część // ... powyższego pliku.

Aby zdefiniować nasze punkty końcowe i ponieważ budujemy REST API, powinniśmy omówić właściwy sposób nazywania tras. Ponownie, powinieneś zajrzeć do sekcji HTTP mojego poprzedniego artykułu, aby uzyskać więcej informacji. Mamy do czynienia z książkami, więc wszystkie trasy będą znajdować się za /books (standardowa jest konwencja nazewnictwa w liczbie mnogiej).

| Prośba | Trasa |

|---|---|

| POCZTA | /books |

| DOSTWAĆ | /books/id |

| SKRAWEK | /books/id |

| USUNĄĆ | /books/id |

Jak widać, identyfikatora nie trzeba podawać podczas POST-owania książki, ponieważ wygenerujemy ją (a raczej MongoDB), automatycznie, po stronie serwera. Pobieranie, łatanie i usuwanie książek będą wymagały przekazania tego identyfikatora do naszego punktu końcowego, co omówimy później. Na razie stwórzmy po prostu punkty końcowe:

// HTTP POST /books app.post('/books', (req, res) => { // ... console.log('A POST Request was made!'); }); // HTTP GET /books/:id app.get('/books/:id', (req, res) => { // ... console.log(`A GET Request was made! Getting book ${req.params.id}`); }); // HTTP PATCH /books/:id app.patch('/books/:id', (req, res) => { // ... console.log(`A PATCH Request was made! Updating book ${req.params.id}`); }); // HTTP DELETE /books/:id app.delete('/books/:id', (req, res) => { // ... console.log(`A DELETE Request was made! Deleting book ${req.params.id}`); }); Składnia :id mówi Expressowi, że id jest parametrem dynamicznym, który będzie przekazywany w adresie URL. Mamy do niego dostęp w obiekcie params dostępnym na req . Wiem, że „mamy do niego dostęp na req ” brzmi jak magia, a magia (która nie istnieje) jest niebezpieczna w programowaniu, ale trzeba pamiętać, że Express nie jest czarną skrzynką. Jest to projekt open-source dostępny na GitHub na licencji MIT. Możesz łatwo wyświetlić jego kod źródłowy, jeśli chcesz zobaczyć, jak dynamiczne parametry zapytania są umieszczane w obiekcie req .

W sumie mamy teraz w naszym pliku server.js :

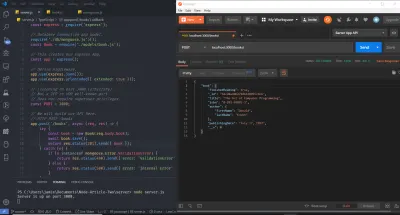

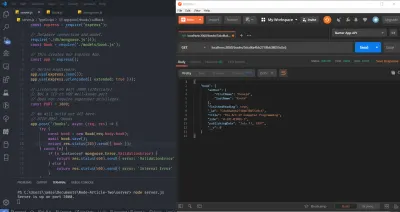

// Getting the module from node_modules. const express = require('express'); // This creates our Express App. const app = express(); // Define middleware. app.use(express.json()); app.use(express.urlencoded({ extended: true })); // Listening on port 3000 (arbitrary). // Not a TCP or UDP well-known port. // Does not require superuser privileges. const PORT = 3000; // We will build our API here. // HTTP POST /books app.post('/books', (req, res) => { // ... console.log('A POST Request was made!'); }); // HTTP GET /books/:id app.get('/books/:id', (req, res) => { // ... console.log(`A GET Request was made! Getting book ${req.params.id}`); }); // HTTP PATCH /books/:id app.patch('/books/:id', (req, res) => { // ... console.log(`A PATCH Request was made! Updating book ${req.params.id}`); }); // HTTP DELETE /books/:id app.delete('/books/:id', (req, res) => { // ... console.log(`A DELETE Request was made! Deleting book ${req.params.id}`); }); // Binding our application to port 3000. app.listen(PORT, () => console.log(`Server is up on port ${PORT}.`)); Śmiało i uruchom serwer, uruchamiając node server.js z terminala lub wiersza poleceń i odwiedź przeglądarkę. Otwórz konsolę programistyczną Chrome i na pasku adresu URL (Uniform Resource Locator) odwiedź localhost:3000/books . Powinieneś już zobaczyć wskaźnik w terminalu twojego systemu operacyjnego, że serwer działa, a także instrukcję log dla GET.

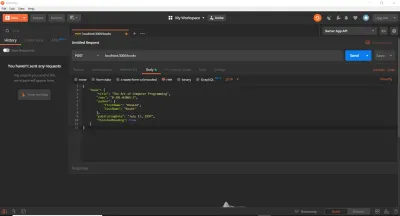

Do tej pory używaliśmy przeglądarki internetowej do wykonywania żądań GET. To jest dobre na początek, ale szybko przekonamy się, że istnieją lepsze narzędzia do testowania tras API. Rzeczywiście, możemy wkleić wywołania fetch bezpośrednio do konsoli lub skorzystać z jakiejś usługi online. W naszym przypadku, aby zaoszczędzić czas, użyjemy cURL i Postmana. Używam obu w tym artykule (chociaż możesz użyć jednego lub), abym mógł je przedstawić, jeśli ich nie używałeś. cURL to biblioteka (bardzo, bardzo ważna biblioteka) i narzędzie wiersza poleceń przeznaczone do przesyłania danych przy użyciu różnych protokołów. Postman to oparte na GUI narzędzie do testowania interfejsów API. Po wykonaniu odpowiednich instrukcji instalacji obu narzędzi w systemie operacyjnym upewnij się, że serwer nadal działa, a następnie wykonaj następujące polecenia (pojedynczo) w nowym terminalu. Ważne jest, aby je wpisać i wykonać pojedynczo, a następnie obejrzeć komunikat dziennika w terminalu oddzielnym od serwera. Należy również zauważyć, że symbol komentarza standardowego języka programowania // nie jest prawidłowym symbolem w Bash lub MS-DOS. Będziesz musiał pominąć te wiersze, a używam ich tutaj tylko do opisania każdego bloku poleceń cURL .

// HTTP POST Request (Localhost, IPv4, IPv6) curl -X POST https://localhost:3000/books curl -X POST https://127.0.0.1:3000/books curl -X POST https://[::1]:3000/books // HTTP GET Request (Localhost, IPv4, IPv6) curl -X GET https://localhost:3000/books/123abc curl -X GET https://127.0.0.1:3000/books/book-id-123 curl -X GET https://[::1]:3000/books/book-abc123 // HTTP PATCH Request (Localhost, IPv4, IPv6) curl -X PATCH https://localhost:3000/books/456 curl -X PATCH https://127.0.0.1:3000/books/218 curl -X PATCH https://[::1]:3000/books/some-id // HTTP DELETE Request (Localhost, IPv4, IPv6) curl -X DELETE https://localhost:3000/books/abc curl -X DELETE https://127.0.0.1:3000/books/314 curl -X DELETE https://[::1]:3000/books/217 Jak widać, identyfikator przekazywany jako parametr adresu URL może mieć dowolną wartość. Flaga -X określa typ żądania HTTP (można ją pominąć w przypadku GET), a my podajemy adres URL, na który następnie zostanie wykonane żądanie. Powielałem każde żądanie trzy razy, dzięki czemu możesz zobaczyć, że wszystko nadal działa, niezależnie od tego, czy używasz nazwy localhost , adresu IPv4 ( 127.0.0.1 ), na który rozwiązuje localhost lokalny, czy adresu IPv6 ( ::1 ), na który rozwiązuje localhost lokalny . Zauważ, że cURL wymaga umieszczania adresów IPv6 w nawiasach kwadratowych.

Jesteśmy teraz w przyzwoitym miejscu — mamy prostą strukturę naszych tras i punktów końcowych. Serwer działa poprawnie i akceptuje żądania HTTP tak, jak tego oczekujemy. W przeciwieństwie do tego, czego można się spodziewać, w tym momencie nie ma dużo czasu — musimy tylko skonfigurować naszą bazę danych, hostować ją (przy użyciu bazy danych jako usługi — Atlas MongoDB) i zachować w niej dane (i wykonać walidację i utworzyć odpowiedzi na błędy).

Konfigurowanie produkcyjnej bazy danych MongoDB

Aby skonfigurować produkcyjną bazę danych, przejdziemy do strony głównej MongoDB Atlas i założymy bezpłatne konto. Następnie utwórz nowy klaster. Możesz zachować ustawienia domyślne, wybierając poziom opłat odpowiedni dla regionu. Następnie naciśnij przycisk „Utwórz klaster”. Utworzenie klastra zajmie trochę czasu, po czym będziesz mógł uzyskać adres URL bazy danych i hasło. Zanotuj je, gdy je zobaczysz. Na razie zakodujemy je na sztywno, a później przechowujemy je w zmiennych środowiskowych ze względów bezpieczeństwa. Aby uzyskać pomoc w tworzeniu i łączeniu się z klastrem, odsyłam Cię do dokumentacji MongoDB, szczególnie tej strony i tej strony, lub możesz zostawić komentarz poniżej, a postaram się pomóc.

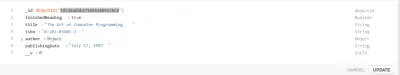

Tworzenie modelu mangusty

Zaleca się zrozumienie znaczenia dokumentów i zbiorów w kontekście NoSQL (nie tylko SQL — ustrukturyzowany język zapytań). Dla odniesienia możesz przeczytać zarówno Mongoose Quick Start Guide, jak i sekcję MongoDB w moim poprzednim artykule.

Mamy teraz bazę danych, która jest gotowa do przyjęcia operacji CRUD. Mongoose to moduł Node (lub ODM — Object Document Mapper), który pozwoli nam wykonać te operacje (abstrahując od niektórych złożoności), a także skonfigurować schemat lub strukturę kolekcji bazy danych.

Jako ważne zastrzeżenie, istnieje wiele kontrowersji wokół ORM-ów i takich wzorców, jak Active Record czy Data Mapper. Niektórzy programiści przysięgają na ORM-y, a inni przeklinają przeciwko nim (wierząc, że przeszkadzają). Ważne jest również, aby pamiętać, że ORM są bardzo abstrakcyjne, takie jak pulowanie połączeń, połączenia gniazd i obsługa itp. Można łatwo użyć sterownika natywnego MongoDB (kolejny moduł NPM), ale wymagałoby to dużo więcej pracy. Chociaż zaleca się, aby grać z Native Driver przed użyciem ORM, pomijam Native Driver dla zwięzłości. W przypadku złożonych operacji SQL na relacyjnej bazie danych nie wszystkie ORM zostaną zoptymalizowane pod kątem szybkości zapytań i możesz napisać swój własny surowy SQL. ORMs can come into play a lot with Domain-Driven Design and CQRS, among others. They are an established concept in the .NET world, and the Node.js community has not completely caught up yet — TypeORM is better, but it's not NHibernate or Entity Framework.

To create our Model, I'll create a new folder in the server directory entitled models , within which I'll create a single file with the name book.js . Thus far, our project's directory structure is as follows:

- server - node_modules - models - book.js - package.json - server.js Indeed, this directory structure is not required, but I use it here because it's simple. Allow me to note that this is not at all the kind of architecture you want to use for larger applications (and you might not even want to use JavaScript — TypeScript could be a better option), which I discuss in this article's closing. The next step will be to install mongoose , which is performed via, as you might expect, npm i mongoose .

The meaning of a Model is best ascertained from the Mongoose documentation:

Models are fancy constructors compiled from

Schemadefinitions. An instance of a model is called a document. Models are responsible for creating and reading documents from the underlying MongoDB database.

Before creating the Model, we'll define its Schema. A Schema will, among others, make certain expectations about the value of the properties provided. MongoDB is schemaless, and thus this functionality is provided by the Mongoose ODM. Let's start with a simple example. Suppose I want my database to store a user's name, email address, and password. Traditionally, as a plain old JavaScript Object (POJO), such a structure might look like this:

const userDocument = { name: 'Jamie Corkhill', email: '[email protected]', password: 'Bcrypt Hash' };If that above object was how we expected our user's object to look, then we would need to define a schema for it, like this: