Gaussian Naive Bayes: 알아야 할 사항

게시 됨: 2021-02-22목차

가우시안 나이브 베이즈

나이브 베이즈(Naive Bayes)는 많은 분류 기능에 사용되는 확률적 머신 러닝 알고리즘으로 베이즈 정리를 기반으로 합니다. Gaussian Naive Bayes는 Naive Bayes의 확장입니다. 다른 함수가 데이터 분포를 추정하는 데 사용되지만 가우스 또는 정규 분포는 훈련 데이터의 평균과 표준 편차를 계산해야 하므로 구현하기 가장 간단합니다.

나이브 베이즈 알고리즘이란?

Naive Bayes는 여러 분류 작업에 사용할 수 있는 확률적 기계 학습 알고리즘입니다. Naive Bayes의 일반적인 응용 프로그램은 문서 분류, 스팸 필터링, 예측 등입니다. 이 알고리즘은 Thomas Bayes의 발견과 그에 따른 이름을 기반으로 합니다.

알고리즘이 모델에 서로 독립적인 기능을 통합하기 때문에 "Naive"라는 이름이 사용됩니다. 한 특성 값의 수정은 알고리즘의 다른 특성 값에 직접적인 영향을 미치지 않습니다. Naive Bayes 알고리즘의 주요 장점은 간단하면서도 강력한 알고리즘이라는 것입니다.

알고리즘을 쉽게 코딩할 수 있고 실시간으로 빠르게 예측할 수 있는 확률 모델을 기반으로 합니다. 따라서 이 알고리즘은 사용자 요청에 즉시 응답하도록 조정할 수 있으므로 실제 문제를 해결하기 위한 일반적인 선택입니다. 그러나 Naive Bayes와 Gaussian Naive Bayes에 대해 자세히 알아보기 전에 조건부 확률이 무엇을 의미하는지 알아야 합니다.

조건부 확률 설명

예를 들어 조건부 확률을 더 잘 이해할 수 있습니다. 동전을 던질 때 앞서거나 뒤질 확률은 50%입니다. 마찬가지로 얼굴이 있는 주사위를 던질 때 4가 나올 확률은 1/6 또는 0.16입니다.

카드 팩을 가져갈 때 스페이드라는 조건에서 퀸을 얻을 확률은 얼마입니까? 스페이드여야 한다는 조건이 이미 설정되어 있으므로 분모 또는 선택 집합은 13이 됩니다. 스페이드에 퀸이 하나만 있으므로 스페이드의 퀸을 선택할 확률은 1/13=0.07이 됩니다.

사건 B가 주어진 경우 사건 A의 조건부 확률은 사건 B가 이미 발생했을 때 사건 A가 발생할 확률을 의미합니다. 수학적으로 주어진 B의 조건부 확률은 P[A|B] = P[A AND B] / P[B]로 나타낼 수 있습니다.

조금 복잡한 예를 살펴보겠습니다. 총 100명의 학생이 있는 학교를 예로 들어 보겠습니다. 이 인구는 학생, 교사, 남성 및 여성의 4가지 범주로 구분할 수 있습니다. 아래에 주어진 표를 고려하십시오.

| 여자 | 남성 | 총 | |

| 선생님 | 8 | 12 | 20 |

| 학생 | 32 | 48 | 80 |

| 총 | 40 | 50 | 100 |

여기서, 그 학교의 어떤 거주자가 남자라는 조건에서 교사가 될 조건부 확률은 얼마인가?

이를 계산하려면 60명의 남자 하위 모집단을 필터링하고 12명의 남자 교사로 드릴다운해야 합니다.

따라서 기대 조건부 확률 P[Teacher | 남성] = 12/60 = 0.2

P(교사 | 남) = P(교사 ∩ 남) / P(남) = 12/60 = 0.2

이것은 Teacher(A)와 Male(B)를 Male(B)로 나눈 것으로 나타낼 수 있습니다. 유사하게, A가 주어진 B의 조건부 확률도 계산할 수 있습니다. Naive Bayes에 사용하는 규칙은 다음 표기법으로 결론을 내릴 수 있습니다.

P(A | B) = P(A ∩ B) / P(B)

P(B | A) = P(A ∩ B) / P(A)

베이즈 법칙

Bayes 규칙에서는 훈련 데이터 세트에서 찾을 수 있는 P(X | Y)에서 P(Y | X)를 찾습니다. 이를 달성하려면 위의 공식에서 A와 B를 X와 Y로 바꾸기만 하면 됩니다. 관찰의 경우 X는 알려진 변수이고 Y는 알려지지 않은 변수입니다. 데이터 세트의 각 행에 대해 X가 이미 발생했다면 Y의 확률을 계산해야 합니다.

그러나 Y에 2개 이상의 범주가 있는 경우 어떻게 됩니까? 우승을 찾기 위해 각 Y 클래스의 확률을 계산해야 합니다.

Bayes 규칙을 통해 P(X | Y)에서 P(Y | X)를 찾습니다.

훈련 데이터에서 알려진 것: P(X | Y) = P(X ∩ Y) / P(Y)

P (증거 | 결과)

알 수 없음 – 테스트 데이터에 대해 예측됨: P(Y | X) = P(X ∩ Y) / P(X)

P(결과 | 증거)

베이즈 법칙 = P(Y | X) = P(X | Y) * P(Y) / P(X)

나이브 베이즈

Bayes 규칙은 조건 X가 주어졌을 때 Y의 확률에 대한 공식을 제공합니다. 그러나 실제 세계에서는 여러 X 변수가 있을 수 있습니다. 독립적인 특성이 있는 경우 Bayes 규칙을 Naive Bayes 규칙으로 확장할 수 있습니다. X는 서로 독립적입니다. 나이브 베이즈 공식은 베이즈 공식보다 더 강력합니다.

가우시안 나이브 베이즈

지금까지 X는 범주에 있지만 X가 연속 변수일 때 확률을 계산하는 방법은 무엇입니까? X가 특정 분포를 따른다고 가정하면 해당 분포의 확률 밀도 함수를 사용하여 우도 확률을 계산할 수 있습니다.

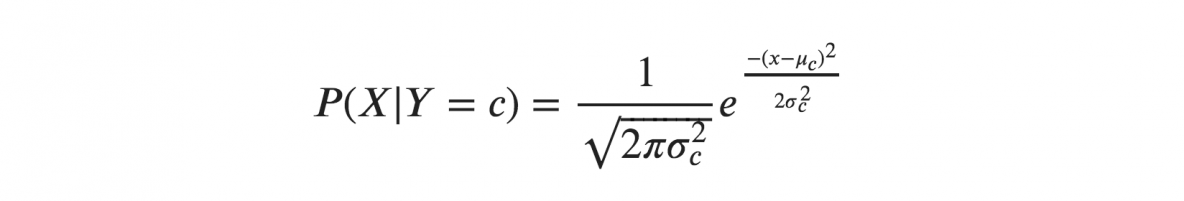

X가 가우스 또는 정규 분포를 따른다고 가정하면 정규 분포의 확률 밀도를 대체하고 이름을 가우스 나이브 베이즈로 지정해야 합니다. 이 공식을 계산하려면 X의 평균과 분산이 필요합니다.

위의 공식에서 sigma와 mu는 Y의 주어진 클래스 c에 대해 계산된 연속 변수 X의 분산과 평균입니다.

Gaussian Naive Bayes 표현

위의 공식은 빈도를 통해 각 클래스에 대한 입력 값의 확률을 계산했습니다. 전체 분포에 대한 각 클래스에 대한 x의 평균과 표준 편차를 계산할 수 있습니다.

이것은 각 클래스의 확률과 함께 클래스의 모든 입력 변수에 대한 평균과 표준 편차도 저장해야 함을 의미합니다.

평균(x) = 1/n * 합계(x)

여기서 n은 인스턴스 수를 나타내고 x는 데이터의 입력 변수 값입니다.

표준편차(x) = sqrt(1/n * sum(xi-mean(x)^2 ))

여기서 각 x의 차이 평균과 x의 평균의 제곱근이 계산됩니다. 여기서 n은 인스턴스 수, sum()은 합 함수, sqrt()는 제곱근 함수, xi는 특정 x 값입니다. .

Gaussian Naive Bayes 모델 을 사용한 예측

가우스 확률 밀도 함수는 매개변수를 변수의 새 입력 값으로 대체하여 예측을 수행하는 데 사용할 수 있으며 결과적으로 가우스 함수는 새 입력 값의 확률에 대한 추정치를 제공합니다.

나이브 베이즈 분류기

Naive Bayes 분류기는 한 특성의 값이 다른 특성의 값과 독립적이라고 가정합니다. 나이브 베이즈 분류기는 분류에 필요한 매개변수를 추정하기 위해 훈련 데이터가 필요합니다. 단순한 설계 및 적용으로 인해 Naive Bayes 분류기는 많은 실제 시나리오에 적합할 수 있습니다.

결론

Gaussian Naive Bayes 분류기는 너무 많은 노력과 높은 수준의 정확도 없이도 매우 잘 작동하는 빠르고 간단한 분류기 기술입니다.

AI, 기계 학습에 대해 자세히 알아보려면 IIIT-B & upGrad의 기계 학습 및 AI PG 디플로마를 확인하십시오. 기계 학습 및 AI는 일하는 전문가를 위해 설계되었으며 450시간 이상의 엄격한 교육, 30개 이상의 사례 연구 및 과제를 제공합니다. IIIT-B 동문 자격, 5개 이상의 실용적인 실습 캡스톤 프로젝트 및 최고의 기업과의 취업 지원.

세계 최고의 대학에서 ML 과정 을 배우십시오 . 석사, 이그 제 큐 티브 PGP 또는 고급 인증 프로그램을 획득하여 경력을 빠르게 추적하십시오.

나이브 베이즈 알고리즘이란?

Naive Bayes는 고전적인 기계 학습 알고리즘입니다. 통계에 기원을 둔 Naive Bayes는 간단하고 강력한 알고리즘입니다. Naive Bayes는 조건부 확률 분석을 적용한 분류기 제품군입니다. 이 분석에서 이벤트의 조건부 확률은 이벤트를 구성하는 개별 이벤트 각각의 확률을 사용하여 계산됩니다. Naive Bayes 분류기는 특히 기능 세트의 차원 수가 많을 때 실제로 매우 효과적인 것으로 밝혀졌습니다.

나이브 베이 알고리즘의 응용 프로그램은 무엇입니까?

Naive Bayes는 텍스트 분류, 문서 분류 및 문서 인덱싱에 사용됩니다. 나이브 베이에서 가능한 각 기능에는 사전 처리 단계에서 가중치가 할당되지 않으며 나중에 인식 단계뿐만 아니라 훈련 중에 가중치가 할당됩니다. 나이브 베이즈 알고리즘의 기본 가정은 기능이 독립적이라는 것입니다.

Gaussian Naive Bayes 알고리즘이란 무엇입니까?

Gaussian Naive Bayes는 강력한 독립 가정을 가진 Bayes의 정리를 적용한 확률적 분류 알고리즘입니다. 분류의 맥락에서 독립성은 한 특성 값의 존재가 다른 특성의 존재에 영향을 미치지 않는다는 아이디어를 나타냅니다(확률 이론의 독립성과 달리). Naive는 객체의 기능이 서로 독립적이라는 가정을 사용하는 것을 말합니다. 기계 학습의 맥락에서 나이브 베이즈 분류기는 표현력이 뛰어나고 확장 가능하며 합리적으로 정확하지만 훈련 세트의 성장에 따라 성능이 급격히 저하됩니다. 많은 기능이 나이브 베이즈 분류기의 성공에 기여합니다. 특히 분류 모델의 매개변수를 조정할 필요가 없고 훈련 데이터 세트의 크기에 따라 잘 확장되며 연속 기능을 쉽게 처리할 수 있습니다.