Privacy By Design : comment vendre la confidentialité et apporter des changements

Publié: 2022-03-10La vie privée est un droit humain fondamental qui nous permet d'être nous-mêmes. C'est ce qui nous permet d'être des cinglés sans honte. Cela nous permet d'avoir des opinions dissidentes sans conséquence. Et, finalement, c'est ce qui nous permet d'être libre. C'est pourquoi de nombreux pays ont des lois strictes concernant la vie privée. Cependant, malgré cette compréhension commune, la vie privée sur Internet est l'un des sujets les moins compris et mal définis à ce jour, car il couvre un large éventail de questions, prenant forme sous de nombreuses formes différentes, ce qui rend incroyablement difficile l'identification et la discussion. . Cependant, je voudrais essayer de résoudre cette ambiguïté.

Aux États-Unis, c'est une infraction fédérale d'ouvrir le courrier de quelqu'un. Ceci est considéré comme une violation criminelle de la vie privée qui pourrait entraîner une peine de prison pouvant aller jusqu'à cinq ans. Métaphoriquement parlant, chaque élément de données que nous créons sur Internet - qu'il s'agisse d'une photo, d'une vidéo, d'un texte ou d'autre chose - peut être considéré comme un colis de courrier. Cependant, contrairement à l'ouverture de notre courrier dans la vraie vie, les sociétés Internet peuvent légalement ouvrir chaque courrier qui est livré via leur système sans conséquence juridique. De plus, ils peuvent également en faire des copies. Ce que font ces entreprises serait comparable à quelqu'un qui ouvre notre courrier, le copie chez Kinkos, puis le stocke dans un classeur avec notre nom dessus et le partage avec quiconque est prêt à payer pour cela. Vous voulez ouvrir ce classeur ou supprimer certaines des copies ? Dommage. Notre courrier est actuellement considéré comme leur propriété et nous n'avons presque aucun contrôle sur la façon dont il est utilisé .

Pouvez-vous imaginer l'indignation que subirait le public s'il découvrait que le service postal retenait son courrier en otage et le vendait à quiconque était prêt à payer ? Ce qui se passe avec les données sur Internet n'est pas différent, et il est temps que cela change.

C'est plus qu'une simple question d'éthique que cela se produise, c'est une question de droits humains fondamentaux.

Le problème d'apporter les changements qui doivent être apportés (sans que les changements soient imposés par la réglementation) est de mettre des signes de dollar sur les problèmes. Quel est le retour financier sur un investissement de 20 000 heures en ingénierie pour améliorer les normes de confidentialité des consommateurs ? Les consommateurs exigent-ils ces changements ? Parce que s'il n'y a pas de retour fiscal et que les consommateurs ne l'exigent pas, alors pourquoi faudrait-il faire des changements ? Et même s'ils le sont et qu'il y a un retour, à quoi ressemblent 20 000 heures d'investissement ? Qu'est-ce qui va être mis sur la feuille de route du produit et quand ? Ce sont toutes des préoccupations valables qui doivent être abordées afin de nous aider à avancer efficacement. Alors, discutons.

Lecture recommandée : Utilisation de l'éthique dans la conception Web

Les consommateurs le veulent-ils ?

La réponse à cette question est un oui ferme. Les résultats du Pew Research Center montrent que 90 % des adultes aux États-Unis pensent qu'il est important qu'ils contrôlent les informations collectées à leur sujet, 93 % pensent qu'il est important qu'ils puissent contrôler qui a accès à ces informations et 86 % ont pris des mesures pour supprimer ou masquer leurs empreintes numériques. Des chiffres similaires ont été découverts sur les Européens dans le rapport Digital Attitudes 2018 de doteveryone. Malgré ces chiffres, 59 % ont toujours le sentiment qu'il est impossible de rester anonyme en ligne, 68 % pensent que les lois actuelles ne font pas assez pour protéger leur vie privée, et seulement 6 % sont « très confiants » que les agences gouvernementales peuvent assurer leur sécurité.

Maintenant, je sais ce que tu penses. C'est la demande des consommateurs, et jusqu'à ce que ces consommateurs commencent à abandonner les anciens produits, il n'y a aucune raison fiscale de faire des changements. Et (bien que je ne sois pas d'accord avec votre logique) vous avez raison. À l'heure actuelle, il y a peu de raisons financières d'apporter des changements. Cependant, lorsque la demande des consommateurs atteint une masse critique, les choses changent toujours. Et les entreprises qui ouvrent la voie avant que le changement ne soit exigé sont toujours gagnantes à long terme. Ceux qui refusent de faire un changement jusqu'à ce qu'ils soient forcés de toujours ressentir le plus de douleur . L'histoire montre que c'est la vérité. Mais que va-t-il se passer dans une législation qui va tellement changer les affaires ? Excellente question.

Ce qui est sur le point d'arriver aux normes de protection des données et de confidentialité à travers le monde, par le biais de la réglementation, ne sera pas si différent de ce qui s'est passé il y a moins de dix ans, lorsque les consommateurs ont exigé une protection contre les spams, ce qui a abouti à la loi CAN-SPAM aux États-Unis. – mais à une échelle beaucoup plus grande et avec un impact exponentiellement plus grand. Cette législation, qui a été créée parce que les consommateurs en avaient assez de recevoir des spams, a établi les règles pour les e-mails commerciaux, établi des exigences pour les messages commerciaux, donné aux destinataires le droit de demander aux particuliers et aux entreprises de cesser de leur envoyer des e-mails et a énoncé des sanctions sévères en cas de violation. Alors que nous entrons dans une période où les consommateurs commencent à comprendre à quel point ils ont été trompés (pendant des années, donner aux gens le contrôle intime de leurs données sera sans aucun doute l'avenir de la collecte de données) - que ce soit par le libre arbitre ou par la législation. Et ceux qui choisissent de bouger en premier gagneront. Vous ne me croyez pas ?

Considérez le fait que les ingénieurs peuvent avoir des ennuis juridiques pour le code qu'ils écrivent. Les données d'Apple Watch, d'Alexa et de FitBit, entre autres, ont été utilisées comme preuves devant les tribunaux, modifiant la perception des consommateurs à l'égard de leurs données. Microsoft et la Cour suprême des États-Unis se sont rendus devant les tribunaux plus tôt cette année pour définir où s'étendent les frontières physiques dans les activités criminelles basées sur le cloud, le début de ce qui sera un long combat. Ces exemples ne sont qu'un aperçu de ce qui s'en vient. Les gens demandent plus et nous atteignons le point de basculement.

La première à prendre des mesures pour répondre à cette demande est l'UE, qui a établi le RGPD, et maintenant les décideurs politiques d'autres pays commencent à emboîter le pas, travaillant sur les lois de leur pays pour définir notre avenir cybernétique. Par exemple, le vice-président de la commission du renseignement du Sénat des États-Unis, Mark Warner, a récemment exposé certaines idées dans un rapport de synthèse il y a quelques mois à peine, démontrant où la législation pourrait bientôt se diriger aux États-Unis. Mais ce ne sont pas seulement les progressistes qui croient que c'est l'avenir ; même des influenceurs de droite comme Steve Bannon pensent que nous avons besoin de réglementation.

Ce que nous voyons est une réaction humaine à une manipulation incroyable. Peu importe à quel point nous sommes domestiqués par rapport aux générations précédentes, les gens repousseront toujours quand ils se sentiront menacés. C'est une réaction naturelle qui nous a permis de survivre pendant des millénaires. Aujourd'hui, la technologie est devenue plus qu'une simple industrie tournée vers les consommateurs. Cela devient maintenant aussi une question de sécurité nationale . Et pour cette raison, il y aura une réaction que cela nous plaise ou non. Et ce sera mieux si nous élaborons une stratégie pour nous préparer au lieu de nous faire balayer sous le tapis. Alors, quel est le rendement financier que vous demandez ? Eh bien, combien vaut votre entreprise ? C'est combien.

Lecture recommandée : comment le RGPD changera votre façon de développer

Pour un cadre simple de ce qui doit être traité exactement et pourquoi, nous pouvons considérer que plusieurs vérités sont fondamentales dans la création de systèmes numériques :

- La confidentialité doit être proactive, et non réactive, et doit anticiper les problèmes de confidentialité avant qu'ils n'atteignent l'utilisateur.

Ces problèmes ne sont pas des problèmes que nous voulons traiter une fois qu'un problème est apparu, mais plutôt des problèmes que nous voulons entièrement prévenir, si possible. - La confidentialité doit être le paramètre par défaut.

Il n'y a pas d'option « meilleure pour les entreprises » en matière de confidentialité ; c'est une question qui concerne ce qui est le mieux pour le consommateur, ce qui, à long terme, sera meilleur pour l'entreprise. Nous pouvons voir ce qui se passe lorsque des failles coercitives sont exposées au public à travers ce qui est arrivé à Paypal et Venmo en août 2018 lorsque Public by Default a été rendu public, apportant une poignée de mauvaise presse à la marque. Les entreprises qui attendent que quelque chose de grave se produise avant de procéder à un changement en seront certainement davantage atteintes. - La vie privée doit être une somme positive et doit éviter les dichotomies.

Il n'y a pas de relation binaire à avoir avec la vie privée ; c'est une question toujours malléable qui nécessite une surveillance constante et une itération perpétuelle. Notre travail ne s'arrête pas aux termes et à l'accord de service, il dure pour toujours et doit être considéré comme un élément fondamental de votre produit qui évolue avec le produit et permet aux consommateurs de se protéger - et non un élément qui profite de leur manque de compréhension. - Les normes de confidentialité doivent être visibles, transparentes, ouvertes, documentées et vérifiables de manière indépendante.

Il n'y a pas de grande façon de définir un test décisif pour vos normes de confidentialité, mais quelques questions que nous devrions tous nous poser en tant qu'hommes d'affaires sont : Premièrement, si la presse publiait votre accord de confidentialité, serait-il compréhensible ? Deuxièmement, si c'était compréhensible, les consommateurs apprécieraient-ils ce qu'ils lisent ? Et enfin, si ce n'est pas le cas, que devez-vous changer ?

Ces principes seront des bases très précieuses à garder à l'esprit au fur et à mesure que les produits sont construits et évoluent. Ils représentent des questions rapides et faciles à poser à vous-même et à votre équipe qui vous permettront d'avoir une bonne base d'éthique, mais pour un article plus long sur les fondements juridiques, vous pouvez en lire plus de Heather Burns, qui a décrit plusieurs principes supplémentaires l'année dernière sur Smashing. Et pour une liste complète des éléments à inspecter lors d'une évaluation de l'impact sur la vie privée (PIA), vous pouvez également consulter la façon dont les évaluations sont effectuées selon :

- Bureau du commissaire à l'information du Royaume-Uni (ICO)

- Le Commissariat à la protection de la vie privée du Canada

- Le Département de la sécurité intérieure des États-Unis

Mais avant de vous précipiter pour apporter des modifications à votre produit, soulignons d'abord certains des défauts actuels dans la nature et parlons de ce à quoi pourraient ressembler les changements une fois qu'ils sont correctement mis en œuvre.

Comment faire du changement

L'un des plus gros problèmes avec les pratiques de confidentialité aux États-Unis est la difficulté de comprendre les conditions et les accords de service (T&S), qui jouent un rôle majeur dans la définition de la confidentialité, mais ont tendance à le faire très mal. Actuellement, les utilisateurs sont obligés de lire de longs documents pleins de langage juridique et de jargon technique s'ils espèrent comprendre ce qu'ils acceptent. Une étude a en fait démontré qu'il faudrait environ 201 heures (près de dix jours) par an à une personne moyenne pour lire chaque politique de confidentialité qu'elle rencontre chaque année . Les chercheurs ont estimé que la valeur de ce temps perdu s'élèverait à près de 781 milliards de dollars par an, ce qui est plus qu'inacceptable étant donné que ce sont les règles censées protéger les consommateurs - des règles qui sont présentées comme faciles et digestes. Cela place les consommateurs dans une position où ils sont obligés de s'inscrire sans vraiment comprendre dans quoi ils s'embarquent. Et dans de nombreux cas, ce n'est même pas le langage juridique qui est coercitif, c'est la façon dont les options sont données, en général, comme le prouvent clairement diverses expériences :

L'exemple donné ci-dessus est un wireframe générique, mais j'ai choisi de le faire parce que nous avons tous vu des modèles comme celui-ci et d'autres similaires qui sont liés à la collecte de types de données plus spécifiques. Je pourrais énumérer des exemples spécifiques, mais la liste s'allongerait indéfiniment et il n'y a aucune raison d'énumérer des entreprises spécifiques démontrant des modèles de manipulation, car ces modèles (et d'autres modèles très similaires) peuvent être trouvés sur presque tous les sites Web ou applications sur Internet. Il y a un problème majeur à demander le consentement de cette façon : les consommateurs ne sont pas autorisés à ne pas accepter les conditions et les services sans plusieurs étapes supplémentaires, beaucoup de lecture et souvent bien plus. Il s'agit d'un défaut fondamental qui doit être corrigé , car demander le consentement signifie qu'il doit y avoir une option pour dire non, et pour savoir si « non » est la meilleure option, les consommateurs doivent comprendre à quoi ils consentent. Cependant, les produits ne sont pas construits de cette façon. Pourquoi? C'est mieux pour les affaires.

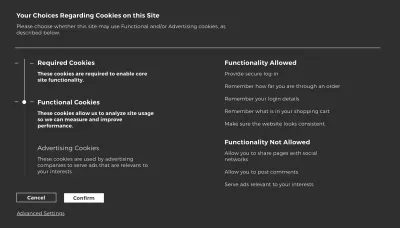

Si nous nous asseyons vraiment et réfléchissons à cela, ce qui est facile à voir mais qui n'est pas reconnu, c'est que les entreprises passent plus de temps à créer des pages de garde pour expliquer comment utiliser l'application que nous ne le faisons pour expliquer quelles données sont collectées et pourquoi. Pourquoi? De simples changements dans la façon dont les accords T&S sont conclus rendraient non seulement les consommateurs plus conscients de ce qu'ils souscrivent, mais leur permettraient également d'être des consommateurs plus responsables . Nous pouvons voir que certains de ces changements sont déjà en cours en raison de l'impact que le RGPD a eu à travers le monde. Dans de nombreux pays européens, il n'est pas rare que le consentement soit demandé via des modes comme ceux-ci :

Ce premier exemple est un bon pas en avant. Il indique au consommateur à quoi ses données seront utilisées, mais il manque toujours de transparence quant à la destination des données et donne la priorité à l'accord sans possibilité de refuser. Il bloque également tout dans un seul corps de texte, ce qui rend l'information beaucoup moins digeste.

Un meilleur exemple de la façon dont cela pourrait être conçu est quelque chose comme le modal ci-dessous, qui est maintenant commun à de nombreux sites européens :

Cela donne aux consommateurs une compréhension globale de ce à quoi leurs données seront utilisées et le fait de manière digeste. Cependant, il manque toujours des informations importantes sur la destination des données après leur consentement. Il n'y a pas un seul indice quant à l'endroit où leurs données seront partagées, avec qui elles seront partagées et quelles limites existent dans ces accords. Bien que ce soit bien meilleur que la majorité des options sur le Web, il reste encore des améliorations à apporter.

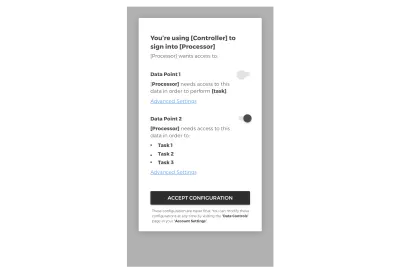

Invite de connexion tierce

Par exemple, lors de l'utilisation d'un service tiers pour se connecter à votre plateforme, les consommateurs doivent être bien informés de ce qui suit :

- Quelles données seront extraites du tiers ;

- À quoi sert-il et comment cela pourrait-il affecter leur expérience si vous n'y avez pas accès ;

- Qui d'autre a ou pourrait y avoir accès.

Pour mettre cela en œuvre d'une manière qui donne le contrôle au consommateur, cette expérience devrait également permettre aux consommateurs de s'inscrire à des parties individuelles de la collection, sans être obligés d'accepter tout ou rien du tout.

Cela rendrait les T&S digestes et permettrait aux consommateurs d'accepter ce qu'ils acceptent vraiment, et non ce que l'entreprise veut qu'ils acceptent. Et pour vous assurer que c'est vraiment opt-in, la valeur par défaut doit être définie sur opt-out. Ce serait un petit changement qui ferait une différence radicale dans la façon dont le consentement est demandé. Aujourd'hui, la plupart des entreprises recouvrent ce contenu de jargon juridique pour cacher ce qui les intéresse vraiment, mais l'époque où l'on demandait le consentement de cette manière touche rapidement à sa fin.

Si vous fournissez aux consommateurs un service significatif et que vous le faites de manière éthique, ces changements ne devraient pas être un problème. S'il y a une vraie valeur au service, les consommateurs ne résisteront pas à votre demande. Ils veulent juste savoir à qui ils peuvent et ne peuvent pas faire confiance, et c'est une étape simple qui peut aider votre entreprise à prouver sa fiabilité.

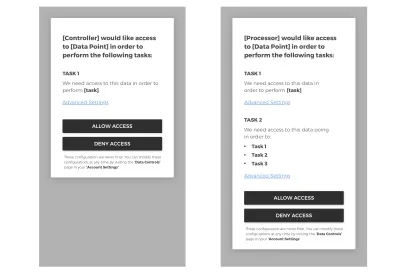

Demandes de collecte de données à un ou plusieurs points

Ensuite, lorsqu'il s'agit de créer des accords T&S compréhensibles pour votre plate-forme, nous devons considérer comment cela pourrait se dérouler de manière plus contextuelle - dans l'expérience de l'application. Gardez à l'esprit que si tout est donné à l'avance, ce n'est pas digeste. Pour cette raison, la demande de collecte de données doit se produire de manière contextuelle , lorsque le consommateur est sur le point d'utiliser une partie de votre service qui nécessite la collecte d'une couche supplémentaire de données.

Pour montrer comment cette demande peut se produire, voici quelques exemples de ce à quoi pourrait ressembler une demande de collecte de données à un ou plusieurs points :

Décomposer le T&S en points d'interaction digestibles au sein de l'expérience au lieu de tout demander à l'utilisateur à l'avance lui permet de mieux comprendre ce qui se passe et pourquoi. Si vous n'avez pas besoin des données pour améliorer l'expérience, pourquoi sont-elles collectées ? Et s'il est collecté pour des raisons frivoles qui ne profitent qu'à l'entreprise, alors soyez honnête. C'est juste une honnêteté de base, qui est malheureusement considérée comme un service client révolutionnaire et progressif dans le monde moderne.

La plus grande clé de ces demandes initiales est que rien de tout cela ne devrait être opt-in par défaut . Tous les déclencheurs initiaux doivent permettre aux personnes utilisant l'outil de s'inscrire si elles le souhaitent et de l'utiliser sans s'inscrire si elles le souhaitent. L'époque de l'opt-in forcé (ou, pire encore, de l'opt-in coercitif) touche à sa fin brutale, et ceux qui ouvrent la voie resteront en tête du peloton pendant longtemps.

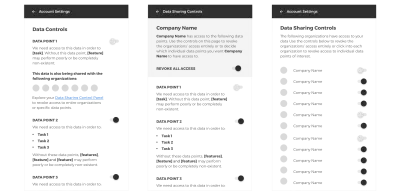

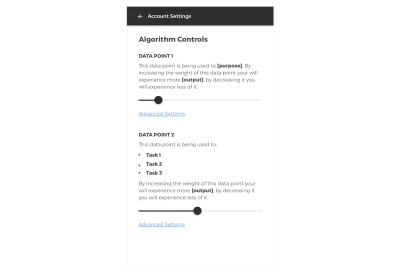

Centre de contrôle des données

Au-delà de demander le consentement de manière significative, il sera également important que nous donnions aux consommateurs la possibilité de contrôler leurs données a posteriori. L'accès des consommateurs au contrôle de leurs données ne doit pas s'arrêter aux termes et à l'accord de service. Quelque part dans leurs contrôles de compte, il devrait également y avoir un endroit (ou des endroits) où les consommateurs peuvent contrôler leurs données sur la plate-forme après avoir investi du temps avec le service. Cette zone doit leur montrer quelles données sont collectées, avec qui elles sont partagées, comment ils peuvent les supprimer, et bien plus encore.

L'idée d'un contrôle total des données peut sembler incroyablement libérale, mais c'est sans aucun doute l'avenir. Et en tant que propriété du consommateur qui crée les données, elles doivent être considérées comme un droit humain fondamental. Il n'y a aucune raison pour que cela fasse l'objet d'un débat à ce stade de l'histoire. Les données représentent l'histoire de nos vies - collectivement - et combinées, elles créent de grandes quantités de pouvoir contre ceux qui les créent, surtout si nous permettons aux systèmes de rester des boîtes noires. Ainsi, au-delà de donner aux consommateurs l'accès à leurs données, comme nous l'avons évoqué dans les sections précédentes, nous devrons également rendre l'expérience plus compréhensible afin que les consommateurs puissent se défendre.

Créer une IA explicable

Bien qu'il soit incroyable d'obtenir un résultat suggéré qui nous montre les choses que nous voulons avant même que nous sachions que nous les voulions, cela place également les machines dans une position puissante qu'elles ne sont pas encore prêtes à défendre seules. Lorsque les machines sont positionnées comme des experts et fonctionnent à un niveau suffisamment intelligent pour passer pour tel, le public leur fera généralement confiance jusqu'à ce qu'elles échouent. Cependant, si les machines échouent d'une manière que le public est incapable de comprendre, elles resteront expertes malgré leur échec, qui est l'une des plus grandes menaces pour l'humanité.

Par exemple, si quelqu'un devait utiliser un outil de recherche visuelle pour identifier la différence entre un champignon comestible et un champignon vénéneux, et qu'il ne savait pas que la machine lui avait dit qu'un champignon vénéneux était sans danger, cette personne pourrait mourir. Ou que se passe-t-il lorsqu'une machine détermine l'issue d'un procès et n'est pas tenue de fournir une explication pour sa décision ? Ou pire encore, qu'en est-il lorsque ces technologies sont utilisées à des fins militaires et qu'on leur donne le droit d'utiliser la force létale ? Cette dernière situation peut sembler extrême, mais c'est une question qui fait actuellement l'objet de débats au sein des Nations Unies.

Pour s'assurer que le public est capable de comprendre ce qui se passe dans les coulisses, nous devons créer ce que la DARPA appelle l'intelligence artificielle explicable (XAI) - des outils qui expliquent comment les machines prennent leurs décisions et la précision avec laquelle ces tâches ont été accomplies. Il ne s'agit pas de divulguer des secrets commerciaux, mais de donner aux consommateurs le sentiment qu'ils peuvent faire confiance à ces machines et se défendre en cas d'erreur.

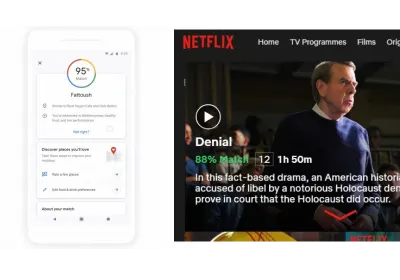

Bien qu'il ne soit pas basé sur l'intelligence artificielle, un bon exemple de ce à quoi cela pourrait ressembler est CreditKarma, qui permet aux gens d'avoir une meilleure compréhension de leur pointage de crédit - un système qui était auparavant caché, tout comme les algorithmes le sont aujourd'hui. Cet outil permet aux consommateurs de mieux comprendre ce qui se passe dans les coulisses et de débattre de la légitimité de leurs résultats s'ils pensent que le système a échoué. Des outils similaires sont en cours de création avec des systèmes tels que le score de correspondance de Google sur les cartes et le pourcentage de correspondance de Netflix sur les émissions, mais ces systèmes commencent tout juste à effleurer la surface de l'IA explicable.

Malgré ces efforts, la plupart des algorithmes dictent aujourd'hui notre expérience en fonction de ce qu'une entreprise pense que nous voulons. Mais les consommateurs ne devraient plus être contrôlés de manière invisible par de grandes sociétés cotées en bourse. Les consommateurs devraient avoir le droit de contrôler leur propre algorithme . Cela pourrait être quelque chose d'aussi simple que de leur faire savoir quelles variables sont utilisées pour quelles parties de l'expérience et comment la modification des poids de chaque variable affectera leur expérience, puis de leur donner la possibilité de modifier cela jusqu'à ce qu'il réponde à leurs besoins - y compris en tournant le algorithme complètement, si c'est ce qu'ils préfèrent. Qu'il s'agisse d'une fonctionnalité payante ou d'une fonctionnalité gratuite fait toujours l'objet d'un débat, mais ce qui n'est pas discutable, c'est si cette liberté doit être offerte.

Bien que l'exemple ci-dessus soit une proposition générique, il commence à imaginer comment nous pourrions faire l'expérience dans des situations plus spécifiques. En donnant aux consommateurs la possibilité de comprendre leurs données, la façon dont elles sont utilisées et comment cela affecte leur vie, nous aurons conçu un système qui place les consommateurs en contrôle de leur propre liberté.

Cependant, quelle que soit la qualité de ces changements, nous devons également réaliser que le fait de donner aux gens un meilleur contrôle de leur vie privée n'implique pas automatiquement un environnement plus sûr pour les consommateurs. En fait, cela peut aggraver les choses. Des études ont montré que le fait de donner aux utilisateurs un meilleur contrôle sur leurs données augmente la probabilité qu'ils fournissent des informations plus sensibles . Et si le consommateur ignore comment ces données peuvent être utilisées (même s'il sait où elles sont partagées), cela le met en danger. En ce sens, donner aux consommateurs un meilleur contrôle de leurs données et s'attendre à ce qu'Internet soit plus sûr, c'est comme mettre une étiquette nutritionnelle sur un Snickers et s'attendre à ce qu'il rende la barre chocolatée moins grasse. Ce ne sera pas le cas, et les gens continueront à en manger.

Même si je crois que les consommateurs ont un droit fondamental à de meilleurs contrôles de confidentialité et à une plus grande transparence, je crois aussi qu'il est de notre devoir, en tant que technologues connaissant les données, non seulement de construire de meilleurs systèmes, mais aussi d'aider le public à comprendre la sécurité sur Internet. Ainsi, la dernière étape pour rassembler tout cela consiste à faire prendre conscience du fait que le contrôle n'est pas tout ce dont les consommateurs ont besoin. Ils doivent également comprendre ce qui se passe sur le backend et pourquoi. Cela ne signifie pas nécessairement leur fournir le code source ou donner leurs adresses IP, mais au moins leur fournir suffisamment d'informations pour comprendre ce qui se passe au niveau de base, par mesure de sécurité. Et pour y parvenir, nous devrons aller au-delà de nos écrans. Nous devrons étendre notre travail dans nos communautés et aider à créer cet avenir.

Lecture recommandée : Concevoir l'éthique : changer la compréhension éthique dans le design

Encourager le changement

Abandonner la vie privée est une chose dans laquelle la population a été enfermée en raison des monopoles qui existent dans le monde de la technologie, de l'incompréhension des consommateurs quant aux raisons pour lesquelles cela est si dangereux à l'intérieur et du manque de solutions tactiques associées aux rendements fiscaux. Cependant, c'est un problème qui doit être résolu. Comme Barack Obama l'a noté dans le résumé de son administration des préoccupations concernant la confidentialité sur Internet :

« Une chose doit être claire : même si nous vivons dans un monde où nous partageons des informations personnelles plus librement que par le passé, nous devons rejeter la conclusion selon laquelle la vie privée est une valeur dépassée. Elle est au cœur de notre démocratie depuis sa création, et nous en avons plus que jamais besoin. »

Créer des expériences de partage de données fiables et sécurisées sera l'un des plus grands défis auxquels notre monde sera confronté dans les décennies à venir.

Nous pouvons voir comment les actions de Facebook ont chuté de 19% en une journée après avoir annoncé qu'elles allaient se recentrer sur les efforts de confidentialité, comme preuve de la difficulté d'apporter ces changements. En effet, les investisseurs qui se sont récemment concentrés sur la croissance des revenus à court terme savent à quel point les entreprises doivent mettre en œuvre de meilleures stratégies, mais réalisent également le coût impliqué si le public commence à remettre en question une entreprise – et la déclaration publique de Facebook admettant cela a surpris le mouton .

Bien que le processus ne soit pas facile (et parfois douloureux), nous savons tous que la vie privée est le ventre mou de la technologie et qu'il est temps de changer cela. Les décisions prises aujourd'hui rapporteront gros à long terme; une nette différence avec l'état d'esprit à court terme et trimestriel qui a fini par dominer les affaires au cours de la dernière décennie de croissance. Ainsi, découvrir des moyens créatifs de faire de ces questions une priorité pour toutes les parties prenantes devrait être considéré comme essentiel pour les entreprises et les décideurs politiques, ce qui signifie que notre travail en tant que technologues doit s'étendre au-delà de la salle de conférence.

Par exemple, un excellent moyen d'inciter à ces changements au-delà de la discussion des chiffres et des problèmes soulevés dans cet article serait d'accorder des allégements fiscaux aux entreprises qui allouent une grande partie de leur budget à l'amélioration de leurs systèmes. Des pauses pourraient être accordées aux entreprises qui décident de fournir régulièrement des formations ou des ateliers à leur personnel pour aider à faire de la confidentialité et de la sécurité une priorité dans la culture d'entreprise. Ils pourraient être donnés aux entreprises qui embauchent des pirates informatiques professionnels pour trouver des failles dans leurs systèmes avant que les attaques ne se produisent. Ils pourraient être accordés à ceux qui consacrent un grand nombre d'heures à la restructuration de leurs pratiques commerciales d'une manière qui profite aux consommateurs. En ce sens, de telles incitations ne seraient pas si différentes des allégements fiscaux accordés aux entreprises qui mettent en œuvre des pratiques respectueuses de l'environnement.

L'idée d'allégements fiscaux peut sembler scandaleuse pour certains, mais des incitations comme celles-ci représenteraient une solution plus proactive que la façon dont les choses sont gérées actuellement. Bien qu'il puisse être agréable de lire un titre indiquant "Google a infligé une amende record de 5 milliards de dollars par l'UE pour des violations antitrust d'Android", nous devons garder à l'esprit que des amendes comme celle-ci ne représentent qu'une petite fraction des revenus de ces entreprises. Combinez cela avec le fait que la plupart des cas mettent plusieurs années ou décennies à se conclure, et ce pourcentage ne fait que diminuer. Avec cela à l'esprit, l'idée d'allégements fiscaux peut être abordée d'un point de vue différent, à savoir qu'il ne s'agit pas de récompenser un comportement auparavant négligent, mais d' accroître la sécurité publique d'une manière qui est dans le meilleur intérêt de toutes les personnes concernées . Maintenir notre système actuel, qui permet aux entreprises d'enchaîner les poursuites judiciaires tout en poursuivant leurs irrégularités, est tout aussi dangereux, sinon plus, que de ne pas avoir de lois du tout.

Si vous avez apprécié la lecture de cet article et pensez que d'autres devraient le lire également, veuillez aider à faire passer le mot.

Cet article est le début d'une série d'articles sur lesquels je vais écrire consacrés à la sécurité sur Internet, dans lesquels je travaillerai pour mettre des chiffres fiscaux sur des modèles de conception éthiques afin que nous, en tant que technologues, puissions changer les entreprises que nous construisons et créer un une meilleure culture entourant le développement d'expériences connectées à Internet.