Erste Schritte mit einem Express- und ES6+-JavaScript-Stack

Veröffentlicht: 2022-03-10Dieser Artikel ist der zweite Teil einer Reihe, wobei Teil eins hier zu finden ist und grundlegende und (hoffentlich) intuitive Einblicke in Node.js, ES6+ JavaScript, Callback-Funktionen, Pfeilfunktionen, APIs, das HTTP-Protokoll, JSON, MongoDB und mehr bietet mehr.

In diesem Artikel bauen wir auf den Fähigkeiten auf, die wir im vorherigen Artikel erworben haben, und lernen, wie man eine MongoDB-Datenbank zum Speichern von Benutzerbuchlisteninformationen implementiert und bereitstellt, eine API mit Node.js und dem Express-Webanwendungsframework erstellt, um diese Datenbank verfügbar zu machen und CRUD-Operationen darauf ausführen und mehr. Unterwegs werden wir die ES6-Objektdestrukturierung, die ES6-Objekt-Kurzschrift, die Async/Await-Syntax, den Spread-Operator besprechen und einen kurzen Blick auf CORS, die Same-Origin-Richtlinie und mehr werfen.

In einem späteren Artikel werden wir unsere Codebasis umgestalten, um Bedenken zu trennen, indem wir eine dreischichtige Architektur verwenden und eine Umkehrung der Kontrolle über Dependency Injection erreichen Passwörter speichern und AWS Simple Storage Service verwenden, um Benutzer-Avatare mit Node.js-Puffern und -Streams zu speichern – während PostgreSQL für die Datenpersistenz verwendet wird. Unterwegs werden wir unsere Codebasis von Grund auf in TypeScript neu schreiben, um klassische OOP-Konzepte (wie Polymorphismus, Vererbung, Komposition usw.) und sogar Entwurfsmuster wie Fabriken und Adapter zu untersuchen.

Ein Wort der Warnung

Es gibt ein Problem mit den meisten Artikeln, in denen es heute um Node.js geht. Die meisten von ihnen, nicht alle, gehen nicht weiter als zu zeigen, wie man Express Routing einrichtet, Mongoose integriert und vielleicht JSON Web Token Authentication verwendet. Das Problem ist, dass sie nicht über Architektur oder Best Practices für Sicherheit oder über saubere Codierungsprinzipien oder ACID-Compliance, relationale Datenbanken, fünfte Normalform, das CAP-Theorem oder Transaktionen sprechen. Es wird entweder davon ausgegangen, dass Sie über all das Bescheid wissen, oder dass Sie keine Projekte bauen, die groß oder populär genug sind, um das oben genannte Wissen zu rechtfertigen.

Es scheint ein paar verschiedene Arten von Node-Entwicklern zu geben – unter anderem sind einige neu in der Programmierung im Allgemeinen, und andere kommen aus einer langen Geschichte der Unternehmensentwicklung mit C# und dem .NET Framework oder dem Java Spring Framework. Die Mehrzahl der Artikel richtet sich an die erstgenannte Gruppe.

In diesem Artikel werde ich genau das tun, was ich gerade gesagt habe, was zu viele Artikel tun, aber in einem Folgeartikel werden wir unsere Codebasis vollständig umgestalten, sodass ich Prinzipien wie Dependency Injection, Three- Layer-Architektur (Controller/Service/Repository), Data Mapping und Active Record, Entwurfsmuster, Unit-, Integrations- und Mutationstests, SOLID-Prinzipien, Unit of Work, Codierung gegen Schnittstellen, Best Practices für Sicherheit wie HSTS, CSRF, NoSQL und SQL-Injection Prävention und so weiter. Wir werden auch von MongoDB zu PostgreSQL migrieren, indem wir den einfachen Abfrageersteller Knex anstelle eines ORM verwenden – was es uns ermöglicht, unsere eigene Datenzugriffsinfrastruktur aufzubauen und mit der strukturierten Abfragesprache, den verschiedenen Arten von Beziehungen (One- to-One, Many-to-Many usw.) und mehr. Dieser Artikel sollte also Anfänger ansprechen, aber die nächsten paar sollten sich an fortgeschrittenere Entwickler richten, die ihre Architektur verbessern möchten.

In diesem Fall kümmern wir uns nur um die Speicherung von Buchdaten. Wir kümmern uns nicht um Benutzerauthentifizierung, Passwort-Hashing, Architektur oder ähnliches Komplexes. All das wird in den nächsten und zukünftigen Artikeln kommen. Im Moment werden wir ganz einfach eine Methode erstellen, mit der es einem Client ermöglicht wird, mit unserem Webserver über das HTTP-Protokoll zu kommunizieren, um Buchinformationen in einer Datenbank zu speichern.

Anmerkung : Ich habe es hier absichtlich sehr einfach und vielleicht nicht so praktisch gehalten, weil dieser Artikel an und für sich sehr lang ist, da ich mir erlaubt habe, abzuweichen, um ergänzende Themen zu diskutieren. Daher werden wir die Qualität und Komplexität der API im Laufe dieser Serie schrittweise verbessern, aber da ich dies als eine Ihrer ersten Einführungen in Express betrachte, halte ich die Dinge absichtlich extrem einfach.

- ES6-Objektdestrukturierung

- ES6-Objekt-Kurzschrift

- ES6 Spread-Operator (...)

- Kommt ...

ES6-Objektdestrukturierung

ES6 Object Destructuring oder Destructuring Assignment Syntax ist eine Methode, mit der Werte aus Arrays oder Objekten in ihre eigenen Variablen extrahiert oder entpackt werden. Wir beginnen mit Objekteigenschaften und besprechen dann Array-Elemente.

const person = { name: 'Richard P. Feynman', occupation: 'Theoretical Physicist' }; // Log properties: console.log('Name:', person.name); console.log('Occupation:', person.occupation); Eine solche Operation ist ziemlich primitiv, kann aber ziemlich mühsam sein, wenn man bedenkt, dass wir immer und überall auf person.something verweisen müssen. Angenommen, es gäbe 10 andere Stellen in unserem Code, an denen wir das tun müssten – es würde ziemlich schnell ziemlich mühsam werden. Eine Methode der Kürze wäre, diese Werte ihren eigenen Variablen zuzuweisen.

const person = { name: 'Richard P. Feynman', occupation: 'Theoretical Physicist' }; const personName = person.name; const personOccupation = person.occupation; // Log properties: console.log('Name:', personName); console.log('Occupation:', personOccupation); Vielleicht sieht das vernünftig aus, aber was wäre, wenn wir auch 10 andere Eigenschaften im person verschachtelt hätten? Das wären viele unnötige Zeilen, nur um Variablen Werte zuzuweisen – an diesem Punkt sind wir in Gefahr, denn wenn Objekteigenschaften verändert werden, spiegeln unsere Variablen diese Änderung nicht wider (denken Sie daran, dass nur Verweise auf das Objekt mit const Zuweisung unveränderlich sind, nicht die Eigenschaften des Objekts), also können wir im Grunde den „Zustand“ (und ich verwende dieses Wort nur lose) nicht mehr synchron halten. Pass-by-Reference vs. Pass-by-Value könnten hier ins Spiel kommen, aber ich möchte nicht zu weit vom Rahmen dieses Abschnitts abweichen.

Mit ES6 Object Destructing können wir im Wesentlichen Folgendes tun:

const person = { name: 'Richard P. Feynman', occupation: 'Theoretical Physicist' }; // This is new. It's called Object Destructuring. const { name, occupation } = person; // Log properties: console.log('Name:', name); console.log('Occupation:', occupation); Wir erstellen kein neues Objekt/Objektliteral, wir entpacken die name und occupation aus dem ursprünglichen Objekt und fügen sie in ihre eigenen gleichnamigen Variablen ein. Die von uns verwendeten Namen müssen mit den Eigenschaftsnamen übereinstimmen, die wir extrahieren möchten.

Auch hier gilt die Syntax const { a, b } = someObject; bedeutet ausdrücklich, dass wir erwarten, dass einige Eigenschaften a und einige Eigenschaften b innerhalb someObject vorhanden sind (dh someObject könnte beispielsweise { a: 'dataA', b: 'dataB' } ) und dass wir die Werte platzieren möchten dieser Schlüssel/Eigenschaften innerhalb const Variablen mit demselben Namen. Aus diesem Grund würde uns die obige Syntax zwei Variablen liefern const a = someObject.a und const b = someObject.b .

Das bedeutet, dass die Objektdestrukturierung zwei Seiten hat. Die Seite „Vorlage“ und die Seite „Quelle“, wobei die Seite const { a, b } (die linke Seite) die Vorlage und die Seite someObject (die rechte Seite) die Quellseite ist – was sinnvoll ist — Wir definieren links eine Struktur oder „Vorlage“, die die Daten auf der „Quellenseite“ widerspiegelt.

Um dies noch einmal deutlich zu machen, hier ein paar Beispiele:

// ----- Destructure from Object Variable with const ----- // const objOne = { a: 'dataA', b: 'dataB' }; // Destructure const { a, b } = objOne; console.log(a); // dataA console.log(b); // dataB // ----- Destructure from Object Variable with let ----- // let objTwo = { c: 'dataC', d: 'dataD' }; // Destructure let { c, d } = objTwo; console.log(c); // dataC console.log(d); // dataD // Destructure from Object Literal with const ----- // const { e, f } = { e: 'dataE', f: 'dataF' }; // <-- Destructure console.log(e); // dataE console.log(f); // dataF // Destructure from Object Literal with let ----- // let { g, h } = { g: 'dataG', h: 'dataH' }; // <-- Destructure console.log(g); // dataG console.log(h); // dataHSpiegeln Sie im Fall von verschachtelten Eigenschaften dieselbe Struktur in Ihrer zerstörenden Zuweisung:

const person = { name: 'Richard P. Feynman', occupation: { type: 'Theoretical Physicist', location: { lat: 1, lng: 2 } } }; // Attempt one: const { name, occupation } = person; console.log(name); // Richard P. Feynman console.log(occupation); // The entire `occupation` object. // Attempt two: const { occupation: { type, location } } = person; console.log(type); // Theoretical Physicist console.log(location) // The entire `location` object. // Attempt three: const { occupation: { location: { lat, lng } } } = person; console.log(lat); // 1 console.log(lng); // 2Wie Sie sehen können, sind die Eigenschaften, die Sie abrufen möchten, optional, und um verschachtelte Eigenschaften zu entpacken, spiegeln Sie einfach die Struktur des ursprünglichen Objekts (der Quelle) in der Vorlagenseite Ihrer Destrukturierungssyntax wider. Wenn Sie versuchen, eine Eigenschaft zu destrukturieren, die auf dem ursprünglichen Objekt nicht vorhanden ist, ist dieser Wert undefiniert.

Wir können eine Variable zusätzlich destrukturieren, ohne sie vorher zu deklarieren – Zuweisung ohne Deklaration – mit der folgenden Syntax:

let name, occupation; const person = { name: 'Richard P. Feynman', occupation: 'Theoretical Physicist' }; ;({ name, occupation } = person); console.log(name); // Richard P. Feynman console.log(occupation); // Theoretical PhysicistWir stellen dem Ausdruck ein Semikolon voran, um sicherzustellen, dass wir nicht versehentlich einen IIFE (Immediately Invoked Function Expression) mit einer Funktion in einer vorherigen Zeile erstellen (falls eine solche Funktion existiert), und die Klammern um die Zuweisungsanweisung sind erforderlich Verhindern Sie, dass JavaScript Ihre linke Seite (Vorlage) als Block behandelt.

Ein sehr häufiger Anwendungsfall der Destrukturierung existiert innerhalb von Funktionsargumenten:

const config = { baseUrl: '<baseURL>', awsBucket: '<bucket>', secret: '<secret-key>' // <- Make this an env var. }; // Destructures `baseUrl` and `awsBucket` off `config`. const performOperation = ({ baseUrl, awsBucket }) => { fetch(baseUrl).then(() => console.log('Done')); console.log(awsBucket); // <bucket> }; performOperation(config);Wie Sie sehen können, hätten wir einfach die normale Destrukturierungssyntax verwenden können, an die wir jetzt innerhalb der Funktion gewöhnt sind, wie folgt:

const config = { baseUrl: '<baseURL>', awsBucket: '<bucket>', secret: '<secret-key>' // <- Make this an env var. }; const performOperation = someConfig => { const { baseUrl, awsBucket } = someConfig; fetch(baseUrl).then(() => console.log('Done')); console.log(awsBucket); // <bucket> }; performOperation(config);Aber wenn Sie diese Syntax in die Funktionssignatur einfügen, wird die Destrukturierung automatisch durchgeführt und wir sparen eine Zeile.

Ein realer Anwendungsfall dafür ist in React Functional Components for props :

import React from 'react'; // Destructure `titleText` and `secondaryText` from `props`. export default ({ titleText, secondaryText }) => ( <div> <h1>{titleText}</h1> <h3>{secondaryText}</h3> </div> );Im Gegensatz zu:

import React from 'react'; export default props => ( <div> <h1>{props.titleText}</h1> <h3>{props.secondaryText}</h3> </div> );In beiden Fällen können wir auch Standardwerte für die Eigenschaften festlegen:

const personOne = { name: 'User One', password: 'BCrypt Hash' }; const personTwo = { password: 'BCrypt Hash' }; const createUser = ({ name = 'Anonymous', password }) => { if (!password) throw new Error('InvalidArgumentException'); console.log(name); console.log(password); return { id: Math.random().toString(36) // <--- Should follow RFC 4122 Spec in real app. .substring(2, 15) + Math.random() .toString(36).substring(2, 15), name: name, // <-- We'll discuss this next. password: password // <-- We'll discuss this next. }; } createUser(personOne); // User One, BCrypt Hash createUser(personTwo); // Anonymous, BCrypt Hash Wie Sie sehen können, stellen wir für den Fall, dass der name bei der Destrukturierung nicht vorhanden ist, einen Standardwert bereit. Wir können dies auch mit der vorherigen Syntax tun:

const { a, b, c = 'Default' } = { a: 'dataA', b: 'dataB' }; console.log(a); // dataA console.log(b); // dataB console.log(c); // DefaultArrays können auch destrukturiert werden:

const myArr = [4, 3]; // Destructuring happens here. const [valOne, valTwo] = myArr; console.log(valOne); // 4 console.log(valTwo); // 3 // ----- Destructuring without assignment: ----- // let a, b; // Destructuring happens here. ;([a, b] = [10, 2]); console.log(a + b); // 12Ein praktischer Grund für die Destrukturierung von Arrays tritt bei React Hooks auf. (Und es gibt viele andere Gründe, ich verwende React nur als Beispiel).

import React, { useState } from "react"; export default () => { const [buttonText, setButtonText] = useState("Default"); return ( <button onClick={() => setButtonText("Toggled")}> {buttonText} </button> ); } Beachten Sie, dass useState aus dem Export destrukturiert wird und die Array-Funktionen/-Werte aus dem useState Hook destrukturiert werden. Machen Sie sich keine Sorgen, wenn das Obige keinen Sinn ergibt – Sie müssten React verstehen – und ich benutze es nur als Beispiel.

Obwohl die Objektdestrukturierung in ES6 mehr beinhaltet, werde ich hier ein weiteres Thema behandeln: Destrukturierende Umbenennung, die nützlich ist, um Bereichskollisionen oder Variablenschatten usw. zu verhindern. Angenommen, wir möchten eine Eigenschaft namens name von einem Objekt namens person destrukturieren, aber Es gibt bereits eine Variable mit dem Namen name im Geltungsbereich. Wir können mit einem Doppelpunkt spontan umbenennen:

// JS Destructuring Naming Collision Example: const name = 'Jamie Corkhill'; const person = { name: 'Alan Turing' }; // Rename `name` from `person` to `personName` after destructuring. const { name: personName } = person; console.log(name); // Jamie Corkhill <-- As expected. console.log(personName); // Alan Turing <-- Variable was renamed.Schließlich können wir auch Standardwerte mit Umbenennung festlegen:

const name = 'Jamie Corkhill'; const person = { location: 'New York City, United States' }; const { name: personName = 'Anonymous', location } = person; console.log(name); // Jamie Corkhill console.log(personName); // Anonymous console.log(location); // New York City, United States Wie Sie sehen können, wird in diesem Fall name from person ( person.name ) in personName umbenannt und auf den Standardwert Anonymous gesetzt, falls nicht vorhanden.

Und natürlich kann dasselbe in Funktionssignaturen ausgeführt werden:

const personOne = { name: 'User One', password: 'BCrypt Hash' }; const personTwo = { password: 'BCrypt Hash' }; const createUser = ({ name: personName = 'Anonymous', password }) => { if (!password) throw new Error('InvalidArgumentException'); console.log(personName); console.log(password); return { id: Math.random().toString(36).substring(2, 15) + Math.random().toString(36).substring(2, 15), name: personName, password: password // <-- We'll discuss this next. }; } createUser(personOne); // User One, BCrypt Hash createUser(personTwo); // Anonymous, BCrypt HashES6-Objekt-Kurzschrift

Angenommen, Sie haben die folgende Fabrik: (Wir werden Fabriken später behandeln)

const createPersonFactory = (name, location, position) => ({ name: name, location: location, position: position }); Man könnte diese Factory verwenden, um ein person wie folgt zu erstellen. Beachten Sie auch, dass die Factory implizit ein Objekt zurückgibt, was durch die Klammern um die Klammern der Pfeilfunktion ersichtlich ist.

const person = createPersonFactory('Jamie', 'Texas', 'Developer'); console.log(person); // { ... } Das kennen wir bereits aus der ES5 Object Literal Syntax. Beachten Sie jedoch, dass in der Factory-Funktion der Wert jeder Eigenschaft derselbe Name ist wie der Eigenschaftsbezeichner (Schlüssel) selbst. Das heißt — location: location oder name: name . Es stellte sich heraus, dass dies bei JS-Entwicklern ziemlich häufig vorkam.

Mit der abgekürzten Syntax von ES6 können wir das gleiche Ergebnis erzielen, indem wir die Factory wie folgt umschreiben:

const createPersonFactory = (name, location, position) => ({ name, location, position }); const person = createPersonFactory('Jamie', 'Texas', 'Developer'); console.log(person);Ausgabe erzeugen:

{ name: 'Jamie', location: 'Texas', position: 'Developer' }Es ist wichtig zu wissen, dass wir diese Abkürzung nur verwenden können, wenn das Objekt, das wir erstellen möchten, dynamisch basierend auf Variablen erstellt wird, wobei die Variablennamen dieselben sind wie die Namen der Eigenschaften, denen die Variablen zugewiesen werden sollen.

Dieselbe Syntax funktioniert mit Objektwerten:

const createPersonFactory = (name, location, position, extra) => ({ name, location, position, extra // <- right here. }); const extra = { interests: [ 'Mathematics', 'Quantum Mechanics', 'Spacecraft Launch Systems' ], favoriteLanguages: [ 'JavaScript', 'C#' ] }; const person = createPersonFactory('Jamie', 'Texas', 'Developer', extra); console.log(person);Ausgabe erzeugen:

{ name: 'Jamie', location: 'Texas', position: 'Developer', extra: { interests: [ 'Mathematics', 'Quantum Mechanics', 'Spacecraft Launch Systems' ], favoriteLanguages: [ 'JavaScript', 'C#' ] } }Als letztes Beispiel funktioniert dies auch mit Objektliteralen:

const id = '314159265358979'; const name = 'Archimedes of Syracuse'; const location = 'Syracuse'; const greatMathematician = { id, name, location };ES6 Spread-Operator (…)

Der Spread-Operator erlaubt uns, eine Vielzahl von Dingen zu tun, von denen wir einige hier besprechen werden.

Erstens können wir Eigenschaften von einem Objekt auf ein anderes Objekt verteilen:

const myObjOne = { a: 'a', b: 'b' }; const myObjTwo = { ...myObjOne }: Dies hat zur Folge, dass alle Eigenschaften von myObjOne auf myObjTwo werden, sodass myObjTwo jetzt { a: 'a', b: 'b' } . Wir können diese Methode verwenden, um vorherige Eigenschaften zu überschreiben. Angenommen, ein Benutzer möchte sein Konto aktualisieren:

const user = { name: 'John Doe', email: '[email protected]', password: ' ', bio: 'Lorem ipsum' }; const updates = { password: ' ', bio: 'Ipsum lorem', email: '[email protected]' }; const updatedUser = { ...user, // <- original ...updates // <- updates }; console.log(updatedUser); /* { name: 'John Doe', email: '[email protected]', // Updated password: ' ', // Updated bio: 'Ipsum lorem' } */const user = { name: 'John Doe', email: '[email protected]', password: ' ', bio: 'Lorem ipsum' }; const updates = { password: ' ', bio: 'Ipsum lorem', email: '[email protected]' }; const updatedUser = { ...user, // <- original ...updates // <- updates }; console.log(updatedUser); /* { name: 'John Doe', email: '[email protected]', // Updated password: ' ', // Updated bio: 'Ipsum lorem' } */const user = { name: 'John Doe', email: '[email protected]', password: ' ', bio: 'Lorem ipsum' }; const updates = { password: ' ', bio: 'Ipsum lorem', email: '[email protected]' }; const updatedUser = { ...user, // <- original ...updates // <- updates }; console.log(updatedUser); /* { name: 'John Doe', email: '[email protected]', // Updated password: ' ', // Updated bio: 'Ipsum lorem' } */const user = { name: 'John Doe', email: '[email protected]', password: ' ', bio: 'Lorem ipsum' }; const updates = { password: ' ', bio: 'Ipsum lorem', email: '[email protected]' }; const updatedUser = { ...user, // <- original ...updates // <- updates }; console.log(updatedUser); /* { name: 'John Doe', email: '[email protected]', // Updated password: ' ', // Updated bio: 'Ipsum lorem' } */

Das gleiche kann mit Arrays durchgeführt werden:

const apollo13Astronauts = ['Jim', 'Jack', 'Fred']; const apollo11Astronauts = ['Neil', 'Buz', 'Michael']; const unionOfAstronauts = [...apollo13Astronauts, ...apollo11Astronauts]; console.log(unionOfAstronauts); // ['Jim', 'Jack', 'Fred', 'Neil', 'Buz, 'Michael'];Beachten Sie hier, dass wir eine Vereinigung beider Sätze (Arrays) erstellt haben, indem wir die Arrays in einem neuen Array verteilt haben.

Der Rest/Spread-Operator hat noch viel mehr zu bieten, aber das geht über den Rahmen dieses Artikels hinaus. Es kann beispielsweise verwendet werden, um mehrere Argumente für eine Funktion zu erhalten. Wenn Sie mehr erfahren möchten, sehen Sie sich hier die MDN-Dokumentation an.

ES6 Asynchron/Warten

Async/Await ist eine Syntax, um den Schmerz der Verkettung von Versprechen zu lindern.

Das await reservierte Schlüsselwort ermöglicht es Ihnen, auf die Abwicklung eines Versprechens zu „warten“, aber es darf nur in Funktionen verwendet werden, die mit dem async Schlüsselwort gekennzeichnet sind. Angenommen, ich habe eine Funktion, die ein Versprechen zurückgibt. In einer neuen async Funktion kann ich auf das Ergebnis dieses Versprechens await , anstatt .then und .catch .

// Returns a promise. const myFunctionThatReturnsAPromise = () => { return new Promise((resolve, reject) => { setTimeout(() => resolve('Hello'), 3000); }); } const myAsyncFunction = async () => { const promiseResolutionResult = await myFunctionThatReturnsAPromise(); console.log(promiseResolutionResult); }; // Writes the log statement after three seconds. myAsyncFunction(); Hier gibt es einiges zu beachten. Wenn wir await in einer async Funktion verwenden, geht nur der aufgelöste Wert in die Variable auf der linken Seite. Wenn die Funktion ablehnt, ist das ein Fehler, den wir abfangen müssen, wie wir gleich sehen werden. Darüber hinaus gibt jede als async gekennzeichnete Funktion standardmäßig ein Versprechen zurück.

Nehmen wir an, ich müsste zwei API-Aufrufe durchführen, einen mit der Antwort des ersteren. Mit Promises und Promise Chaining könntest du es so machen:

const makeAPICall = route => new Promise((resolve, reject) => { console.log(route) resolve(route); }); const main = () => { makeAPICall('/whatever') .then(response => makeAPICall(response + ' second call')) .then(response => console.log(response + ' logged')) .catch(err => console.error(err)) }; main(); // Result: /* /whatever /whatever second call /whatever second call logged */ Was hier passiert, ist, dass wir zuerst makeAPICall und an /whatever übergeben, was beim ersten Mal protokolliert wird. Das Versprechen wird mit diesem Wert aufgelöst. Dann rufen wir erneut makeAPICall auf und übergeben ihm /whatever second call , der protokolliert wird, und wieder wird das Promise mit diesem neuen Wert aufgelöst. Schließlich nehmen wir den neuen Wert /whatever second call , mit dem das Promise gerade aufgelöst wurde, und protokollieren ihn selbst im letzten Protokoll, wobei wir am Ende ein logged anhängen. Wenn dies keinen Sinn macht, sollten Sie sich mit Promise Chaining befassen.

Mit async / await können wir Folgendes umgestalten:

const main = async () => { const resultOne = await makeAPICall('/whatever'); const resultTwo = await makeAPICall(resultOne + ' second call'); console.log(resultTwo + ' logged'); }; Folgendes wird passieren. Die gesamte Funktion stoppt die Ausführung bei der allerersten await -Anweisung, bis das Versprechen des ersten Aufrufs von makeAPICall aufgelöst wird. Nach der Auflösung wird der aufgelöste Wert in resultOne platziert. Wenn dies geschieht, bewegt sich die Funktion zur zweiten await Anweisung und pausiert genau dort erneut für die Dauer der Promise-Abwicklung. Wenn das Promise aufgelöst wird, wird das Auflösungsergebnis in resultTwo . Wenn die Idee der Funktionsausführung blockiert klingt, fürchten Sie sich nicht, sie ist immer noch asynchron, und ich werde gleich erläutern, warum.

Dies zeigt nur den „glücklichen“ Weg. Für den Fall, dass eines der Promises abgelehnt wird, können wir das mit try/catch abfangen, denn wenn das Promise abgelehnt wird, wird ein Fehler geworfen – der der Fehler ist, mit dem das Promise abgelehnt wurde.

const main = async () => { try { const resultOne = await makeAPICall('/whatever'); const resultTwo = await makeAPICall(resultOne + ' second call'); console.log(resultTwo + ' logged'); } catch (e) { console.log(e) } }; Wie ich bereits sagte, gibt jede als async deklarierte Funktion ein Versprechen zurück. Wenn Sie also eine asynchrone Funktion von einer anderen Funktion aufrufen möchten, können Sie normale Zusagen verwenden oder await , bis Sie die aufrufende Funktion async deklarieren. Wenn Sie jedoch eine async Funktion aus dem Code der obersten Ebene aufrufen und auf das Ergebnis warten möchten, müssen Sie .then und .catch .

Zum Beispiel:

const returnNumberOne = async () => 1; returnNumberOne().then(value => console.log(value)); // 1Oder Sie könnten einen Immediately Invoked Function Expression (IIFE) verwenden:

(async () => { const value = await returnNumberOne(); console.log(value); // 1 })(); Wenn Sie await in einer async Funktion verwenden, wird die Ausführung der Funktion bei dieser await-Anweisung angehalten, bis das Promise erfüllt ist. Alle anderen Funktionen können jedoch frei mit der Ausführung fortfahren, sodass weder zusätzliche CPU-Ressourcen zugewiesen noch der Thread jemals blockiert wird. Ich sage das noch einmal – Operationen in dieser bestimmten Funktion zu diesem bestimmten Zeitpunkt werden angehalten, bis das Versprechen erfüllt ist, aber alle anderen Funktionen können frei ausgelöst werden. Stellen Sie sich einen HTTP-Webserver vor – auf Anfragebasis können alle Funktionen für alle Benutzer gleichzeitig ausgelöst werden, wenn Anfragen gestellt werden, es ist nur so, dass die async/await-Syntax die Illusion vermittelt, dass eine Operation synchron und blockierend ist verspricht einfacher zu arbeiten, aber auch hier bleibt alles nett und asynchron.

Dies ist nicht alles, was es zu async / await zu tun gibt, aber es sollte Ihnen helfen, die Grundprinzipien zu verstehen.

Klassische OOP-Fabriken

Wir verlassen jetzt die JavaScript -Welt und betreten die Java -Welt. Es kann eine Zeit kommen, in der der Erstellungsprozess eines Objekts (in diesem Fall eine Instanz einer Klasse – wieder Java) ziemlich komplex ist oder wenn wir verschiedene Objekte basierend auf einer Reihe von Parametern erzeugt haben möchten. Ein Beispiel könnte eine Funktion sein, die verschiedene Fehlerobjekte erstellt. Eine Fabrik ist ein gängiges Entwurfsmuster in der objektorientierten Programmierung und ist im Grunde eine Funktion, die Objekte erstellt. Um dies zu untersuchen, lassen Sie uns weg von JavaScript in die Welt von Java gehen. Dies wird für Entwickler sinnvoll sein, die aus einem klassischen OOP (dh nicht prototypischen), statisch typisierten Sprachhintergrund kommen. Wenn Sie kein solcher Entwickler sind, können Sie diesen Abschnitt gerne überspringen. Dies ist eine kleine Abweichung, und wenn das Befolgen hier Ihren JavaScript-Fluss unterbricht, dann überspringen Sie bitte auch diesen Abschnitt.

Das Fabrikmuster ist ein gängiges Erstellungsmuster und ermöglicht es uns, Objekte zu erstellen, ohne die erforderliche Geschäftslogik zur Durchführung dieser Erstellung offenzulegen.

Angenommen, wir schreiben ein Programm, das uns erlaubt, primitive Formen in n-Dimensionen zu visualisieren. Wenn wir beispielsweise einen Würfel bereitstellen, würden wir einen 2D-Würfel (ein Quadrat), einen 3D-Würfel (einen Würfel) und einen 4D-Würfel (ein Tesseract oder Hypercube) sehen. So könnte dies trivial und mit Ausnahme des eigentlichen Zeichenteils in Java geschehen.

// Main.java // Defining an interface for the shape (can be used as a base type) interface IShape { void draw(); } // Implementing the interface for 2-dimensions: class TwoDimensions implements IShape { @Override public void draw() { System.out.println("Drawing a shape in 2D."); } } // Implementing the interface for 3-dimensions: class ThreeDimensions implements IShape { @Override public void draw() { System.out.println("Drawing a shape in 3D."); } } // Implementing the interface for 4-dimensions: class FourDimensions implements IShape { @Override public void draw() { System.out.println("Drawing a shape in 4D."); } } // Handles object creation class ShapeFactory { // Factory method (notice return type is the base interface) public IShape createShape(int dimensions) { switch(dimensions) { case 2: return new TwoDimensions(); case 3: return new ThreeDimensions(); case 4: return new FourDimensions(); default: throw new IllegalArgumentException("Invalid dimension."); } } } // Main class and entry point. public class Main { public static void main(String[] args) throws Exception { ShapeFactory shapeFactory = new ShapeFactory(); IShape fourDimensions = shapeFactory.createShape(4); fourDimensions.draw(); // Drawing a shape in 4D. } } Wie Sie sehen können, definieren wir eine Schnittstelle, die eine Methode zum Zeichnen einer Form angibt. Indem die verschiedenen Klassen die Schnittstelle implementieren, können wir garantieren, dass alle Formen gezeichnet werden können (da sie alle eine überschreibbare draw gemäß der Schnittstellendefinition haben müssen). Da diese Form abhängig von den Dimensionen, in denen sie betrachtet wird, unterschiedlich gezeichnet wird, definieren wir Hilfsklassen, die die Schnittstelle implementieren, um die GPU-intensive Arbeit der Simulation des n-dimensionalen Renderings auszuführen. ShapeFactory übernimmt die Arbeit, die richtige Klasse zu instanziieren – die createShape Methode ist eine Factory, und wie die obige Definition ist sie eine Methode, die ein Objekt einer Klasse zurückgibt. Der Rückgabetyp von createShape ist die IShape Schnittstelle, weil die IShape -Schnittstelle der Basistyp aller Formen ist (weil sie eine draw Methode haben).

Dieses Java-Beispiel ist ziemlich trivial, aber Sie können leicht erkennen, wie nützlich es in größeren Anwendungen wird, in denen die Einrichtung zum Erstellen eines Objekts möglicherweise nicht so einfach ist. Ein Beispiel dafür wäre ein Videospiel. Angenommen, der Benutzer muss verschiedene Feinde überleben. Abstrakte Klassen und Schnittstellen können verwendet werden, um Kernfunktionen zu definieren, die allen Feinden zur Verfügung stehen (und Methoden, die außer Kraft gesetzt werden können), möglicherweise unter Verwendung des Delegationsmusters (bevorzugen Sie die Komposition gegenüber der Vererbung, wie die Gang of Four vorgeschlagen hat, damit Sie nicht in die Erweiterung von a einzelne Basisklasse und um das Testen/Mocking/DI einfacher zu machen). Für feindliche Objekte, die auf unterschiedliche Weise instanziiert werden, würde die Schnittstelle die Erstellung von Factory-Objekten ermöglichen, während sie sich auf den generischen Schnittstellentyp verlässt. Dies wäre sehr relevant, wenn der Feind dynamisch erstellt würde.

Ein weiteres Beispiel ist eine Builder-Funktion. Angenommen, wir verwenden das Delegationsmuster, um einen Klassendelegierten für andere Klassen arbeiten zu lassen, die eine Schnittstelle berücksichtigen. Wir könnten eine statische build -Methode in der Klasse platzieren, damit sie ihre eigene Instanz erstellt (vorausgesetzt, Sie verwenden keinen Dependency Injection Container/Framework). Anstatt jeden Setter anrufen zu müssen, können Sie Folgendes tun:

public class User { private IMessagingService msgService; private String name; private int age; public User(String name, int age, IMessagingService msgService) { this.name = name; this.age = age; this.msgService = msgService; } public static User build(String name, int age) { return new User(name, age, new SomeMessageService()); } } Ich werde das Delegationsmuster in einem späteren Artikel erklären, wenn Sie damit nicht vertraut sind – im Grunde erstellt es durch Komposition und in Bezug auf die Objektmodellierung eine „hat-ein“-Beziehung anstelle einer „ist-ein“-Beziehung. Beziehung, wie Sie es mit einer Erbschaft bekommen würden. Wenn Sie eine Mammal -Klasse und eine Dog -Klasse haben und Dog Mammal erweitert, dann ist ein Dog ein Mammal . Wenn Sie dagegen eine Bark -Klasse hatten und nur Instanzen von Bark an den Konstruktor von Dog übergeben haben, dann hat Dog -a Bark . Wie Sie sich vorstellen können, erleichtert dies insbesondere das Testen von Einheiten, da Sie Mocks einfügen und Fakten über das Mock behaupten können, solange Mock den Schnittstellenvertrag in der Testumgebung einhält.

Die obige static „Build“-Factory-Methode erstellt einfach ein neues Objekt von User und übergibt einen konkreten MessageService . Beachten Sie, wie dies aus der obigen Definition folgt – die Geschäftslogik zum Erstellen eines Objekts einer Klasse nicht verfügbar macht, oder in diesem Fall, die Erstellung des Messaging-Dienstes nicht dem Anrufer der Fabrik preiszugeben.

Auch dies ist nicht unbedingt die Art und Weise, wie Sie die Dinge in der realen Welt tun würden, aber es präsentiert die Idee einer Fabrikfunktion / -methode recht gut. Wir könnten stattdessen beispielsweise einen Dependency Injection-Container verwenden. Nun zurück zu JavaScript.

Beginnend mit Express

Express ist ein Webanwendungs-Framework für Node (verfügbar über ein NPM-Modul), das die Erstellung eines HTTP-Webservers ermöglicht. Es ist wichtig zu beachten, dass Express nicht das einzige Framework ist, das dies tut (es gibt Koa, Fastify usw.), und dass Node, wie im vorherigen Artikel gezeigt, ohne Express als eigenständige Einheit funktionieren kann. (Express ist lediglich ein Modul, das für Node entwickelt wurde – Node kann viele Dinge ohne es tun, obwohl Express für Webserver beliebt ist).

Lassen Sie mich noch einmal eine sehr wichtige Unterscheidung treffen. Zwischen Node/JavaScript und Express besteht eine Dichotomie. Node, die Laufzeit/Umgebung, in der Sie JavaScript ausführen, kann viele Dinge tun – Ihnen beispielsweise erlauben, React Native-Apps, Desktop-Apps, Befehlszeilentools usw. zu erstellen. Express ist nichts anderes als ein leichtes Framework, das Sie verwenden können Node/JS zum Erstellen von Webservern, anstatt sich mit dem Low-Level-Netzwerk und den HTTP-APIs von Node zu befassen. Sie benötigen Express nicht, um einen Webserver zu erstellen.

Bevor Sie mit diesem Abschnitt beginnen, empfehle ich Ihnen, den entsprechenden Abschnitt meines früheren Artikels zu lesen, der oben verlinkt ist, wenn Sie mit HTTP und HTTP-Anforderungen (GET, POST usw.) nicht vertraut sind.

Mit Express richten wir verschiedene Routen ein, an die HTTP-Anforderungen gestellt werden können, sowie die zugehörigen Endpunkte (bei denen es sich um Rückruffunktionen handelt), die ausgelöst werden, wenn eine Anforderung an diese Route gesendet wird. Machen Sie sich keine Sorgen, wenn Routen und Endpunkte derzeit keinen Sinn machen – ich werde sie später erklären.

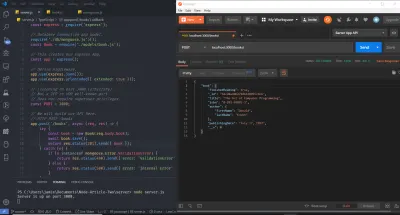

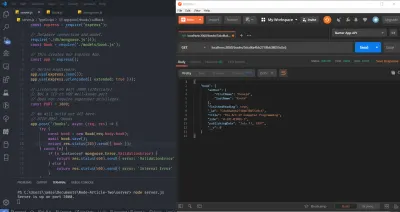

Im Gegensatz zu anderen Artikeln werde ich den Ansatz verfolgen, den Quellcode Zeile für Zeile zu schreiben, anstatt die gesamte Codebasis in einen Ausschnitt zu packen und später zu erklären. Beginnen wir mit dem Öffnen eines Terminals (ich verwende Terminus auf Git Bash unter Windows – was eine nette Option für Windows-Benutzer ist, die eine Bash-Shell ohne Einrichtung des Linux-Subsystems wünschen), dem Einrichten der Boilerplate unseres Projekts und dem Öffnen in Visual Studio-Code.

mkdir server && cd server touch server.js npm init -y npm install express code . In der server.js -Datei beginne ich damit, express mit der require() Funktion anzufordern.

const express = require('express'); require('express') weist Node an, das zuvor installierte Express-Modul zu holen, das sich derzeit im Ordner node_modules befindet (dafür tut npm install — erstellt einen Ordner node_modules und legt Module und ihre Abhängigkeiten dort ab). Gemäß der Konvention und wenn wir uns mit Express befassen, nennen wir die Variable, die das Rückgabeergebnis von require('express') enthält, express , obwohl sie beliebig heißen kann.

This returned result, which we have called express , is actually a function — a function we'll have to invoke to create our Express app and set up our routes. Again, by convention, we call this app — app being the return result of express() — that is, the return result of calling the function that has the name express as express() .

const express = require('express'); const app = express(); // Note that the above variable names are the convention, but not required. // An example such as that below could also be used. const foo = require('express'); const bar = foo(); // Note also that the node module we installed is called express. The line const app = express(); simply puts a new Express Application inside of the app variable. It calls a function named express (the return result of require('express') ) and stores its return result in a constant named app . If you come from an object-oriented programming background, consider this equivalent to instantiating a new object of a class, where app would be the object and where express() would call the constructor function of the express class. Remember, JavaScript allows us to store functions in variables — functions are first-class citizens. The express variable, then, is nothing more than a mere function. It's provided to us by the developers of Express.

I apologize in advance if I'm taking a very long time to discuss what is actually very basic, but the above, although primitive, confused me quite a lot when I was first learning back-end development with Node.

Inside the Express source code, which is open-source on GitHub, the variable we called express is a function entitled createApplication , which, when invoked, performs the work necessary to create an Express Application:

A snippet of Express source code:

exports = module.exports = createApplication; /* * Create an express application */ // This is the function we are storing in the express variable. (- Jamie) function createApplication() { // This is what I mean by "Express App" (- Jamie) var app = function(req, res, next) { app.handle(req, res, next); }; mixin(app, EventEmitter.prototype, false); mixin(app, proto, false); // expose the prototype that will get set on requests app.request = Object.create(req, { app: { configurable: true, enumerable: true, writable: true, value: app } }) // expose the prototype that will get set on responses app.response = Object.create(res, { app: { configurable: true, enumerable: true, writable: true, value: app } }) app.init(); // See - `app` gets returned. (- Jamie) return app; }GitHub: https://github.com/expressjs/express/blob/master/lib/express.js

With that short deviation complete, let's continue setting up Express. Thus far, we have required the module and set up our app variable.

const express = require('express'); const app = express(); From here, we have to tell Express to listen on a port. Any HTTP Requests made to the URL and Port upon which our application is listening will be handled by Express. We do that by calling app.listen(...) , passing to it the port and a callback function which gets called when the server starts running:

const PORT = 3000; app.listen(PORT, () => console.log(`Server is up on port {PORT}.`)); We notate the PORT variable in capital by convention, for it is a constant variable that will never change. You could do that with all variables that you declare const , but that would look messy. It's up to the developer or development team to decide on notation, so we'll use the above sparsely. I use const everywhere as a method of “defensive coding” — that is, if I know that a variable is never going to change then I might as well just declare it const . Since I define everything const , I make the distinction between what variables should remain the same on a per-request basis and what variables are true actual global constants.

Here is what we have thus far:

const express = require('express'); const app = express(); const PORT = 3000; // We will build our API here. // ... // Binding our application to port 3000. app.listen(PORT, () => { console.log(`Server is up on port ${PORT}.`); });Let's test this to see if the server starts running on port 3000.

I'll open a terminal and navigate to our project's root directory. I'll then run node server/server.js . Note that this assumes you have Node already installed on your system (You can check with node -v ).

If everything works, you should see the following in the terminal:

Server is up on port 3000.

Go ahead and hit Ctrl + C to bring the server back down.

If this doesn't work for you, or if you see an error such as EADDRINUSE , then it means you may have a service already running on port 3000. Pick another port number, like 3001, 3002, 5000, 8000, etc. Be aware, lower number ports are reserved and there is an upper bound of 65535.

At this point, it's worth taking another small deviation as to understand servers and ports in the context of computer networking. We'll return to Express in a moment. I take this approach, rather than introducing servers and ports first, for the purpose of relevance. That is, it is difficult to learn a concept if you fail to see its applicability. In this way, you are already aware of the use case for ports and servers with Express, so the learning experience will be more pleasurable.

A Brief Look At Servers And Ports

A server is simply a computer or computer program that provides some sort of “functionality” to the clients that talk to it. More generally, it's a device, usually connected to the Internet, that handles connections in a pre-defined manner. In our case, that “pre-defined manner” will be HTTP or the HyperText Transfer Protocol. Servers that use the HTTP Protocol are called Web Servers.

When building an application, the server is a critical component of the “client-server model”, for it permits the sharing and syncing of data (generally via databases or file systems) across devices. It's a cross-platform approach, in a way, for the SDKs of platforms against which you may want to code — be they web, mobile, or desktop — all provide methods (APIs) to interact with a server over HTTP or TCP/UDP Sockets. It's important to make a distinction here — by APIs, I mean programming language constructs to talk to a server, like XMLHttpRequest or the Fetch API in JavaScript, or HttpUrlConnection in Java, or even HttpClient in C#/.NET. This is different from the kind of REST API we'll be building in this article to perform CRUD Operations on a database.

To talk about ports, it's important to understand how clients connect to a server. A client requires the IP Address of the server and the Port Number of our specific service on that server. An IP Address, or Internet Protocol Address, is just an address that uniquely identifies a device on a network. Public and private IPs exist, with private addresses commonly used behind a router or Network Address Translator on a local network. You might see private IP Addresses of the form 192.168.XXX.XXX or 10.0.XXX.XXX . When articulating an IP Address, decimals are called “dots”. So 192.168.0.1 (a common router IP Addr.) might be pronounced, “one nine two dot one six eight dot zero dot one”. (By the way, if you're ever in a hotel and your phone/laptop won't direct you to the AP captive portal, try typing 192.168.0.1 or 192.168.1.1 or similar directly into Chrome).

For simplicity, and since this is not an article about the complexities of computer networking, assume that an IP Address is equivalent to a house address, allowing you to uniquely identify a house (where a house is analogous to a server, client, or network device) in a neighborhood. One neighborhood is one network. Put together all of the neighborhoods in the United States, and you have the public Internet. (This is a basic view, and there are many more complexities — firewalls, NATs, ISP Tiers (Tier One, Tier Two, and Tier Three), fiber optics and fiber optic backbones, packet switches, hops, hubs, etc., subnet masks, etc., to name just a few — in the real networking world.) The traceroute Unix command can provide more insight into the above, displaying the path (and associated latency) that packets take through a network as a series of “hops”.

Eine Portnummer identifiziert einen bestimmten Dienst, der auf einem Server ausgeführt wird. SSH oder Secure Shell, das den Remote-Shell-Zugriff auf ein Gerät ermöglicht, wird normalerweise auf Port 22 ausgeführt. FTP oder File Transfer Protocol (das beispielsweise mit einem FTP-Client verwendet werden kann, um statische Assets auf einen Server zu übertragen) wird normalerweise ausgeführt auf Port 21. Wir könnten also sagen, dass Häfen in unserer obigen Analogie spezifische Räume in jedem Haus sind, denn Räume in Häusern sind für verschiedene Dinge gemacht – ein Schlafzimmer zum Schlafen, eine Küche zum Zubereiten von Speisen, ein Esszimmer zum Verzehr des Gesagten Lebensmittel usw. entsprechen genau wie Häfen Programmen, die bestimmte Dienste ausführen. Für uns laufen Webserver normalerweise auf Port 80, obwohl Sie frei wählen können, welche Portnummer Sie wünschen, solange sie nicht von einem anderen Dienst verwendet werden (sie können nicht kollidieren).

Um auf eine Website zuzugreifen, benötigen Sie die IP-Adresse der Website. Trotzdem greifen wir normalerweise über eine URL auf Websites zu. Hinter den Kulissen wandelt ein DNS oder Domain Name Server diese URL in eine IP-Adresse um, sodass der Browser eine GET-Anfrage an den Server stellen , den HTML-Code abrufen und auf dem Bildschirm darstellen kann. 8.8.8.8 ist die Adresse eines der öffentlichen DNS-Server von Google. Sie können sich vorstellen, dass die Auflösung eines Hostnamens in eine IP-Adresse über einen Remote-DNS-Server einige Zeit in Anspruch nehmen wird, und Sie haben Recht. Um die Latenz zu reduzieren, verfügen Betriebssysteme über einen DNS-Cache – eine temporäre Datenbank, die DNS-Lookup-Informationen speichert, wodurch die Häufigkeit reduziert wird, mit der diese Lookups durchgeführt werden müssen. Der DNS-Resolver-Cache kann unter Windows mit dem CMD-Befehl ipconfig /displaydns und mit dem Befehl ipconfig /flushdns .

Auf einem Unix-Server erfordern häufigere Ports mit niedrigeren Nummern, wie 80, Berechtigungen auf Root- Ebene ( eskaliert, wenn Sie von einem Windows-Hintergrund kommen). Aus diesem Grund verwenden wir Port 3000 für unsere Entwicklungsarbeit, erlauben dem Server jedoch, die Portnummer (was auch immer verfügbar ist) auszuwählen, wenn wir sie in unserer Produktionsumgebung bereitstellen.

Beachten Sie schließlich, dass wir IP-Adressen direkt in die Suchleiste von Google Chrome eingeben können, wodurch der DNS-Auflösungsmechanismus umgangen wird. Wenn Sie beispielsweise 216.58.194.36 , gelangen Sie zu Google.com. Wenn wir in unserer Entwicklungsumgebung unseren eigenen Computer als Entwicklungsserver verwenden, verwenden wir localhost und Port 3000. Eine Adresse wird als hostname:port formatiert, sodass unser Server auf localhost:3000 läuft. Localhost oder 127.0.0.1 ist die Loopback-Adresse und bedeutet die Adresse von „diesem Computer“. Es ist ein Hostname und seine IPv4-Adresse wird zu 127.0.0.1 . Versuchen Sie jetzt, localhost auf Ihrem Computer zu pingen. Sie erhalten möglicherweise ::1 zurück – das ist die IPv6-Loopback-Adresse oder 127.0.0.1 zurück – das ist die IPv4-Loopback-Adresse. IPv4 und IPv6 sind zwei unterschiedliche IP-Adressformate, die unterschiedlichen Standards zugeordnet sind – einige IPv6-Adressen können in IPv4 konvertiert werden, aber nicht alle.

Zurück zu Express

Ich habe HTTP-Anforderungen, Verben und Statuscodes in meinem vorherigen Artikel Erste Schritte mit Node: Eine Einführung in APIs, HTTP und ES6+-JavaScript erwähnt. Wenn Sie das Protokoll nicht allgemein verstehen, können Sie gerne zum Abschnitt „HTTP- und HTTP-Anforderungen“ dieses Artikels springen.

Um ein Gefühl für Express zu bekommen, richten wir einfach unsere Endpunkte für die vier grundlegenden Operationen ein, die wir an der Datenbank durchführen werden – Erstellen, Lesen, Aktualisieren und Löschen, zusammenfassend als CRUD bekannt.

Denken Sie daran, dass wir über Routen in der URL auf Endpunkte zugreifen. Das heißt, obwohl die Wörter „Route“ und „Endpunkt“ häufig synonym verwendet werden, ist ein Endpunkt technisch gesehen eine Programmiersprachenfunktion (wie ES6 Arrow Functions), die einige serverseitige Vorgänge ausführt, während eine Route das ist, was sich hinter dem Endpunkt befindet von . Wir spezifizieren diese Endpunkte als Callback-Funktionen, die Express auslöst, wenn die entsprechende Anfrage vom Client an die Route gestellt wird, hinter der sich der Endpunkt befindet. Sie können sich das Obige merken, indem Sie erkennen, dass es Endpunkte sind, die eine Funktion ausführen, und die Route der Name ist, der für den Zugriff auf die Endpunkte verwendet wird. Wie wir sehen werden, kann dieselbe Route mehreren Endpunkten zugeordnet werden, indem verschiedene HTTP-Verben verwendet werden (ähnlich wie beim Überladen von Methoden, wenn Sie aus einem klassischen OOP-Hintergrund mit Polymorphismus kommen).

Denken Sie daran, dass wir der REST-Architektur (REpresentational State Transfer) folgen, indem wir Clients erlauben, Anfragen an unseren Server zu stellen. Dies ist schließlich eine REST- oder RESTful-API. Bestimmte Anfragen an bestimmte Routen lösen bestimmte Endpunkte aus, die bestimmte Dinge tun. Ein Beispiel für so etwas, das ein Endpunkt tun könnte, ist das Hinzufügen neuer Daten zu einer Datenbank, das Entfernen von Daten, das Aktualisieren von Daten usw.

Express weiß, welcher Endpunkt ausgelöst werden soll, weil wir ihm explizit die Anforderungsmethode (GET, POST usw.) und die Route mitteilen – wir definieren, welche Funktionen für bestimmte Kombinationen der oben genannten ausgelöst werden sollen, und der Client stellt die Anforderung, indem er a angibt Weg und Methode. Um es einfacher auszudrücken, mit Node sagen wir Express – „Hey, wenn jemand eine GET-Anfrage an diese Route stellt, dann feuere diese Funktion ab (verwende diesen Endpunkt)“. Die Dinge können komplizierter werden: „Express, wenn jemand eine GET-Anfrage an diese Route stellt, aber kein gültiges Authorization Bearer Token im Header seiner Anfrage hochsendet, dann antworte bitte mit einem HTTP 401 Unauthorized . Wenn sie ein gültiges Bearer Token besitzen, senden Sie bitte die geschützte Ressource, nach der sie gesucht haben, herunter, indem Sie den Endpunkt auslösen. Vielen Dank und einen schönen Tag.“ In der Tat wäre es schön, wenn Programmiersprachen auf diesem hohen Niveau sein könnten, ohne Mehrdeutigkeiten zu verlieren, aber es demonstriert dennoch die grundlegenden Konzepte.

Denken Sie daran, dass der Endpunkt in gewisser Weise hinter der Route lebt . Daher ist es zwingend erforderlich, dass der Client im Header der Anfrage angibt, welche Methode er verwenden möchte, damit Express herausfinden kann, was zu tun ist. Die Anforderung wird an eine bestimmte Route gesendet, die der Client (zusammen mit dem Anforderungstyp) beim Kontaktieren des Servers angibt, sodass Express das tun kann, was es tun muss, und wir das tun, was wir tun müssen, wenn Express unsere Rückrufe auslöst . Darauf kommt es an.

In den Codebeispielen zuvor haben wir die Funktion listen aufgerufen, die auf app verfügbar war, und ihr einen Port und einen Rückruf übergeben. app selbst ist, wenn Sie sich erinnern, das Rückgabeergebnis des Aufrufs der express Variablen als Funktion (d. h. express() ), und die express Variable ist das, was wir das Rückgabeergebnis genannt haben, weil wir 'express' aus unserem node_modules Ordner benötigen. Genauso wie listen in app aufgerufen wird, geben wir HTTP-Anforderungsendpunkte an, indem wir sie in app aufrufen. Schauen wir uns GET an:

app.get('/my-test-route', () => { // ... }); Der erste Parameter ist ein string , und es ist die Route, hinter der der Endpunkt leben wird. Die Callback-Funktion ist der Endpunkt. Ich sage das noch einmal: Die Callback-Funktion – der zweite Parameter – ist der Endpunkt , der ausgelöst wird, wenn eine HTTP GET-Anfrage an die Route gestellt wird, die wir als erstes Argument angeben (in diesem Fall /my-test-route ).

Bevor wir nun weiter mit Express arbeiten, müssen wir wissen, wie Routen funktionieren. Die Route, die wir als Zeichenfolge angeben, wird aufgerufen, indem die Anfrage an www.domain.com/the-route-we-chose-earlier-as-a-string . In unserem Fall ist die Domäne localhost:3000 , was bedeutet, dass wir zum Auslösen der obigen Callback-Funktion eine GET-Anforderung an localhost:3000/my-test-route stellen müssen. Wenn wir oben eine andere Zeichenfolge als erstes Argument verwendet hätten, müsste die URL anders sein, damit sie mit der übereinstimmt, die wir in JavaScript angegeben haben.

Wenn Sie über solche Dinge sprechen, werden Sie wahrscheinlich von Glob Patterns hören. Wir könnten sagen, dass sich alle unsere API-Routen unter localhost:3000/** Glob Pattern befinden, wobei ** ein Platzhalter ist, der ein beliebiges Verzeichnis oder Unterverzeichnis bedeutet (beachten Sie, dass Routen keine Verzeichnisse sind), denen root ein übergeordnetes Element ist – das ist alles.

Lassen Sie uns fortfahren und dieser Callback-Funktion eine Protokollanweisung hinzufügen, sodass wir insgesamt Folgendes haben:

// Getting the module from node_modules. const express = require('express'); // Creating our Express Application. const app = express(); // Defining the port we'll bind to. const PORT = 3000; // Defining a new endpoint behind the "/my-test-route" route. app.get('/my-test-route', () => { console.log('A GET Request was made to /my-test-route.'); }); // Binding the server to port 3000. app.listen(PORT, () => { console.log(`Server is up on port ${PORT}.`) }); Wir bringen unseren Server zum Laufen, indem wir node server/server.js (wobei Node auf unserem System installiert und global über Systemumgebungsvariablen zugänglich ist) im Stammverzeichnis des Projekts ausführen. Wie zuvor sollten Sie die Meldung sehen, dass der Server in der Konsole aktiv ist. Nachdem der Server ausgeführt wird, öffnen Sie einen Browser und besuchen Sie localhost:3000 in der URL-Leiste.

Sie sollten mit einer Fehlermeldung begrüßt werden, die besagt, dass Cannot GET / . Drücken Sie Strg + Umschalt + I unter Windows in Chrome, um die Entwicklerkonsole anzuzeigen. Dort sollten Sie sehen, dass wir einen 404 (Ressource nicht gefunden) haben. Das macht Sinn – wir haben dem Server nur gesagt, was er tun soll, wenn jemand localhost:3000/my-test-route besucht. Der Browser hat bei localhost:3000 nichts zu rendern (was localhost:3000/ mit einem Schrägstrich entspricht).

Wenn Sie sich das Terminalfenster ansehen, in dem der Server läuft, sollten keine neuen Daten vorhanden sein. Besuchen Sie jetzt localhost:3000/my-test-route in der URL-Leiste Ihres Browsers. Möglicherweise sehen Sie denselben Fehler in der Chrome-Konsole (weil der Browser den Inhalt zwischenspeichert und immer noch kein HTML zum Rendern hat), aber wenn Sie Ihr Terminal anzeigen, auf dem der Serverprozess ausgeführt wird, sehen Sie, dass die Rückruffunktion tatsächlich ausgelöst wurde und die Protokollnachricht wurde tatsächlich protokolliert.

Fahren Sie den Server mit Strg + C herunter.

Lassen Sie uns nun dem Browser etwas zum Rendern geben, wenn eine GET-Anfrage an diese Route gesendet wird, damit wir die Cannot GET / -Nachricht verlieren können. Ich nehme unser app.get() von früher und füge in der Callback-Funktion zwei Argumente hinzu. Denken Sie daran, dass die Callback-Funktion, die wir übergeben, hinter den Kulissen von Express aufgerufen wird und Express beliebige Argumente hinzufügen kann. Es fügt tatsächlich zwei hinzu (naja, technisch gesehen drei, aber das werden wir später sehen), und obwohl beide extrem wichtig sind, kümmern wir uns im Moment nicht um das erste. Das zweite Argument heißt res , kurz für response , und ich greife darauf zu, indem ich undefined als ersten Parameter setze:

app.get('/my-test-route', (undefined, res) => { console.log('A GET Request was made to /my-test-route.'); }); Auch hier können wir das res -Argument beliebig nennen, aber res ist eine Konvention, wenn es um Express geht. res ist eigentlich ein Objekt, und darauf existieren verschiedene Methoden, um Daten an den Client zurückzusenden. In diesem Fall greife ich auf die auf res verfügbare Funktion send(...) zu, um HTML zurückzusenden, das der Browser rendert. Wir sind jedoch nicht auf das Zurücksenden von HTML beschränkt und können wählen, ob wir Text, ein JavaScript-Objekt, einen Stream (Streams sind besonders schön) oder was auch immer zurücksenden.

app.get('/my-test-route', (undefined, res) => { console.log('A GET Request was made to /my-test-route.'); res.send('<h1>Hello, World!</h1>'); }); Wenn Sie den Server herunterfahren und dann wieder hochfahren und dann Ihren Browser auf der /my-test-route aktualisieren, sehen Sie, wie der HTML-Code gerendert wird.

Auf der Registerkarte "Netzwerk" der Chrome-Entwicklertools können Sie diese GET-Anforderung mit mehr Details anzeigen, da sie sich auf Header bezieht.

An diesem Punkt wird es uns guttun, etwas über Express Middleware zu lernen – Funktionen, die global ausgelöst werden können, nachdem ein Client eine Anfrage gestellt hat.

Express-Middleware

Express bietet Methoden zum Definieren benutzerdefinierter Middleware für Ihre Anwendung. Tatsächlich wird die Bedeutung von Express Middleware am besten in den Express-Dokumenten hier definiert)

Middleware -Funktionen sind Funktionen, die Zugriff auf das Anforderungsobjekt (

req), das Antwortobjekt (res) und die nächste Middleware-Funktion im Anforderungs-Antwort-Zyklus der Anwendung haben. Die next-Middleware-Funktion wird üblicherweise durch eine Variable namensnextbezeichnet.

Middleware-Funktionen können die folgenden Aufgaben ausführen:

- Führen Sie einen beliebigen Code aus.

- Nehmen Sie Änderungen an den Anforderungs- und Antwortobjekten vor.

- Beenden Sie den Request-Response-Zyklus.

- Rufen Sie die nächste Middleware-Funktion im Stack auf.

Mit anderen Worten, eine Middleware-Funktion ist eine benutzerdefinierte Funktion, die wir (der Entwickler) definieren können und die zwischen dem Empfang der Anfrage durch Express und dem Auslösen unserer entsprechenden Callback-Funktion als Vermittler fungiert. Wir könnten beispielsweise eine log erstellen, die jedes Mal protokolliert, wenn eine Anfrage gestellt wird. Beachten Sie, dass wir diese Middleware-Funktionen auch auslösen lassen können, nachdem unser Endpunkt ausgelöst wurde, je nachdem, wo Sie ihn im Stapel platzieren – etwas, das wir später sehen werden.

Um benutzerdefinierte Middleware zu spezifizieren, müssen wir sie als Funktion definieren und an app.use(...) .

const myMiddleware = (req, res, next) => { console.log(`Middleware has fired at time ${Date().now}`); next(); } app.use(myMiddleware); // This is the app variable returned from express().Alles zusammen haben wir jetzt:

// Getting the module from node_modules. const express = require('express'); // Creating our Express Application. const app = express(); // Our middleware function. const myMiddleware = (req, res, next) => { console.log(`Middleware has fired at time ${Date().now}`); next(); } // Tell Express to use the middleware. app.use(myMiddleware); // Defining the port we'll bind to. const PORT = 3000; // Defining a new endpoint behind the "/my-test-route" route. app.get('/my-test-route', () => { console.log('A GET Request was made to /my-test-route.'); }); // Binding the server to port 3000. app.listen(PORT, () => { console.log(`Server is up on port ${PORT}.`) }); Wenn Sie die Anfragen erneut über den Browser stellen, sollten Sie jetzt sehen, dass Ihre Middleware-Funktion Zeitstempel auslöst und protokolliert. Um das Experimentieren zu fördern, versuchen Sie, den Aufruf der next Funktion zu entfernen, und sehen Sie, was passiert.

Die Middleware-Callback-Funktion wird mit drei Argumenten aufgerufen, req , res und next . req ist der Parameter, den wir beim Erstellen des GET-Handlers früher übersprungen haben, und es ist ein Objekt, das Informationen über die Anfrage enthält, wie Header, benutzerdefinierte Header, Parameter und jeden Körper, der möglicherweise vom Client gesendet wurde (wie z Sie tun dies mit einer POST-Anforderung). Ich weiß, dass wir hier über Middleware sprechen, aber sowohl die Endpunkte als auch die Middleware-Funktion werden mit req und res aufgerufen. req und res sind sowohl in der Middleware als auch im Endpunkt im Rahmen einer einzigen Anfrage vom Client gleich (es sei denn, das eine oder andere ändert es). Das heißt, Sie könnten beispielsweise eine Middleware-Funktion verwenden, um Daten zu bereinigen, indem Sie alle Zeichen entfernen, die möglicherweise darauf abzielen, SQL- oder NoSQL-Injektionen auszuführen, und dann die sichere req an den Endpunkt übergeben.

res ermöglicht es Ihnen, wie bereits erwähnt, auf verschiedene Arten, Daten an den Client zurückzusenden.

next ist eine Callback-Funktion, die Sie ausführen müssen, wenn die Middleware ihre Arbeit beendet hat, um die nächste Middleware-Funktion im Stack oder am Endpunkt aufzurufen. Beachten Sie unbedingt, dass Sie dies im then -Block aller asynchronen Funktionen aufrufen müssen, die Sie in der Middleware auslösen. Abhängig von Ihrem asynchronen Vorgang möchten Sie ihn möglicherweise im catch -Block aufrufen oder nicht. Das heißt, die myMiddleware Funktion wird ausgelöst, nachdem die Anforderung vom Client gestellt wurde, aber bevor die Endpunktfunktion der Anforderung ausgelöst wird. Wenn wir diesen Code ausführen und eine Anfrage stellen, sollte in der Konsole die Meldung Middleware has fired... vor der Meldung A GET Request was made to... angezeigt werden. Wenn Sie next() nicht aufrufen, wird der letzte Teil nie ausgeführt – Ihre Endpunktfunktion für die Anfrage wird nicht ausgelöst.

Beachten Sie auch, dass ich diese Funktion als solche auch anonym hätte definieren können (eine Konvention, an die ich mich halten werde):

app.use((req, res, next) => { console.log(`Middleware has fired at time ${Date().now}`); next(); }); Für alle, die neu in JavaScript und ES6 sind, sollte das folgende Beispiel helfen, wenn die Art und Weise, wie das obige funktioniert, nicht sofort sinnvoll ist. Wir definieren einfach eine Callback-Funktion (die anonyme Funktion), die eine andere Callback-Funktion ( next ) als Argument akzeptiert. Wir nennen eine Funktion, die ein Funktionsargument übernimmt, eine Funktion höherer Ordnung. Betrachten Sie es auf die folgende Weise – es zeigt ein grundlegendes Beispiel dafür, wie der Express-Quellcode hinter den Kulissen funktionieren könnte:

console.log('Suppose a request has just been made from the client.\n'); // This is what (it's not exactly) the code behind app.use() might look like. const use = callback => { // Simple log statement to see where we are. console.log('Inside use() - the "use" function has been called.'); // This depicts the termination of the middleware. const next = () => console.log('Terminating Middleware!\n'); // Suppose req and res are defined above (Express provides them). const req = res = null; // "callback" is the "middleware" function that is passed into "use". // "next" is the above function that pretends to stop the middleware. callback(req, res, next); }; // This is analogous to the middleware function we defined earlier. // It gets passed in as "callback" in the "use" function above. const myMiddleware = (req, res, next) => { console.log('Inside the myMiddleware function!'); next(); } // Here, we are actually calling "use()" to see everything work. use(myMiddleware); console.log('Moving on to actually handle the HTTP Request or the next middleware function.'); Wir rufen zuerst use , was myMiddleware als Argument verwendet. myMiddleware ist an und für sich eine Funktion, die drei Argumente akzeptiert – req , res und next . Innerhalb von use wird myMiddlware aufgerufen, und diese drei Argumente werden übergeben. Als next folgt eine in use definierte Funktion. myMiddleware ist als callback in der use -Methode definiert. Wenn ich use in diesem Beispiel auf ein Objekt namens app gesetzt hätte, hätten wir das Setup von Express vollständig nachahmen können, wenn auch ohne Sockets oder Netzwerkkonnektivität.

In diesem Fall sind sowohl myMiddleware als auch callback Funktionen höherer Ordnung, da sie beide Funktionen als Argumente annehmen.

Wenn Sie diesen Code ausführen, sehen Sie die folgende Antwort:

Suppose a request has just been made from the client. Inside use() - the "use" function has been called. Inside the middleware function! Terminating Middleware! Moving on to actually handle the HTTP Request or the next middleware function.Beachten Sie, dass ich auch anonyme Funktionen hätte verwenden können, um das gleiche Ergebnis zu erzielen:

console.log('Suppose a request has just been made from the client.'); // This is what (it's not exactly) the code behind app.use() might look like. const use = callback => { // Simple log statement to see where we are. console.log('Inside use() - the "use" function has been called.'); // This depicts the termination of the middlewear. const next = () => console.log('Terminating Middlewear!'); // Suppose req and res are defined above (Express provides them). const req = res = null; // "callback" is the function which is passed into "use". // "next" is the above function that pretends to stop the middlewear. callback(req, res, () => { console.log('Terminating Middlewear!'); }); }; // Here, we are actually calling "use()" to see everything work. use((req, res, next) => { console.log('Inside the middlewear function!'); next(); }); console.log('Moving on to actually handle the HTTP Request.');Nachdem das hoffentlich geklärt ist, können wir uns nun der eigentlichen Aufgabe zuwenden – dem Einrichten unserer Middleware.

Tatsache ist, dass Sie Daten normalerweise über eine HTTP-Anforderung senden müssen. Dazu haben Sie einige verschiedene Möglichkeiten – Senden von URL-Abfrageparametern, Senden von Daten, auf die über das req -Objekt zugegriffen werden kann, von dem wir zuvor erfahren haben, usw. Dieses Objekt ist nicht nur im Callback zum Aufrufen von app.use() , sondern auch an jeden beliebigen Endpunkt. Wir haben zuvor undefined als Füllelement verwendet, damit wir uns auf res konzentrieren konnten, um HTML an den Client zurückzusenden, aber jetzt brauchen wir Zugriff darauf.

app.use('/my-test-route', (req, res) => { // The req object contains client-defined data that is sent up. // The res object allows the server to send data back down. });HTTP-POST-Anforderungen erfordern möglicherweise , dass wir ein Body-Objekt an den Server senden. Wenn Sie ein Formular auf dem Client haben und den Namen und die E-Mail-Adresse des Benutzers verwenden, werden Sie diese Daten wahrscheinlich im Text der Anfrage an den Server senden.

Schauen wir uns an, wie das auf der Client-Seite aussehen könnte:

<!DOCTYPE html> <html> <body> <form action="https://localhost:3000/email-list" method="POST" > <input type="text" name="nameInput"> <input type="email" name="emailInput"> <input type="submit"> </form> </body> </html>Auf der Serverseite:

app.post('/email-list', (req, res) => { // What do we now? // How do we access the values for the user's name and email? }); Um auf den Namen und die E-Mail-Adresse des Benutzers zuzugreifen, müssen wir eine bestimmte Art von Middleware verwenden. Dadurch werden die Daten in einem Objekt namens body available on req . Body Parser war eine beliebte Methode, dies zu tun, die von den Express-Entwicklern als eigenständiges NPM-Modul verfügbar war. Jetzt wird Express mit seiner eigenen Middleware vorinstalliert, um dies zu tun, und wir nennen es so:

app.use(express.urlencoded({ extended: true }));Jetzt können wir tun:

app.post('/email-list', (req, res) => { console.log('User Name: ', req.body.nameInput); console.log('User Email: ', req.body.emailInput); }); Dies nimmt lediglich alle benutzerdefinierten Eingaben entgegen, die vom Client gesendet werden, und stellt sie im body -Objekt von req zur Verfügung. Beachten Sie, dass wir bei req.body jetzt nameInput und emailInput haben, die die Namen der input Tags im HTML-Code sind. Nun, diese clientdefinierten Daten sollten als gefährlich betrachtet werden (vertraue niemals dem Client) und müssen bereinigt werden, aber dazu kommen wir später.

Eine andere Art von Middleware, die von express bereitgestellt wird, ist express.json() . express.json wird verwendet, um alle JSON-Nutzlasten zu verpacken, die in einer Anfrage vom Client an req.body werden, während express.urlencoded alle eingehenden Anfragen mit Zeichenfolgen, Arrays oder anderen URL-codierten Daten an req.body . Kurz gesagt, beide manipulieren req.body , aber .json() ist für JSON-Payloads und .urlencoded() ist unter anderem für POST-Abfrageparameter.

Anders gesagt, eingehende Anfragen mit einem Content-Type: application/json -Header (z. B. die Angabe eines POST-Bodys mit der fetch -API) werden von express.json() verarbeitet, während Anfragen mit dem Header Content-Type: application/x-www-form-urlencoded (wie HTML-Formulare) wird mit express.urlencoded() behandelt. Das macht jetzt hoffentlich Sinn.

Starten unserer CRUD-Routen für MongoDB

Hinweis : Bei der Durchführung von PATCH-Anforderungen in diesem Artikel halten wir uns nicht an die JSONPatch-RFC-Spezifikation – ein Problem, das wir im nächsten Artikel dieser Serie beheben werden.

In Anbetracht dessen, dass wir verstehen, dass wir jeden Endpunkt spezifizieren, indem wir die relevante Funktion auf app aufrufen, ihr die Route und eine Callback-Funktion übergeben, die die Anfrage- und Antwortobjekte enthält, können wir damit beginnen, unsere CRUD-Routen für die Bookshelf-API zu definieren. In Anbetracht der Tatsache, dass dies ein einführender Artikel ist, werde ich mich weder darum kümmern, die HTTP- und REST-Spezifikationen vollständig zu befolgen, noch werde ich versuchen, die sauberste mögliche Architektur zu verwenden. Das kommt in einem zukünftigen Artikel.

Ich öffne die server.js -Datei, die wir bisher verwendet haben, und entleere alles, um mit der folgenden sauberen Tafel zu beginnen:

// Getting the module from node_modules. const express = require('express'); // This creates our Express App. const app = express(); // Define middleware. app.use(express.json()); app.use(express.urlencoded({ extended: true )); // Listening on port 3000 (arbitrary). // Not a TCP or UDP well-known port. // Does not require superuser privileges. const PORT = 3000; // We will build our API here. // ... // Binding our application to port 3000. app.listen(PORT, () => console.log(`Server is up on port ${PORT}.`)); Betrachten Sie den gesamten folgenden Code, um den Teil // ... der obigen Datei aufzunehmen.

Um unsere Endpunkte zu definieren, und weil wir eine REST-API erstellen, sollten wir die richtige Methode zum Benennen von Routen besprechen. Auch hier sollten Sie sich den HTTP-Abschnitt meines früheren Artikels ansehen, um weitere Informationen zu erhalten. Wir haben es mit Büchern zu tun, daher befinden sich alle Routen hinter /books (die Plural-Namenskonvention ist Standard).

| Anfrage | Route |

|---|---|

| POST | /books |

| BEKOMMEN | /books/id |

| PATCH | /books/id |

| LÖSCHEN | /books/id |

Wie Sie sehen, muss beim POSTen eines Buchs keine ID angegeben werden, da wir (oder vielmehr MongoDB) sie serverseitig automatisch für uns generieren werden. Das Abrufen, PATCHen und Löschen von Büchern erfordert alle, dass wir diese ID an unseren Endpunkt übergeben, was wir später besprechen werden. Lassen Sie uns zunächst einfach die Endpunkte erstellen:

// HTTP POST /books app.post('/books', (req, res) => { // ... console.log('A POST Request was made!'); }); // HTTP GET /books/:id app.get('/books/:id', (req, res) => { // ... console.log(`A GET Request was made! Getting book ${req.params.id}`); }); // HTTP PATCH /books/:id app.patch('/books/:id', (req, res) => { // ... console.log(`A PATCH Request was made! Updating book ${req.params.id}`); }); // HTTP DELETE /books/:id app.delete('/books/:id', (req, res) => { // ... console.log(`A DELETE Request was made! Deleting book ${req.params.id}`); }); Die :id Syntax teilt Express mit, dass id ein dynamischer Parameter ist, der in der URL weitergegeben wird. Wir haben Zugriff darauf über das params Objekt, das auf req verfügbar ist. Ich weiß, dass „wir haben auf req Zugriff darauf“ klingt wie Zauberei, und Zauberei (die es nicht gibt) ist beim Programmieren gefährlich, aber Sie müssen bedenken, dass Express keine Blackbox ist. Es ist ein Open-Source-Projekt, das auf GitHub unter einer MIT-Lizenz verfügbar ist. Sie können den Quellcode einfach anzeigen, wenn Sie sehen möchten, wie dynamische Abfrageparameter in das req -Objekt eingefügt werden.

Alles in allem haben wir jetzt Folgendes in unserer server.js -Datei:

// Getting the module from node_modules. const express = require('express'); // This creates our Express App. const app = express(); // Define middleware. app.use(express.json()); app.use(express.urlencoded({ extended: true })); // Listening on port 3000 (arbitrary). // Not a TCP or UDP well-known port. // Does not require superuser privileges. const PORT = 3000; // We will build our API here. // HTTP POST /books app.post('/books', (req, res) => { // ... console.log('A POST Request was made!'); }); // HTTP GET /books/:id app.get('/books/:id', (req, res) => { // ... console.log(`A GET Request was made! Getting book ${req.params.id}`); }); // HTTP PATCH /books/:id app.patch('/books/:id', (req, res) => { // ... console.log(`A PATCH Request was made! Updating book ${req.params.id}`); }); // HTTP DELETE /books/:id app.delete('/books/:id', (req, res) => { // ... console.log(`A DELETE Request was made! Deleting book ${req.params.id}`); }); // Binding our application to port 3000. app.listen(PORT, () => console.log(`Server is up on port ${PORT}.`)); Fahren Sie fort und starten Sie den Server, führen node server.js über das Terminal oder die Befehlszeile aus und besuchen Sie Ihren Browser. Öffnen Sie die Chrome-Entwicklungskonsole und besuchen Sie in der URL-Leiste (Uniform Resource Locator) localhost:3000/books . Sie sollten bereits die Anzeige im Terminal Ihres Betriebssystems sehen, dass der Server aktiv ist, sowie die Protokollanweisung für GET.

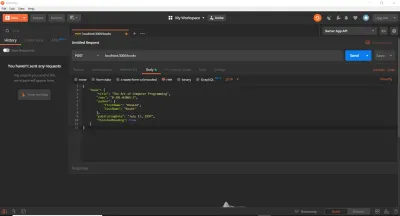

Bisher haben wir einen Webbrowser verwendet, um GET-Anforderungen auszuführen. Das ist gut für den Anfang, aber wir werden schnell feststellen, dass es bessere Tools zum Testen von API-Routen gibt. Tatsächlich könnten wir fetch direkt in die Konsole einfügen oder einen Onlinedienst verwenden. In unserem Fall und um Zeit zu sparen, verwenden wir cURL und Postman. Ich verwende beide in diesem Artikel (obwohl Sie entweder oder verwenden könnten), damit ich sie vorstellen kann, falls Sie sie noch nicht verwendet haben. cURL ist eine Bibliothek (eine sehr, sehr wichtige Bibliothek) und ein Befehlszeilentool, das entwickelt wurde, um Daten mit verschiedenen Protokollen zu übertragen. Postman ist ein GUI-basiertes Tool zum Testen von APIs. Nachdem Sie die entsprechenden Installationsanweisungen für beide Tools auf Ihrem Betriebssystem befolgt haben, stellen Sie sicher, dass Ihr Server noch läuft, und führen Sie dann die folgenden Befehle (nacheinander) in einem neuen Terminal aus. Es ist wichtig, dass Sie sie einzeln eingeben und ausführen und dann die Protokollnachricht im separaten Terminal Ihres Servers ansehen. Beachten Sie außerdem, dass das Kommentarsymbol der Standardprogrammiersprache // kein gültiges Symbol in Bash oder MS-DOS ist. Sie müssen diese Zeilen weglassen, und ich verwende sie hier nur, um jeden Block von cURL -Befehlen zu beschreiben.

// HTTP POST Request (Localhost, IPv4, IPv6) curl -X POST https://localhost:3000/books curl -X POST https://127.0.0.1:3000/books curl -X POST https://[::1]:3000/books // HTTP GET Request (Localhost, IPv4, IPv6) curl -X GET https://localhost:3000/books/123abc curl -X GET https://127.0.0.1:3000/books/book-id-123 curl -X GET https://[::1]:3000/books/book-abc123 // HTTP PATCH Request (Localhost, IPv4, IPv6) curl -X PATCH https://localhost:3000/books/456 curl -X PATCH https://127.0.0.1:3000/books/218 curl -X PATCH https://[::1]:3000/books/some-id // HTTP DELETE Request (Localhost, IPv4, IPv6) curl -X DELETE https://localhost:3000/books/abc curl -X DELETE https://127.0.0.1:3000/books/314 curl -X DELETE https://[::1]:3000/books/217 Wie Sie sehen können, kann die als URL-Parameter übergebene ID ein beliebiger Wert sein. Das Flag -X gibt den Typ der HTTP-Anfrage an (kann bei GET weggelassen werden), und wir geben die URL an, an die die Anfrage danach gestellt wird. Ich habe jede Anfrage dreimal dupliziert, sodass Sie sehen können, dass alles immer noch funktioniert, unabhängig davon, ob Sie den localhost Hostnamen, die IPv4-Adresse ( 127.0.0.1 ), in die localhost aufgelöst wird, oder die IPv6-Adresse ( ::1 ), in die localhost aufgelöst wird, verwenden . Beachten Sie, dass cURL IPv6-Adressen in eckige Klammern setzen muss.

Wir sind jetzt an einem anständigen Ort – wir haben die einfache Struktur unserer Routen und Endpunkte eingerichtet. Der Server läuft korrekt und akzeptiert HTTP-Anforderungen so, wie wir es erwarten. Im Gegensatz zu dem, was Sie vielleicht erwarten, ist es an dieser Stelle nicht mehr weit – wir müssen nur unsere Datenbank einrichten, sie hosten (mithilfe eines Database-as-a-Service – MongoDB Atlas) und Daten darauf speichern (und Validierung durchführen und Fehlerantworten erstellen).

Einrichten einer Produktions-MongoDB-Datenbank

Um eine Produktionsdatenbank einzurichten, gehen wir zur MongoDB Atlas-Startseite und melden uns für ein kostenloses Konto an. Erstellen Sie danach einen neuen Cluster. Sie können die Standardeinstellungen beibehalten und eine für die Gebührenstufe geltende Region auswählen. Klicken Sie dann auf die Schaltfläche „Cluster erstellen“. Das Erstellen des Clusters dauert einige Zeit, und dann können Sie Ihre Datenbank-URL und Ihr Kennwort abrufen. Beachten Sie diese, wenn Sie sie sehen. Wir werden sie vorerst fest codieren und später aus Sicherheitsgründen in Umgebungsvariablen speichern. Wenn Sie Hilfe beim Erstellen und Herstellen einer Verbindung zu einem Cluster benötigen, verweise ich Sie auf die MongoDB-Dokumentation, insbesondere auf diese Seite und diese Seite, oder Sie können unten einen Kommentar hinterlassen, und ich werde versuchen, Ihnen zu helfen.

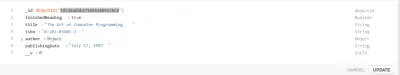

Erstellen eines Mongoose-Modells